Introduction

L'intelligence artificielle (IA) a révolutionné les industries, des soins de santé et de la finance à la vente au détail et à l'éducation. Sa capacité à analyser de vastes quantités de données, à prédire les tendances et à automatiser des processus complexes a positionné l'IA commesa force transformatrice.

Cependant, toutParallèlement à cette innovation rapide, la question de la confidentialité des données est devenue une préoccupation centrale à l’ère du numérique. Alors que les organisations s’appuient de plus en plus sur des systèmes d’IA, la protection des informations personnelles devient à la fois un défi et une responsabilité.

Comprendre l’intersection entre l’IA et la confidentialité des données

Dans un paysage numérique en constante évolution, la convergence de l’intelligence artificielle (IA) et de la confidentialité des données est devenue un point central d’innovation et de préoccupation. Alors que les systèmes d’IA s’intègrent de plus en plus dans notre vie quotidienne, il est primordial de comprendre leurs implications sur la confidentialité des données.

Définition de l'IA et de la confidentialité des donnéeset

L'IA désigne le développement de systèmes capables d'effectuer des tâches qui nécessitent généralement une intelligence humaine, comme la prise de décision et la reconnaissance de formes. La confidentialité des données, quant à elle, vise à protéger les informations personnelles contre tout accès non autorisé et toute utilisation abusive.

Comment les systèmes d’IA collectent, traitent et utiliser données personnelles

Les systèmes d’IA s’appuient souvent sur de grands ensembles de données pour fonctionner efficacement. Par exemple, algorithmes de recommandation dans les plateformes de commerce électronique analyser les historiques de navigation et d’achat pour offrir des expériences d’achat personnalisées. Cependant, cette dépendance aux données personnelles soulève des inquiétudes en matière de transparence, de consentement et d’utilisation abusive des données.

La relation symbiotique entre les avancées de l’IA et la protection des données

L’IA peut être à la fois une menace et une solution pour la confidentialité des données. D’un côté, elle présente des risques en exposant potentiellement des informations sensibles à des violations ou à des utilisations abusives. D’un autre côté, les outils basés sur l’IA peuvent améliorer la protection de la vie privée grâce à la détection automatisée des menaces, à l’analyse des anomalies et à des techniques de traitement sécurisé des données.

L’intégration de l’IA dans divers domaines souligne la nécessité de cadres de protection des données solides. Des réglementations telles que le Règlement général sur la protection des données (RGPD) en Europe et le California Consumer Privacy Act (CCPA) aux États-Unis soulignent l’élan mondial en faveur d’une innovation soucieuse de la confidentialité. Les entreprises doivent adopter des pratiques d’IA responsables, en garantissant le respect de ces lois tout en préservant la confiance des utilisateurs.

Alors que l’IA continue de s’infiltrer dans divers aspects de la société, il demeure impératif de répondre aux préoccupations en matière de confidentialité des données. En mettant en œuvre des technologies qui préservent la confidentialité et en adhérant aux normes réglementaires, il est possible de tirer parti des avantages de l’IA tout en préservant la vie privée des individus.

L'impact de l'IA sur la confidentialité des données

L’intégration de l’intelligence artificielle (IA) dans notre vie quotidienne apporte de nombreux avantages, mais suscite également des inquiétudes quant à la confidentialité des données. Comprendre ce double impact est essentiel pour favoriser un environnement numérique sûr et éthique.

Avantages de l'IA dans l'analyse des données et la prise de décision

Les systèmes d’IA améliorent l’analyse des données et les processus de prise de décision, permettant aux organisations de identifier tendances, prédire les comportements et automatiser les flux de travail complexes. Par exemple, les systèmes de santé basés sur l’IA peuvent analyser les données des patients pour prédire les maladies à un stade précoce, améliorant ainsi les résultats et sauvant des vies. De même, dans le secteur financier, L'IA détecte les activités frauduleuses avec une précision impressionnante.

Risques et défis potentiels posés par l’IA pour la sécurité des données personnelles

Malgré ses avantages, l’IA présente des risques importants pour la confidentialité des données. Les modèles d’IA nécessitent souvent de grandes quantités de données personnelles pour leur formation, ce qui crée des vulnérabilités. Des incidents comme le scandale Cambridge Analytica illustrent comment l’IA peut être exploitée pour manipuler les données des utilisateurs à des fins politiques ou financières (James Clayton, 2021)

Études de cas illustrant les impacts positifs et négatifs

Le application de l'IA dans divers domaines a conduit à la fois à des avancées louables et à des défis notables en matière de confidentialité des données.

Impact positif : conception de plans d'étage alimentée par l'IA

Un exemple notable est le développement d'une plateforme pilotée par l'IA qui permet aux utilisateurs de créer efficacement des plans d'étage détaillés et des conceptions de maisons en 3D. Cette technologie rationalise le processus de conception, le rendant plus accessible aux professionnels et aux propriétaires. tirer parti IA, la plateforme s'adapte à divers facteurs environnementaux et aux entrées des utilisateurs, garantissant précision et convivialité (Développement intelligent, 2024).

Impact négatif : la controverse sur la confidentialité des données de Clearview AI

À l’inverse, le cas de Clearview AI met en évidence d’importantes préoccupations en matière de confidentialité des données. Clearview AI a développé un système de reconnaissance faciale en récupérant des milliards d’images sur Internet sans le consentement des individus. Cette pratique a donné lieu à des contestations judiciaires et à des amendes dans plusieurs pays, notamment une amende de 30,5 millions d’euros imposée par l’Autorité néerlandaise de protection des données pour violation des lois sur la confidentialité (Autoriteit Persoonsgegevens, 2024).

Alors que l’IA continue de pénétrer divers aspects de la société, répondre aux préoccupations en matière de confidentialité des données restes impératif. En mettant en œuvre des technologies préservant la vie privée et en adhérant aux normes réglementaires, il est possible d’exploiter les avantages de l’IA tout en préservant la vie privée des individus.

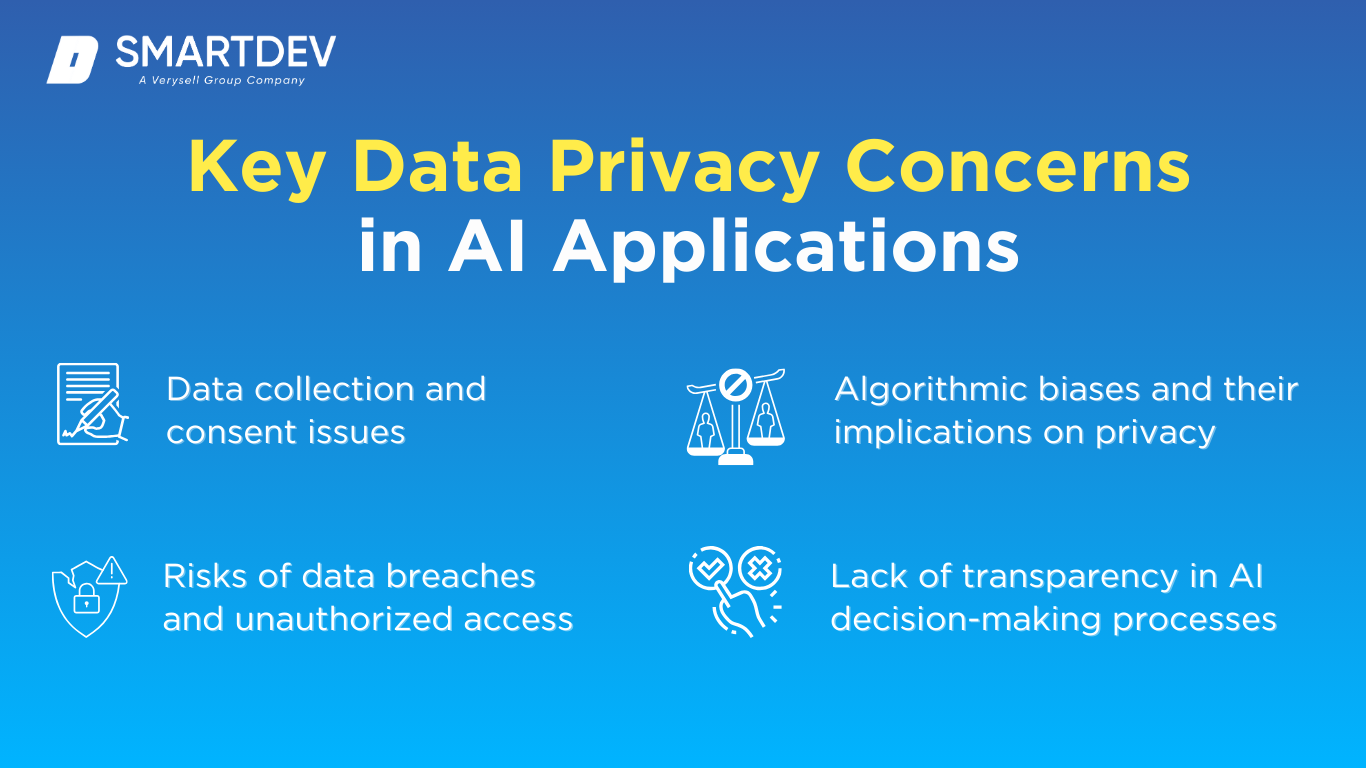

Principales préoccupations en matière de confidentialité des données dans les applications d’IA

À mesure que les systèmes d'IA se généralisent dans divers secteurs, plusieurs préoccupations cruciales liées à la confidentialité des données sont apparues. Ces problèmes soulignent la nécessité d'un développement éthique de l'IA et de pratiques transparentes pour protéger les droits des individus et la sécurité des données.

Collecte de données et questions de consentement

Les systèmes d’IA dépendent largement des données pour fonctionner efficacement. Cependant, la collecte de ces données soulève souvent des inquiétudes quant au consentement et à la transparence. De nombreuses applications basées sur l’IA collectent des informations personnelles sans fournir aux utilisateurs des informations adéquates sur la manière dont leurs données seront utilisées.

Par exemple, la controverse entourant les applications comme TikTok qui collectent des données sur les utilisateurs sans divulgation suffisante a suscité des critiques à l'échelle mondiale. Des inquiétudes ont été soulevées quant au partage potentiel des données des utilisateurs avec des organisations tierces sans leur consentement (Jane Wakefield, 2021).

Risques de violation de données et d'accès non autorisé

La centralisation des données personnelles dans les systèmes d’IA présente un risque important de violation de données et d’accès non autorisé. Les pirates informatiques qui ciblent les bases de données d’IA peuvent accéder à des informations sensibles, ce qui peut entraîner des vols d’identité, des fraudes financières et des atteintes à la réputation des organisations concernées.

La violation de données d'Equifax en 2017, par exemple, a exposé les données personnelles de 147 millions d'Américains, mettant en évidence les effets dévastateurs de mesures de protection des données inadéquates. Cet événement a donné lieu à une surveillance accrue et à un règlement de 1470 millions de livres sterling avec les autorités de régulation ((Actualités de la FTC, 2024).

Les biais algorithmiques et leurs implications sur la vie privée

Les biais algorithmiques se produisent lorsque les modèles d'IA apprennent par inadvertance et reproduisent les biais présents dans leurs données d'entraînement. Cela peut entraîner des résultats discriminatoires qui ont un impact disproportionné sur certains groupes.

En savoir plus : Tests de modèles d'IA : le guide ultime en 2025

Par exemple, une étude a révélé que l’outil de recrutement d’IA d’Amazon présentait un biais à l’encontre des femmes, car il était formé sur des ensembles de données dominés par les hommes (Jeffrey Dastin, 2018). De tels préjugés non seulement violent les normes éthiques, mais risquent également de porter atteinte aux droits des individus à la vie privée et à l’égalité.

Manque de transparence dans les processus de prise de décision de l'IA

Les systèmes d’IA fonctionnent souvent comme des « boîtes noires », prenant des décisions sans explications claires sur la manière dont elles ont été prises. Ce manque de transparence pose des défis considérables dans des domaines tels que la finance, la santé et l’application de la loi.

Par exemple, les systèmes d'évaluation du crédit basés sur l'IA, comme ceux utilisés par FICO, peuvent rejeter des demandes de prêt sans fournir aux demandeurs de raisons compréhensibles. initiatives d'IA explicable (XAI), qui donnent la priorité à des processus de prise de décision de l’IA plus transparents.

Paysage réglementaire régissant l'IA et la confidentialité des données

Les gouvernements et les organisations du monde entier reconnaissent de plus en plus l’importance de réglementer les technologies d’IA pour protéger la confidentialité des données. Un cadre réglementaire complet est essentiel pour garantir que le développement de l’IA soit conforme aux normes éthiques et juridiques.

Aperçu des réglementations mondiales en matière de protection des données (par exemple, RGPD, CCPA)

Le Règlement général sur la protection des données (RGPD) dans l'Union européenne et la loi californienne sur la protection de la vie privée des consommateurs (CCPA) Aux États-Unis, deux réglementations importantes mettent l’accent sur la confidentialité des données.

- Le RGPD impose des règles strictes, telles que le droit à la portabilité des données, le droit à l'oubli et les notifications obligatoires de violation dans les 72 heures (Portail RGPD).

- De même, le CCPA donne aux résidents de Californie le droit de savoir quelles données personnelles sont collectées, de demander leur suppression et de refuser leur vente (Département de la Justice de Californie, 2024).

Nouvelles législations et directives spécifiques à l'IA

Au-delà des lois générales sur la protection des données, les gouvernements commencent à élaborer des réglementations spécifiques à l'IA. Par exemple, la loi de l'Union européenne Loi sur l'intelligence artificielle cherche à catégoriser les systèmes d'IA en fonction des niveaux de risque, en imposant une conformité plus stricte pour les applications à haut risque comme l'identification biométrique (Commission européenne, 2024)

Aux États-Unis, le Loi sur la responsabilité algorithmique a été introduite pour obliger les entreprises à évaluer les impacts des systèmes de décision automatisés, y compris les risques potentiels liés à la confidentialité et aux préjugés (Congrès, 2022).

Exigences de conformité pour les organisations déployant des technologies d'IA

Les organisations qui mettent en œuvre des technologies d’IA doivent respecter plusieurs exigences de conformité :

- Conduite Évaluations d'impact relatives à la protection des données (AIPD) identifier les risques

- Nomination Délégués à la protection des données (DPD) pour assurer une conformité continue.

- Exécution confidentialité dès la conception pratiques lors du développement des systèmes d’IA.

Ces mesures aident non seulement les organisations à éviter les pénalités, mais également à renforcer la confiance avec leurs parties prenantes.

Bonnes pratiques pour garantir la confidentialité des données dans les systèmes d'IA

Pour protéger les informations sensibles et maintenir la confiance des utilisateurs, les organisations qui déploient des systèmes d’IA doivent adopter des pratiques robustes qui intègrent la protection de la confidentialité à chaque étape du cycle de vie de l’IA.

Techniques de minimisation et d'anonymisation des données

Minimisation des données L'anonymisation garantit que seule la quantité de données nécessaire est collectée et traitée pour que les systèmes d'IA fonctionnent efficacement. En réduisant la portée de la collecte de données, les organisations limitent leur exposition aux violations et aux abus. Les techniques d'anonymisation, telles que la suppression des informations personnelles identifiables (PII) ou l'utilisation de pseudonymes, protègent davantage la confidentialité des utilisateurs en rendant les ensembles de données non identifiables. Un exemple de cette approche est l'utilisation par Google de la confidentialité différentielle dans des outils comme Google Maps, où les données des utilisateurs sont anonymisées pour préserver la confidentialité tout en permettant des fonctionnalités.

Audits et évaluations réguliers des systèmes d'IA pour la conformité

Les organisations doivent procéder à des audits réguliers de leurs systèmes d’IA pour garantir leur conformité avec les réglementations en vigueur en matière de confidentialité des données. Cela comprend l’évaluation des pratiques de stockage des données, la garantie de la transparence du traitement des données et l’identification des vulnérabilités potentielles. Par exemple, les audits internes peuvent aider à détecter si un système d’IA collecte par inadvertance plus de données que prévu, enfreignant ainsi les principes de minimisation des données.

Programmes de formation et de sensibilisation des employés sur la confidentialité des données

L'erreur humaine reste l'une des causes les plus courantes de violations de données. Des programmes réguliers de formation et de sensibilisation garantissent que les employés comprennent l'importance de la confidentialité des données et adhèrent aux meilleures pratiques. Par exemple, en dotant les équipes de connaissances sur les attaques de phishing, la gestion sécurisée des données et L’éthique de l’IA favorise une culture de responsabilitéLes organisations peuvent également mettre en œuvre des programmes de certification obligatoires pour les équipes travaillant avec des données sensibles.

Solutions technologiques pour améliorer la confidentialité des données de l'IA

Les avancées technologiques émergentes offrent des outils puissants pour protéger la confidentialité des données dans les systèmes d'IAEn intégrant ces technologies, les organisations peuvent encore améliorer la sécurité et renforcer la confiance des utilisateurs.

Adoption de méthodes de cryptage avancées

Les techniques de chiffrement telles que le chiffrement homomorphe permettent de traiter les données sans les déchiffrer, ce qui améliore considérablement la confidentialité des données. Par exemple, les modèles d’IA peuvent effectuer des calculs sur des ensembles de données chiffrés sans jamais exposer les données sous-jacentes. Cela est particulièrement utile dans des secteurs comme la santé, où les informations sensibles des patients doivent rester confidentielles. IBM et Microsoft ont exploré le chiffrement homomorphe pour garantir un traitement sécurisé des données dans leurs projets d’IA.

Utilisation de l'apprentissage fédéré pour maintenir la décentralisation des données

L'apprentissage fédéré permet aux modèles d'IA de s'entraîner sur des données décentralisées sur plusieurs appareils sans les transférer vers un serveur central. Cette approche minimise le risque de violation des données et garantit la confidentialité dès la conception. Google a mis en œuvre l'apprentissage fédéré dans Gboard, son application de clavier mobile, pour entraîner des modèles de texte prédictif localement sur les appareils des utilisateurs sans centraliser les données sensibles (Recherche Google, 2024)

Techniques de confidentialité différentielles pour protéger les points de données individuels

La confidentialité différentielle consiste à ajouter du bruit statistique aux ensembles de données, ce qui rend presque impossible l'identification de points de données individuels. Cette technique est largement utilisée par des organisations comme Apple pour collecter des données utilisateur agrégées afin d'améliorer les services sans compromettre la confidentialité individuelle (Pomme)

Cadres de gouvernance de l'IA pour surveiller et contrôler les comportements de l'IA

Les cadres de gouvernance de l'IA établissent des lignes directrices pour surveiller et contrôler le comportement des systèmes d'IA. Ces cadres garantissent la responsabilité et la transparence en définissant des règles pour l'utilisation des données, l'atténuation des biais et les processus de prise de décision. Par exemple, le cadre de gouvernance de l'IA de Microsoft décrit les principes de création de systèmes d'IA responsables, notamment l'équité, la confidentialité et l'inclusivité (Microsoft)

L'avenir de l'IA et de la confidentialité des données

À mesure que la technologie de l’IA continue de progresser, ses implications sur la confidentialité des données vont devenir de plus en plus importantes. L’avenir de l’IA et de la confidentialité des données sera façonné par les innovations, les considérations éthiques et la nécessité d’une harmonisation réglementaire pour équilibrer la croissance technologique et la protection des utilisateurs.

Prédictions sur les avancées de l'IA et leur impact potentiel sur la vie privée

Prédictions sur les avancées de l'IA et leur impact potentiel sur la vie privée

Les technologies d’IA émergentes comme systèmes autonomesL’IA générative et le traitement amélioré du langage naturel nécessiteront des ensembles de données de plus en plus complexes pour la formation et l’exploitation. Si ces avancées offriront d’énormes avantages, elles introduiront également de nouveaux risques pour la vie privée. Par exemple :

- Véhicules autonomes:Collecter des quantités massives de données de localisation et de comportement en temps réel, ce qui soulève des inquiétudes quant à la surveillance et au suivi non autorisé.

- Modèles d'IA génératifs:Comme ChatGPT ou DALL-E, il peut exposer par inadvertance des données de formation sensibles si elles ne sont pas gérées avec soin.

Un rapport de McKinsey souligne que d'ici 2030, les systèmes basés sur l'IA géreront plus de 70% d'interactions avec les clients, obligeant les organisations à innover de manière responsable tout en protégeant la confidentialité des utilisateurs (McKinsey Digital, 2023).

Le rôle évolutif de la confidentialité des données dans l’éthique de l’IA

L’éthique de l’IA mettra de plus en plus l’accent sur la confidentialité des données comme pierre angulaire. Des concepts tels que la transparence, la responsabilité et l’équité sont étroitement liés à la protection de la vie privée. L’éthique du consentement dans la collecte de données de l’IA évoluera probablement, obligeant les systèmes à adopter des modèles plus dynamiques et centrés sur l’utilisateur, où les individus ont davantage de contrôle sur leurs données.

Les organisations devront également s'attaquer aux problèmes de biais algorithmiques et de discrimination, car le traitement éthique des données a un impact direct sur le développement équitable de l'IA. Des initiatives telles que l'initiative de l'UE Loi sur l'intelligence artificielle visent à intégrer la confidentialité dans les pratiques éthiques de l'IA (Commission européenne, 2023).

Stratégies pour équilibrer l'innovation avec une protection rigoureuse des données

Pour favoriser l’innovation tout en garantissant la protection des données, les organisations doivent :

- Investir dans les technologies améliorant la confidentialité (PET):Des techniques telles que l’apprentissage fédéré, la confidentialité différentielle et le calcul multipartite sécurisé joueront un rôle central.

- Développer des cadres réglementaires dynamiques:Les gouvernements et les organisations doivent créer des politiques adaptatives qui évoluent avec les avancées technologiques.

- Promouvoir les modèles de gouvernance collaborative:Les partenariats entre les secteurs privé et public peuvent normaliser les protocoles éthiques d’IA et de confidentialité à l’échelle mondiale.

L'engagement de SmartDev en matière de confidentialité des données dans l'IA

SmartDev s'est imposé comme un leader dans le développement d'IA sécurisée, démontrant ainsi son engagement à intégrer la confidentialité des données dans ses solutions. L'approche de l'entreprise vise à établir une relation de confiance avec ses clients tout en faisant progresser les pratiques responsables en matière d'IA.

L'approche de SmartDev pour intégrer la confidentialité des données dans les solutions d'IA

SmartDev adhère aux principes de confidentialité dès la conception, garantissant que les considérations de confidentialité des données sont intégrées à chaque étape du développement de l'IA. En exploitant des méthodes de chiffrement avancées, des techniques d'anonymisation robustes et des plateformes cloud sécurisées, SmartDev garantit la conformité aux réglementations mondiales telles que le RGPD et le CCPA.

Études de cas présentant les implémentations réussies de SmartDev

- Plateforme d'engagement médiatique pilotée par l'IA

SmartDev a développé une plateforme d'engagement médiatique pour un marché du journalisme et des relations publiques qui traite de grandes quantités de données utilisateurs. Pour garantir la confidentialité, SmartDev a mis en place des contrôles d'accès basés sur les rôles, garantissant que seul le personnel autorisé puisse accéder aux informations sensibles. La solution a considérablement amélioré la confiance et la conformité des utilisateurs.

- Outil de conception 3D et de plan d'étage alimenté par l'IA

Dans un autre cas, SmartDev a construit une plateforme d’IA permettant de créer des plans d’étage détaillés et des conceptions de maisons en 3D. Le système a rendu anonymes les données des utilisateurs et a intégré des techniques de confidentialité différentielle pour protéger les informations sensibles tout en offrant des résultats hautement personnalisés.

Initiatives et objectifs futurs pour promouvoir le développement d’une IA sécurisée

SmartDev s'engage à faire progresser le développement d'une IA sécurisée en répondant aux nouveaux défis liés à la confidentialité des données et en garantissant des pratiques éthiques dans ses solutions. Les initiatives futures de l'entreprise comprennent :

- Développer l'apprentissage fédéré

SmartDev prévoit d’intégrer l’apprentissage fédéré dans ses solutions, permettant aux modèles d’IA de s’entraîner sur des données décentralisées sans compromettre la confidentialité des utilisateurs. Cette approche sera particulièrement efficace dans les secteurs sensibles comme la santé et la finance.

- Renforcement de l'IA explicable (XAI)

Pour favoriser la transparence et la confiance, SmartDev vise à mettre en œuvre des techniques d’IA explicables, garantissant que les parties prenantes peuvent comprendre la logique derrière les décisions prises par l’IA. Cela comprendra le développement de tableaux de bord conviviaux pour visualiser les processus de prise de décision.

- Faire progresser la confidentialité différentielle

SmartDev va améliorer son utilisation des techniques de confidentialité différentielle, qui ajoutent du bruit statistique aux ensembles de données pour protéger les identités individuelles des utilisateurs. Ces techniques seront appliquées à toutes les plateformes axées sur le client pour garantir la confidentialité sans sacrifier les fonctionnalités.

- Collaborer à l’élaboration de la réglementation

SmartDev collaborera activement avec les décideurs politiques et les leaders du secteur pour contribuer à façonner les normes mondiales de confidentialité de l'IA, notamment en contribuant à des cadres tels que la loi européenne sur l'intelligence artificielle. Ces efforts permettront d'aligner l'innovation sur la conformité.

- Investir dans la recherche et le développement pour améliorer la confidentialité

L'entreprise prévoit de concentrer ses efforts de R&D sur des technologies de cryptage de pointe, telles que le cryptage homomorphe, pour garantir un traitement sécurisé des données. SmartDev étudiera également des méthodes de préservation de la confidentialité adaptées aux domaines à haut risque comme la santé.

Grâce à ces initiatives, SmartDev démontre son engagement en faveur du développement d’une IA éthique tout en équilibrant l’innovation avec une protection rigoureuse des données.

Conclusion,

L’intersection entre l’IA et la confidentialité des données est un domaine crucial où l’innovation doit s’aligner sur la responsabilité éthique. En intégrant la confidentialité des données à chaque étape du développement de l’IA, les organisations peuvent favoriser la confiance, se conformer aux réglementations et créer des solutions durables. L’approche proactive de SmartDev en matière d’IA sécurisée et transparente démontre son engagement à protéger la confidentialité des utilisateurs tout en proposant des technologies de pointe.

À mesure que l'IA continue de progresser, il est essentiel de s'associer à des experts qui accordent la priorité à la confidentialité des données. Si vous recherchez des solutions d'IA sur mesure qui accordent la priorité à la sécurité et à la conformité, Contactez SmartDev aujourd'hui pour découvrir comment nous pouvons vous aider à atteindre vos objectifs.

—-

RÉFÉRENCES

- Clayton, BJ (2021, 5 mai). Trump lance une nouvelle plateforme de « communication ». https://www.bbc.com/news/technology-56989500

- L'APD néerlandaise impose une amende à Clearview pour collecte illégale de données pour la reconnaissance faciale. (sd). Autoriteit Persoonsgegevens. https://www.autoriteitpersoonsgegevens.nl/en/current/dutch-dpa-imposes-a-fine-on-clearview-because-of-illegal-data-collection-for-facial-recognition

- Wakefield, BJ (2021, 25 mai). Un logiciel de détection des émotions par l'IA testé sur les Ouïghours. https://www.bbc.com/news/technology-57101248

- Règlement concernant la violation de données d'Equifax. (2024, 4 novembre). Commission fédérale du commerce. https://www.ftc.gov/enforcement/refunds/equifax-data-breach-settlement

- Dastin, J. (10 octobre 2018). Insight – Amazon abandonne un outil de recrutement secret basé sur l’IA qui présentait des préjugés à l’encontre des femmes. Reuters. https://www.reuters.com/article/world/insight-amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-idUSKCN1MK0AG/

- Règlement général sur la protection des données (RGPD) – texte juridique. (2024, 22 avril). Règlement général sur la protection des données (RGPD). https://gdpr-info.eu/

- Loi californienne sur la protection de la vie privée des consommateurs (CCPA). (2024, 13 mars). État de Californie – Ministère de la Justice – Bureau du procureur général. https://oag.ca.gov/privacy/ccpa

- Entrée en vigueur de la loi européenne sur l'intelligence artificielle. (2024, 1er août). Commission européenne – Commission européenne. https://ec.europa.eu/commission/presscorner/detail/en/ip_24_4123

- Améliorer les modèles de langage Gboard via des analyses fédérées privées. (s.d.). https://research.google/blog/improving-gboard-language-models-via-private-federated-analytics/

- Pomme. (sd). Confidentialité – Approche de la confidentialité. Apple (Inde). https://www.apple.com/in/privacy/approach-to-privacy/index.html

- Principes et approche de l'IA responsable | Microsoft AI. (s.d.). https://www.microsoft.com/en-us/ai/principles-and-approach

- Das, AC, Phalin, G., Patidar, IL, Gomes, M. et Thomas, R. (27 mars 2023). La prochaine frontière de l'engagement client : le service client basé sur l'IA. McKinsey & Compagnie. https://www.mckinsey.com/capabilities/operations/our-insights/the-next-frontier-of-customer-engagement-ai-enabled-customer-service

Prédictions sur les avancées de l'IA et leur impact potentiel sur la vie privée

Prédictions sur les avancées de l'IA et leur impact potentiel sur la vie privée