Introduction : Le défi des biais et de l'équité de l'IA

L'intelligence artificielle (IA) transforme les industries, améliore l'efficacité et façonne les processus décisionnels dans le monde entier. Cependant, avec la généralisation des systèmes d'IA, les préoccupations relatives aux biais et à l'équité en IA ont suscité une attention accrue.

Les biais de l'IA se produisent lorsque les algorithmes produisent des résultats systématiquement biaisés, entraînant un traitement inéquitable de certains groupes. Cela peut avoir de graves conséquences dans des secteurs comme l'embauche, le crédit, la santé et le maintien de l'ordre.

Il est essentiel de garantir l’équité dans l’IA pour prévenir la discrimination, favoriser la confiance et promouvoir l’adoption d’une IA éthique. Cet article explore les causes des biais de l’IA, ses implications et la manière dont les organisations peuvent atténuer ces défis.

1.1. Qu'est-ce que le biais de l'IA ?

Les biais de l'IA désignent les erreurs systématiques dans la prise de décision de l'IA, qui favorisent ou désavantagent des groupes ou des individus spécifiques. Ces biais résultent de défauts dans la collecte de données, la conception des algorithmes et l'influence humaine pendant le développement.

Les biais de l'IA désignent les erreurs systématiques dans la prise de décision de l'IA, qui favorisent ou désavantagent des groupes ou des individus spécifiques. Ces biais résultent de défauts dans la collecte de données, la conception des algorithmes et l'influence humaine pendant le développement.

Les systèmes d'IA apprennent à partir de données historiques, qui peuvent révéler des inégalités sociales et économiques existantes. Si ce biais n'est pas corrigé, Modèles d'IA peuvent renforcer et amplifier ces disparités, rendant les décisions prises par l’IA injustes.

Principales caractéristiques du biais de l’IA :

- C'est des erreurs systématiques et répétables plutôt qu’aléatoires.

- Elle discrimine souvent les individus en fonction de caractéristiques telles que le sexe, la race ou le statut socio-économique.

- Elle peut survenir à différents stades du développement de l’IA, de la collecte de données au déploiement du modèle.

1.2. L'importance de l'équité en IA (impact sur la société et les entreprises)

Garantir l'équité en IA est essentiel à la justice sociale et à la prospérité économique. Voici pourquoi l'équité en IA est essentielle :

| Zone d'impact | Description |

| Société | L'IA impartiale favorise l'inclusion, réduit la discrimination et renforce la confiance dans la technologie. Elle garantit que les groupes marginalisés ne sont pas injustement ciblés ou exclus. |

| Entreprise | Les entreprises qui utilisent des modèles d'IA équitables évitent les risques juridiques, renforcent la confiance de leurs clients et améliorent la réputation de leur marque. L'IA éthique favorise également une meilleure prise de décision et une meilleure innovation. |

| Conformité juridique | De nombreux gouvernements introduisent des réglementations sur l'IA, obligeant les entreprises à auditer et à éliminer les biais de leurs systèmes d'IA. Le non-respect de ces réglementations peut entraîner de lourdes amendes et une atteinte à la réputation. |

Par exemple, des entreprises comme IBM et Microsoft ont pris des mesures proactives pour améliorer l’équité de leurs outils d’IA en promouvant la transparence et en vérifiant les biais dans les modèles d’apprentissage automatique.

1.3. Les conséquences éthiques et juridiques d'une IA déloyale

Une IA biaisée peut avoir de graves conséquences éthiques et juridiques, notamment :

- Discrimination à l'embauche:Il a été constaté que les outils de recrutement basés sur l'IA favorisent les candidats masculins par rapport aux candidates féminines en raison de données de formation biaisées.

- Approbations de prêts inéquitables:Les systèmes de prêt basés sur l’IA ont été critiqués pour avoir systématiquement rejeté les demandes de prêt des groupes minoritaires.

- Décisions injustes de la justice pénale:Les algorithmes de police prédictive ont ciblé de manière disproportionnée les communautés de couleur, renforçant ainsi les préjugés systémiques.

- Disparités en matière de santé:Les diagnostics médicaux basés sur l’IA ont montré des préjugés raciaux, conduisant à des diagnostics erronés et à des plans de traitement incorrects pour les populations sous-représentées.

Les législateurs et les organismes de réglementation, tels que l’AI Act de l’Union européenne et l’Algorithmic Accountability Act des États-Unis, appliquent de plus en plus de politiques visant à limiter les biais de l’IA et à promouvoir l’équité.

1.4. Exemples concrets clés de biais de l'IA

Plusieurs cas très médiatisés mettent en évidence les dangers d’une IA biaisée :

- L'outil de recrutement IA d'Amazon:Amazon a abandonné un système de recrutement basé sur l'IA après avoir montré un parti pris contre les candidates, favorisant les CV contenant des mots associés aux hommes.

- Algorithme de justice pénale COMPAS:Utilisé aux États-Unis pour évaluer le risque de récidive, l'algorithme a classé de manière disproportionnée les accusés noirs comme étant à haut risque par rapport aux accusés blancs ayant des antécédents similaires.

- Biais de reconnaissance faciale:Des études menées par le MIT et l’ACLU ont révélé que les logiciels commerciaux de reconnaissance faciale présentaient des taux d’erreur significativement plus élevés pour les personnes à la peau plus foncée, ce qui entraînait des erreurs d’identification.

Ces cas soulignent la nécessité de modèles d’IA transparents, explicables et responsables.

Comprendre les racines des biais de l'IA

Les biais de l'IA ne surgissent pas de nulle part ; ils sont profondément ancrés dans le développement et le déploiement des systèmes d'apprentissage automatique. Les biais en IA proviennent de sources diverses, notamment d'algorithmes défaillants, de données déséquilibrées et de préjugés humains.

Pour répondre à ces problèmes, il est essentiel de comprendre d’abord les différents types de biais qui affectent les modèles d’IA, puis d’examiner les voies techniques par lesquelles ces biais s’infiltrent dans les processus de prise de décision de l’IA.

2.1. Types de biais dans les systèmes d'IA

a) Biais algorithmique

a) Biais algorithmique

Les biais de l'IA se manifestent sous de multiples formes, chacune contribuant à des résultats injustes ou inexacts. L'une des formes les plus courantes est biais algorithmique, qui survient lorsque la conception d’un système d’IA favorise intrinsèquement certains groupes par rapport à d’autres.

Cela pourrait être dû à la manière dont l'algorithme pondère différents facteurs, renforçant les inégalités historiques au lieu de les atténuer. Les biais algorithmiques sont particulièrement problématiques dans des domaines tels que l'embauche, les prêts et l'application de la loi, où des prédictions biaisées peuvent conduire à une discrimination généralisée.

b) Biais des données

Un autre facteur important contribuant au biais de l’IA est biais des données, qui peuvent survenir à différentes étapes de la collecte et de la préparation des données. Lorsque les ensembles de données ne sont pas représentatifs de la population qu'ils sont censés servir, les modèles d'IA entraînés sur ces données produisent des résultats faussés.

Les biais de données peuvent être introduits de plusieurs manières, notamment le biais de sélection, lorsque certaines données démographiques sont sous-représentées ; le biais d'étiquetage, lorsque des annotateurs humains introduisent par inadvertance des préjugés dans les données ; et le biais d'échantillonnage, lorsque les données utilisées pour la formation ne reflètent pas avec précision les distributions du monde réel.

Ces problèmes peuvent conduire à des modèles qui désavantagent systématiquement certains groupes, renforçant les stéréotypes et aggravant les inégalités sociales.

c) Les biais humains dans le développement de l'IA

Le biais émerge également de la élément humain dans le développement de l'IAÉtant donné que les systèmes d’IA sont construits et maintenus par des personnes, les préjugés inconscients des développeurs peuvent s’infiltrer dans les modèles qu’ils créent.

Cela se produit à travers les choix effectués en matière de curation des données, de sélection des fonctionnalités et d'optimisation des modèles. Même des développeurs bien intentionnés peuvent involontairement concevoir des systèmes d'IA qui reflètent leurs propres perspectives et hypothèses, perpétuant ainsi les biais.

d) Biais dans la formation et le déploiement du modèle

Enfin, biais dans la formation et le déploiement du modèle peuvent exacerber les disparités préexistantes. Si un modèle d'IA est formé Sur la base de données biaisées, les résultats seront inévitablement biaisés. De plus, si les systèmes d'IA ne sont pas régulièrement audités et mis à jour, les biais peuvent persister, voire s'aggraver avec le temps.

Les pratiques de déploiement jouent également un rôle dans la définition du comportement de l’IA : si un outil d’IA est intégré dans un système sans contrôles d’équité appropriés, il peut renforcer et amplifier les inégalités sociales à grande échelle.

2.2. Comment les biais s'immiscent dans les modèles d'IA : analyse technique

a) Problèmes de collecte et d'annotation des données

Comprendre les voies techniques par lesquelles les biais s'infiltrent dans les modèles d'IA est essentiel pour en atténuer l'impact. L'une des principales sources de biais est problèmes de collecte et d'annotation de donnéesLe processus de collecte de données introduit souvent des biais, en particulier lorsque certains groupes sont surreprésentés ou sous-représentés dans les ensembles de données de formation.

Si les modèles d'IA sont entraînés sur des ensembles de données incomplets ou peu diversifiés, ils apprennent des schémas qui reflètent ces biais. De plus, l'annotation des données, c'est-à-dire le processus d'étiquetage des exemples d'entraînement, peut introduire des biais humains, notamment lorsque des catégories subjectives sont impliquées, comme l'analyse des sentiments ou l'évaluation des risques criminels.

b) Biais d'entraînement et de surapprentissage du modèle

Un autre facteur technique majeur contribuant au biais de l’IA est biais d'entraînement et de surapprentissage du modèleLorsqu’un modèle d’IA est formé sur des données historiques qui reflètent les inégalités passées, il apprend à reproduire ces modèles plutôt qu’à les remettre en question.

Le surapprentissage se produit lorsqu'un modèle s'adapte trop aux schémas spécifiques des données d'entraînement au lieu de généraliser à de nouvelles données. Cela signifie que tout biais présent dans les données d'entraînement est intégré au processus décisionnel de l'IA, ce qui entraîne des résultats discriminatoires lors de son application à des scénarios réels.

c) Biais dans la prise de décision de l'IA et l'apprentissage par renforcement

Des préjugés apparaissent également dans Prise de décision et apprentissage par renforcement de l'IADe nombreux systèmes d'IA utilisent l'apprentissage par renforcement, où les modèles optimisent leur comportement en fonction des retours d'information. Si la boucle de rétroaction elle-même est biaisée, le système d'IA continuera d'apprendre et de renforcer ces biais au fil du temps.

Par exemple, dans le cadre de la police prédictive, un modèle d'IA qui oriente la surveillance vers certains quartiers générera davantage de signalements de crimes dans ces zones, renforçant ainsi l'hypothèse erronée selon laquelle la criminalité y est plus élevée. Ce cycle auto-entretenu rend difficile la correction des biais une fois intégrés au système d'IA.

En comprenant ces mécanismes, les développeurs et les décideurs politiques peuvent prendre des mesures proactives pour réduire les biais dans les systèmes d'IA. Des solutions telles que l'utilisation d'ensembles de données diversifiés et représentatifs, la conception d'algorithmes soucieux de l'équité et la mise en œuvre d'audits continus des biais sont essentielles pour développer des technologies d'IA éthiques et impartiales.

Mesurer les biais et l'équité de l'IA : indicateurs et méthodes clés

Garantir l'équité en IA nécessite des mesures et des évaluations rigoureuses. Les biais des modèles d'IA peuvent être subtils et souvent intégrés à des algorithmes complexes, ce qui rend nécessaire le recours à des techniques quantitatives et qualitatives pour détecter et atténuer les injustices.

Mesurer les biais de l'IA implique l'application de mesures statistiques d'équité, la réalisation d'audits et l'utilisation d'outils d'explicabilité pour mieux comprendre comment les systèmes d'IA prennent des décisions. Sans évaluation appropriée, les modèles d'IA biaisés peuvent renforcer la discrimination et exacerber les inégalités sociales.

3.1. Mesures d'équité statistique

a) Parité démographique

Pour mesurer les biais en IA, plusieurs indicateurs statistiques d'équité ont été développés, chacun se concentrant sur différents aspects de l'équité. L'un d'eux est largement utilisé. parité démographique, ce qui garantit que les résultats de l’IA sont répartis de manière égale entre les différents groupes démographiques.

En pratique, cela signifie que la probabilité d’un résultat positif (comme l’approbation d’un prêt ou l’obtention d’un entretien d’embauche) devrait être à peu près la même pour tous les groupes raciaux, de genre ou socio-économiques.

Toutefois, la parité démographique ne tient pas compte des différences de qualifications sous-jacentes ou de facteurs de risque, ce qui peut parfois conduire à des conclusions trompeuses en matière d’équité.

b) Égalité des chances et chances égalisées

Une autre mesure importante est égalité des chances et chances égalisées, qui se concentrent sur l’équité des taux d’erreur plutôt que sur les prévisions globales.

Égalité des chances garantit que les personnes qui remplissent les conditions pour obtenir un résultat positif (comme être embauchées) ont la même probabilité d’obtenir ce résultat, quel que soit leur groupe démographique.

Cotes égalisées Poussons cette démarche encore plus loin en veillant à ce que les faux positifs et les faux négatifs se produisent à des taux similaires dans tous les groupes.

Ces mesures sont particulièrement utiles dans des domaines tels que la justice pénale et les soins de santé, où les disparités en termes de faux négatifs ou de faux positifs peuvent avoir des conséquences qui changent la vie.

c) Équité individuelle et équité collective

Le débat entre équité individuelle et équité collective joue également un rôle clé dans la mesure des biais.

jeéquité individuelle exige que des individus similaires reçoivent des décisions similaires générées par l’IA, quelles que soient leurs caractéristiques démographiques.

Équité du groupe, d’autre part, se concentre sur la garantie de résultats équitables entre les différents groupes démographiques.

Le défi consiste à équilibrer ces deux perspectives, l’optimisation de l’une pouvant parfois réduire les performances de l’autre.

d) Analyse d'impact disparate

Une autre méthode clé est analyse d'impact disparate, qui évalue si un modèle d'IA désavantage de manière disproportionnée certains groupes, même si l'algorithme n'est pas explicitement programmé pour le faire. Cette approche est couramment utilisée dans les cadres juridiques et réglementaires pour garantir le respect des lois anti-discrimination. Une analyse d'impact disparate peut révéler des biais involontaires dans les algorithmes de recrutement, les modèles de prêt et les systèmes de reconnaissance faciale, ce qui incite à procéder aux ajustements nécessaires pour réduire les injustices.

3.2. Vérification des biais dans les modèles d'IA

a) Outils et cadres de détection des biais

Plusieurs outils et cadres de pointe ont été développés pour aider à la détection des biais de l’IA.

IBM AI Fairness 360 est une boîte à outils open source qui fournit une suite de mesures d'équité et d'algorithmes d'atténuation des biais, aidant les organisations à évaluer et à réduire les biais dans les modèles d'apprentissage automatique.

De la même manière, L'outil « Et si » de Google permet aux développeurs de visualiser et de comparer les prédictions des modèles d'IA dans différents groupes démographiques, ce qui facilite l'identification des disparités dans la prise de décision.

Ces outils aident les praticiens de l’IA à diagnostiquer les problèmes d’équité et à mettre en œuvre des mesures correctives avant de déployer leurs modèles dans des applications réelles.

b) Techniques d'explicabilité et de transparence de l'IA

En plus de détecter les biais, d’améliorer Explicabilité et transparence de l'IA est crucial pour garantir l'équité. De nombreux modèles d'IA, notamment les algorithmes d'apprentissage profond, fonctionnent comme des « boîtes noires », ce qui rend difficile de comprendre pourquoi ils font certaines prédictions.

Des techniques telles que FORME (Explications additives de Shapley) et CITRON VERT (Explications indépendantes du modèle interprétable local) fournir des informations sur la manière dont des fonctionnalités spécifiques influencent les décisions de l'IA.

BEn rendant la prise de décision de l’IA plus interprétable, les organisations peuvent identifier les sources potentielles de biais et améliorer la responsabilité.

Études de cas : exemples concrets de biais et de conséquences de l'IA

Les biais de l'IA ont eu de graves conséquences concrètes, affectant des secteurs allant des forces de l'ordre à la finance. Ces cas mettent en évidence les risques d'une IA incontrôlée et l'urgente nécessité d'équité, de transparence et de responsabilité dans les systèmes d'apprentissage automatique.

4.1. Reconnaissance faciale et préjugés raciaux

4.1. Reconnaissance faciale et préjugés raciaux

Il a été constaté que les outils de reconnaissance faciale, notamment Rekognition d'Amazon et Clearview AI, identifient mal les personnes de couleur à des taux nettement plus élevés.

Des études menées par le MIT Media Lab ont révélé que ces systèmes classaient fréquemment les personnes noires de manière erronée, ce qui entraînait des arrestations injustifiées dans les applications des forces de l'ordre. Cela a suscité des inquiétudes quant au profilage racial et à la surveillance de masse, suscitant des appels à une réglementation, voire à une interdiction, dans certaines régions.

4.2. Biais sexistes dans les outils de recrutement basés sur l'IA

L'outil de recrutement d'Amazon basé sur l'IA a été abandonné après avoir constaté qu'il favorisait les candidats masculins par rapport aux candidates. Ce modèle, entraîné à partir de CV historiques, pénalisait les CV contenant des termes comme « femme », renforçant ainsi les disparités entre les sexes à l'embauche. Ce cas a démontré les risques liés à l'utilisation de données passées sans ajustements d'équité, soulignant la nécessité d'audits de biais dans l'IA de recrutement.

4.3. Biais de l'IA dans le secteur de la santé

Un système d'IA médicale utilisé dans les hôpitaux américains s'est avéré discriminatoire envers les patients noirs, sous-estimant leurs besoins de soins. L'algorithme, qui s'appuyait sur les dépenses de santé comme indicateur de la gravité de la maladie, ne tenait pas compte des disparités systémiques en matière d'accès aux soins. Ce cas met en évidence les dangers des données erronées et la nécessité d'une équité dans les soins de santé basés sur l'IA.

4.4. Biais dans les services financiers

L'algorithme de carte de crédit d'Apple a été accusé d'offrir des limites de crédit nettement inférieures aux femmes qu'aux hommes, même avec un profil financier similaire. Cela a suscité un examen réglementaire minutieux des modèles d'évaluation du crédit biaisés, illustrant comment l'opacité des décisions de l'IA peut renforcer les inégalités financières.

4.5. Désinformation et biais dans la modération de contenu par IA

La modération de contenu pilotée par l'IA sur des plateformes comme Facebook et YouTube a été critiquée pour censure disproportionnée des communautés marginalisées et amplification des fausses informations. Les algorithmes axés sur l'engagement privilégient les contenus sensationnels, influençant ainsi l'opinion publique et les résultats politiques. Ce cas souligne la nécessité d'une plus grande transparence de l'IA sur les plateformes numériques.

Ces cas révèlent comment une IA biaisée peut perpétuer la discrimination, les inégalités financières et la désinformation. Pour atténuer ces risques, les organisations doivent mettre en œuvre des audits d'équité, utiliser des ensembles de données diversifiés et garantir la transparence des décisions prises par l'IA. Sans mesures proactives, l'IA continuera de refléter et de renforcer les préjugés sociétaux au lieu de les corriger.

Lignes directrices réglementaires et éthiques pour l'équité de l'IA

À mesure que l’adoption de l’IA se développe, les gouvernements et les organisations du monde entier élaborent des cadres réglementaires et lignes directrices éthiques garantir l'équité, la transparence et la responsabilité des systèmes d'IA. Ces initiatives visent à réduire les biais, à protéger les droits individuels et à promouvoir un développement responsable de l'IA.

5.1. RGPD et exigences d'équité en matière d'IA en Europe

Le Règlement général sur la protection des données (RGPD) Le RGPD dans l'Union européenne (UE) comprend des dispositions qui ont un impact sur l'équité de l'IA, notamment dans la prise de décision automatisée. L'article 22 du RGPD accorde aux individus le droit de contester les décisions prises par l'IA qui les affectent significativement, comme l'approbation d'un prêt ou les résultats d'un recrutement.

Le règlement exige également que les modèles d’IA soient explicables et interdit toute discrimination injuste fondée sur des attributs sensibles tels que la race, le sexe ou la religion.

En outre, l’UE fait progresser le Loi sur l'IA, un cadre réglementaire unique en son genre qui catégorise les systèmes d'IA par niveau de risque et impose des règles plus strictes aux applications à haut risque, telles que la surveillance biométrique et l'IA dans le domaine de la santé.

5.2. La Déclaration des droits de l'IA et la loi sur la responsabilité algorithmique aux États-Unis

Aux États-Unis, la réglementation de l’IA est encore en évolution. Projet de charte des droits de l'IA, présenté par la Maison Blanche, définit les principes d'une IA éthique, mettant l'accent sur l'équité, la confidentialité et la transparence. Il appelle à ce que les systèmes d'IA soient soumis à des tests de biais et à ce que les utilisateurs aient un plus grand contrôle sur l'impact de l'IA sur leur vie.

Le Loi sur la responsabilité algorithmique, proposé par les législateurs américains, vise à réglementer l'IA dans les secteurs à haut risque comme la finance et la santé. Il obligerait les entreprises à réaliser des analyses d'impact sur les modèles d'IA afin d'identifier et d'atténuer les biais avant leur déploiement. Ces efforts reflètent les préoccupations croissantes concernant la discrimination liée à l'IA et la nécessité d'une surveillance réglementaire.

5.3. Normes ISO et IEEE sur l'IA éthique et la réduction des biais

Les organisations internationales comme la Organisation internationale de normalisation (ISO) et le Institut des ingénieurs électriciens et électroniciens (IEEE) ont établi des lignes directrices pour une IA éthique.

ISO ISO/CEI 24027 se concentre sur l'identification et l'atténuation des biais dans l'apprentissage automatique, tandis que l'IEEE Conception éthiquement alignée Ce cadre définit les meilleures pratiques en matière d'équité, de responsabilité et de transparence dans le développement de l'IA. Ces normes fournissent des orientations techniques aux entreprises souhaitant créer des systèmes d'IA éthiques.

5.4. Initiatives mondiales pour l'équité en matière d'IA

Des organisations comme L'UNESCO, l'OCDE et l'UE mènent des efforts mondiaux pour promouvoir une IA juste et éthique. Recommandation sur l'éthique de l'intelligence artificielle appelle à des cadres de gouvernance de l’IA qui donnent la priorité aux droits de l’homme et à la durabilité.

Le Principes de l'OCDE sur l'IA défendre la transparence, la responsabilité et l’inclusion de l’IA, en influençant les politiques d’IA dans le monde entier.

L'UE Loi sur l'IA vise à créer une norme réglementaire pour la sécurité et l'équité de l'IA, établissant un précédent pour la gouvernance mondiale de l'IA.

5.5. Politiques d'éthique de l'IA en entreprise : comment les géants de la technologie abordent les biais liés à l'IA

Les grandes entreprises technologiques adoptent de plus en plus de politiques d’éthique en matière d’IA pour lutter contre les préjugés et promouvoir une utilisation responsable de l’IA.

Google a mis en place un comité d’éthique de l’IA et développé des outils d’équité comme l’outil « What-If » pour la détection des biais.

Microsoft a mis en œuvre des principes d'équité en matière d'IA, interdisant la vente de technologies de reconnaissance faciale aux forces de l'ordre en raison de préoccupations liées aux préjugés.

IBM a publié des boîtes à outils d'équité open source, telles que AI Fairness 360, pour aider les développeurs à détecter et à atténuer les biais dans les modèles d'apprentissage automatique.

Si les politiques des entreprises constituent un progrès, leurs détracteurs estiment que l'autorégulation est insuffisante. De nombreux experts appellent à un renforcement de la surveillance gouvernementale afin de garantir l'équité de l'IA, au-delà des engagements volontaires des entreprises.

Stratégies pour atténuer les biais de l'IA et promouvoir l'équité

À mesure que les systèmes d'IA s'intègrent de plus en plus aux processus décisionnels, il est essentiel de garantir l'équité. La lutte contre les biais de l'IA nécessite des stratégies proactives allant des solutions techniques aux politiques organisationnelles.

Une atténuation efficace des biais implique d’affiner les pratiques de développement de l’IA, de mettre en œuvre une supervision humaine, de promouvoir la diversité dans les équipes d’IA et d’établir des audits indépendants pour garantir une surveillance et une responsabilité continues.

6.1. Techniques d'atténuation des biais dans le développement de l'IA

a) Rééquilibrage des données de formation pour une représentation équitable

L’un des moyens les plus efficaces de réduire les biais de l’IA est de : rééquilibrage des données de formation pour une représentation équitableDe nombreux modèles d’IA deviennent biaisés en raison d’ensembles de données déséquilibrés qui surreprésentent certaines données démographiques tout en sous-représentant d’autres.

En organisant des ensembles de données reflétant la diversité des populations, les développeurs peuvent améliorer la précision et l'équité des modèles. Des techniques telles que augmentation des données et repondération peut aider à équilibrer la représentation entre différents groupes, garantissant ainsi des résultats d’IA plus équitables.

b) Débiasing contradictoire dans les modèles d'apprentissage automatique

Une autre technique est débiasing contradictoire, qui consiste à entraîner les modèles d'IA à reconnaître et à minimiser les biais durant le processus d'apprentissage. Cette méthode utilise des réseaux neuronaux antagonistes qui mettent le modèle au défi de faire des prédictions plus justes, contribuant ainsi à réduire les disparités dans la prise de décision.

De plus, des algorithmes soucieux de l’équité, tels que fonctions de perte repondérées, peut pénaliser les prédictions biaisées, encourageant le modèle à donner la priorité à des résultats équitables.

c) Confidentialité différentielle et apprentissage fédéré pour une IA éthique

Les nouvelles technologies de préservation de la vie privée, comme confidentialité différentielle et apprentissage fédéré contribuer également à une IA éthique.

Confidentialité différentielle garantit que les modèles d'IA ne mémorisent pas ou ne révèlent pas par inadvertance des données personnelles sensibles, réduisant ainsi le risque de biais causé par l'exposition des données.

Apprentissage fédéré permet aux modèles d'IA d'être formés sur des sources de données décentralisées sans agréger les données individuelles des utilisateurs, améliorant ainsi l'équité tout en préservant la confidentialité.

Pour une analyse plus approfondie de la manière dont les principes de conception éthique peuvent être intégrés dès le départ, explorez notre guide complet sur développement éthique de l'IA.

6.2. Le rôle de la surveillance humaine dans la prise de décision en IA

Malgré les progrès de l'IA, la surveillance humaine demeure essentielle pour prévenir les biais et garantir une prise de décision éthique. Les systèmes d'IA ne doivent pas fonctionner de manière isolée ; ils doivent plutôt être complétés par le jugement humain, en particulier dans les domaines à enjeux élevés tels que le recrutement, la santé et l'application de la loi. Approches de type « humain dans la boucle » (HITL) impliquent l’intégration d’examinateurs humains à des étapes critiques de la prise de décision de l’IA pour intervenir dans les cas où un biais est détecté.

De plus, la transparence dans la prise de décision de l’IA aide les utilisateurs à comprendre comment les conclusions basées sur l’IA sont obtenues. IA explicable (XAI) Ces techniques permettent aux parties prenantes d'interpréter les modèles d'IA et d'identifier les biais potentiels avant leur déploiement. En intégrant une supervision humaine et des mesures d'interprétabilité, les organisations peuvent renforcer la responsabilisation et la confiance dans les systèmes d'IA.

6.3. Équipes d'IA diversifiées et inclusives : l'importance de la représentation

Les biais en IA reflètent souvent ceux de ceux qui les développent. Pour créer des systèmes d'IA plus équitables, les organisations doivent privilégier la diversité au sein des équipes de développement. Lorsque les équipes d'IA ne sont pas représentatives de divers groupes démographiques, des angles morts peuvent apparaître, entraînant des biais involontaires dans les modèles d'IA. Une main-d'œuvre diversifiée dans le domaine de l'IA, y compris des individus issus de milieux raciaux, de genres et socioéconomiques différents, apporte des perspectives variées qui aident à identifier et à atténuer les préjugés dès le début du processus de développement.

Au-delà de la composition des équipes, des pratiques de conception inclusives, comme la réalisation de tests d'équité auprès de divers groupes d'utilisateurs, garantissent un fonctionnement équitable des modèles d'IA pour toutes les communautés. Les entreprises qui investissent dans le développement d'une IA éthique bénéficient d'une plus grande portée commerciale, d'une confiance accrue des utilisateurs et d'un respect renforcé des réglementations en matière d'équité.

6.4. Audits d'IA tiers et surveillance continue pour une IA équitable

L'équité de l'IA ne doit pas être une considération ponctuelle, mais un processus continu. audits d'IA tiers Fournir des évaluations impartiales des systèmes d'IA, aidant ainsi les organisations à détecter les biais cachés que les équipes internes pourraient négliger. Ces audits évaluent les modèles d'IA à l'aide d'indicateurs d'équité, les soumettent à des tests de résistance pour détecter des tendances discriminatoires et recommandent des mesures correctives.

La surveillance continue est tout aussi importante. Les systèmes d'IA évoluent au fil du temps et des biais peuvent apparaître lorsque les modèles interagissent avec de nouvelles données. surveillance de l'équité en temps réel garantit que les modèles d’IA restent éthiques et impartiaux même après leur déploiement. Outils automatisés de détection des biais peut signaler les violations potentielles de l'équité, permettant ainsi une action corrective rapide.

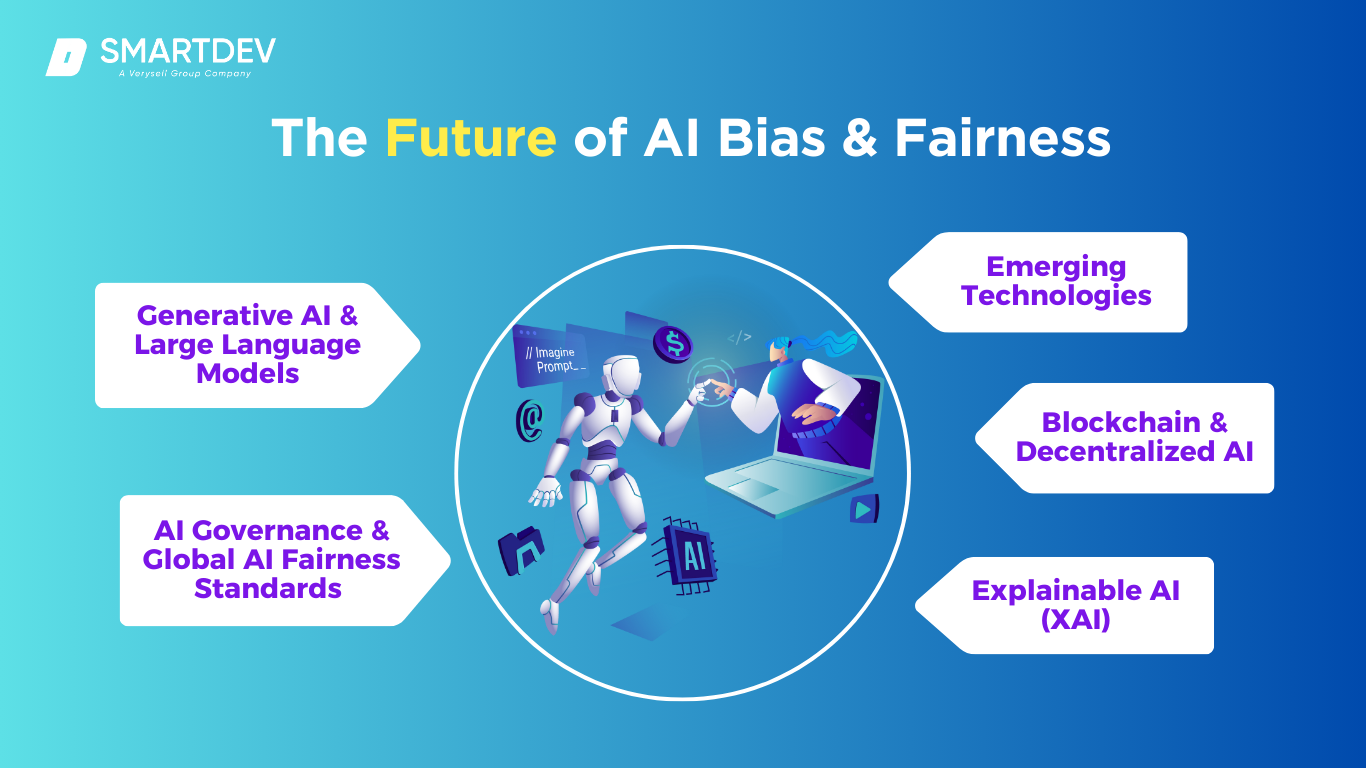

L'avenir de l'IA : biais et équité : défis et opportunités

Alors que l'IA continue d'évoluer, garantir l'équité demeure un défi majeur. L'expansion rapide des technologies d'IA, notamment l'IA générative, les systèmes autonomes et l'IA décentralisée, soulève des questions éthiques concernant les biais, la transparence et la gouvernance. Relever ces défis nécessite une coopération mondiale, l'innovation technique et des cadres de gouvernance de l'IA plus solides.

Alors que l'IA continue d'évoluer, garantir l'équité demeure un défi majeur. L'expansion rapide des technologies d'IA, notamment l'IA générative, les systèmes autonomes et l'IA décentralisée, soulève des questions éthiques concernant les biais, la transparence et la gouvernance. Relever ces défis nécessite une coopération mondiale, l'innovation technique et des cadres de gouvernance de l'IA plus solides.

7.1. L'éthique de l'IA générative et les biais dans les grands modèles linguistiques

Modèles d'IA génératifs comme ChatGPT, Gemini et Claude Ils ont révolutionné la création de contenu, mais ils héritent également de biais issus des données sur lesquelles ils sont entraînés. Puisqu'ils s'appuient sur de vastes quantités de données internet, ces modèles peuvent refléter et amplifier les préjugés sociétaux existants, notamment les préjugés raciaux, sexistes et idéologiques. Cela a suscité des inquiétudes quant à la désinformation, aux stéréotypes et à la responsabilité éthique des contenus générés par l'IA.

L’un des défis est le manque de conscience du contexte dans de grands modèles linguistiques. Bien que ces modèles génèrent des réponses de type humain, ils ne possèdent pas de véritable compréhension ni de raisonnement moral, ce qui les rend susceptibles de renforcer des biais préjudiciables. Les entreprises travaillent sur apprentissage par renforcement à partir du feedback humain (RLHF) et des techniques de formation contradictoires pour réduire les préjugés, mais une neutralité complète reste difficile à atteindre.

L’avenir de l’IA générative nécessitera des mises à jour continues, des audits d’équité plus stricts et une transparence accrue dans les données de formation et la conception des modèles.

7.2. Gouvernance de l'IA et nécessité de normes mondiales d'équité en matière d'IA

Les biais de l'IA constituent un problème mondial, mais les réglementations varient considérablement d'un pays à l'autre. Loi européenne sur l'IA fixe des directives strictes sur les applications d'IA à haut risque, d'autres régions, dont les États-Unis et la Chine, adoptent des approches différentes. normes unifiées d'équité en matière d'IA crée des incohérences dans la manière dont l’éthique de l’IA est appliquée dans le monde entier.

Pour garantir l’équité, des organisations telles que L'UNESCO, l'OCDE et le Forum économique mondial travaillent sur des cadres de gouvernance mondiale de l'IA. Ces initiatives visent à établir principes éthiques de l'IA qui transcendent les réglementations nationales et garantissent que l'IA profite à toutes les sociétés. À l'avenir, la coopération internationale sera essentielle pour créer des indicateurs d'équité standardisés, des cadres réglementaires et une responsabilité transfrontalière en matière d'IA.

7.3. Biais de l'IA dans les technologies émergentes

Les biais dans l’IA ne se limitent pas aux logiciels, ils s’étendent à technologies émergentes telles que les véhicules autonomes, les infrastructures de villes intelligentes et la robotique.

- Véhicules autonomes (VA) : Les voitures autonomes alimentées par l'IA s'appuient sur de vastes bases de données pour prendre des décisions. Cependant, des études montrent que les véhicules autonomes peuvent avoir du mal à reconnaître les piétons à la peau foncée, ce qui augmente le risque d'accident dans les communautés marginalisées. Pour remédier à ces biais, il est nécessaire de disposer de bases de données plus diversifiées et de procéder à des tests d'équité rigoureux dans les systèmes de véhicules autonomes.

- Villes intelligentes : Les outils de surveillance et d'urbanisme basés sur l'IA risquent de renforcer les inégalités systémiques s'ils reposent sur des données historiques biaisées. Des algorithmes policiers biaisés, par exemple, peuvent conduire à une surveillance accrue des quartiers minoritaires, exacerbant ainsi les discriminations.

- Robotique : Les robots dotés d'IA utilisés sur les lieux de travail et à la maison doivent être conçus pour fonctionner de manière juste et équitable. Si les données d'apprentissage sont biaisées, les robots pourraient prendre des décisions discriminatoires, notamment dans des secteurs comme la santé et le service client.

7.4. Comment la blockchain et l'IA décentralisée peuvent améliorer l'équité

La blockchain et l’IA décentralisée offrent des solutions prometteuses pour améliorer la transparence et l’équité dans les systèmes d’IA. Cadres d'IA décentralisés, qui distribuent la formation du modèle d'IA sur plusieurs nœuds plutôt que sur une entité centrale, contribuent à réduire les biais en garantissant qu'aucune organisation ne contrôle les données de formation.

La technologie Blockchain peut améliorer Audits d'équité de l'IA en créant des enregistrements immuables des processus décisionnels de l'IA. Cette transparence garantit que les biais de l'IA peuvent être identifiés et corrigés. De plus, systèmes d'identité décentralisés Alimenté par la blockchain, il pourrait contribuer à réduire les biais dans la notation du crédit, l'embauche et les soins de santé en offrant aux individus un meilleur contrôle sur leurs données.

Bien que l’IA décentralisée en soit encore à ses débuts, elle représente un avenir potentiel où les systèmes d’IA sont plus responsable, transparent et résistant aux préjugés.

7.5. Le rôle de l'IA explicable (XAI) dans la création de systèmes d'IA transparents

L’un des plus grands défis en matière d’équité de l’IA est la nature de boîte noire de nombreux modèles d’apprentissage automatique, ce qui rend difficile de comprendre comment l’IA parvient à certaines décisions. IA explicable (XAI) vise à résoudre ce problème en développant des outils qui fournissent des informations sur les processus de prise de décision de l'IA.

En rendant les systèmes d’IA plus interprétables, XAI peut aider à :

- Détectez et corrigez les biais en temps réel.

- Renforcez la confiance entre les utilisateurs en expliquant pourquoi l’IA a pris une décision spécifique.

- Assurez la conformité réglementaire en assurant la transparence dans la prise de décision de l’IA.

Des techniques telles que SHAP (Shapley Additive Explanations), LIME (Local Interpretable Model-agnostic Explanations) et explications contrefactuelles contribuer à rendre les systèmes d'IA plus compréhensibles et responsables. À mesure que la gouvernance de l'IA évolue, XAI jouera un rôle central pour garantir un fonctionnement transparent et équitable de l'IA.

Conclusion et points clés à retenir

Les biais liés à l'IA demeurent un problème crucial qui touche de nombreux secteurs, du recrutement et de la santé à la finance et aux forces de l'ordre. Si rien n'est fait, les systèmes d'IA biaisés risquent de perpétuer la discrimination et d'exacerber les inégalités sociales. Parvenir à une IA équitable exige une collaboration entre les entreprises, les décideurs politiques et les développeurs afin de garantir que les technologies d'IA soient transparentes, responsables et conçues de manière éthique.

Les biais liés à l'IA demeurent un problème crucial qui touche de nombreux secteurs, du recrutement et de la santé à la finance et aux forces de l'ordre. Si rien n'est fait, les systèmes d'IA biaisés risquent de perpétuer la discrimination et d'exacerber les inégalités sociales. Parvenir à une IA équitable exige une collaboration entre les entreprises, les décideurs politiques et les développeurs afin de garantir que les technologies d'IA soient transparentes, responsables et conçues de manière éthique.

Principaux défis liés aux biais de l'IA

Les principaux défis incluent les données d'entraînement biaisées, la discrimination algorithmique, le manque de transparence des processus décisionnels et l'incohérence des cadres réglementaires. À mesure que l'IA évolue, notamment dans des domaines comme les modèles génératifs et les systèmes autonomes, la prévention des biais va s'accroître.

Assurer une IA équitable : mesures à prendre

- Entreprises doit adopter des audits de biais, garantir des ensembles de données diversifiés et donner la priorité à l’explicabilité dans les modèles d’IA.

- Décideurs politiques devrait faire respecter les réglementations en matière d’équité, telles que la loi européenne sur l’IA, et plaider en faveur d’une gouvernance mondiale globale de l’IA.

- Développeurs devrait utiliser des techniques soucieuses d’équité, telles que la désensibilisation contradictoire et l’apprentissage fédéré, tout en promouvant l’inclusion et la diversité au sein des équipes d’IA.

La voie à suivre

L'avenir de l'équité en IA repose sur une gouvernance solide, des avancées techniques continues et une surveillance humaine constante. L'intégration de l'IA explicable (XAI) sera essentielle pour favoriser une plus grande transparence et une plus grande responsabilité. Pour bâtir une IA éthique, les organisations doivent intégrer l'équité à chaque phase de développement, afin que les technologies d'IA bénéficient équitablement à toutes les communautés.

—

Références:

- Institut AI Now – Rapports sur les biais de l’IA

- Forum économique mondial – Comment prévenir la discrimination dans l’IA

- Commission européenne – Loi sur l’intelligence artificielle

- Maison Blanche – Projet de charte des droits de l’IA

- IEEE – Conception éthiquement alignée

- NIST – Vers une norme pour identifier et gérer les biais dans l’IA

- Laboratoire des médias du MIT – Projet Gender Shades

- Science – Décrypter les préjugés raciaux dans un algorithme utilisé pour gérer la santé des populations

- IBM Boîte à outils AI Fairness 360

- UNESCO – Recommandation sur l’éthique de l’intelligence artificielle