Pourquoi les préoccupations éthiques en matière d’IA sont-elles importantes ?

L'intelligence artificielle (IA) transforme les industries à un rythme effréné. Elle apporte à la fois des innovations passionnantes et de sérieuses questions éthiques.

Les entreprises du monde entier déploient rapidement des systèmes d'IA pour accroître leur efficacité et acquérir un avantage concurrentiel. Pourtant, Préoccupations éthiques liées à l'IA sont de plus en plus sous les projecteurs à mesure que des conséquences imprévues apparaissent.

En réalité, neuf organisations sur dix ont constaté qu'un système d'IA posait un problème éthique dans leurs opérations. Cela a incité de nombreuses entreprises à établir des lignes directrices éthiques en matière d'IA – une augmentation de 80% en seulement un an – afin de garantir une utilisation responsable de l'IA.

Alors, quelles sont les préoccupations éthiques en matière d’IA ?

Selon IMD, Éthique de l'IA fait référence aux principes et pratiques moraux qui guident le développement et l’utilisation des technologies d’IA. Il s’agit de garantir que les systèmes d’IA sont justes, transparents, responsables et sûrs.

Ces considérations ne sont plus facultatives. Elles ont un impact direct sur la confiance du public, la réputation de la marque, la conformité légale et même les résultats financiers.

Pour les entreprises, une IA non éthique peut conduire à des décisions biaisées qui aliénent les clients, à des violations de la vie privée passibles d'amendes ou à des conséquences dangereuses engageant la responsabilité. Pour la société et les individus, elle peut creuser les inégalités et porter atteinte aux droits fondamentaux.

L’importance de l’éthique de l’IA est déjà évidente dans les dilemmes du monde réel.

Des algorithmes de recrutement discriminatoires envers certains groupes aux systèmes de reconnaissance faciale qui portent atteinte à la vie privée, les pièges éthiques de l'IA ont des conséquences tangibles. La désinformation générée par l'IA (comme les vidéos deepfakes) sape la confiance dans les médias, et les décisions opaques de l'IA, souvent prises par des « boîtes noires », laissent les gens perplexes quant à la manière dont des choix cruciaux – recrutement, prêts, diagnostics médicaux – ont été pris.

Chacun de ces scénarios souligne pourquoi Les préoccupations éthiques en matière d’IA sont importantes profondément pour les chefs d’entreprise et les décideurs politiques.

Ce guide explorera les principaux problèmes éthiques entourant l’IA, examinera les préoccupations spécifiques à l’industrie et les études de cas réelles d’IA qui ont mal tourné, et proposera des étapes pratiques pour mettre en œuvre l’IA de manière responsable dans n’importe quelle organisation.

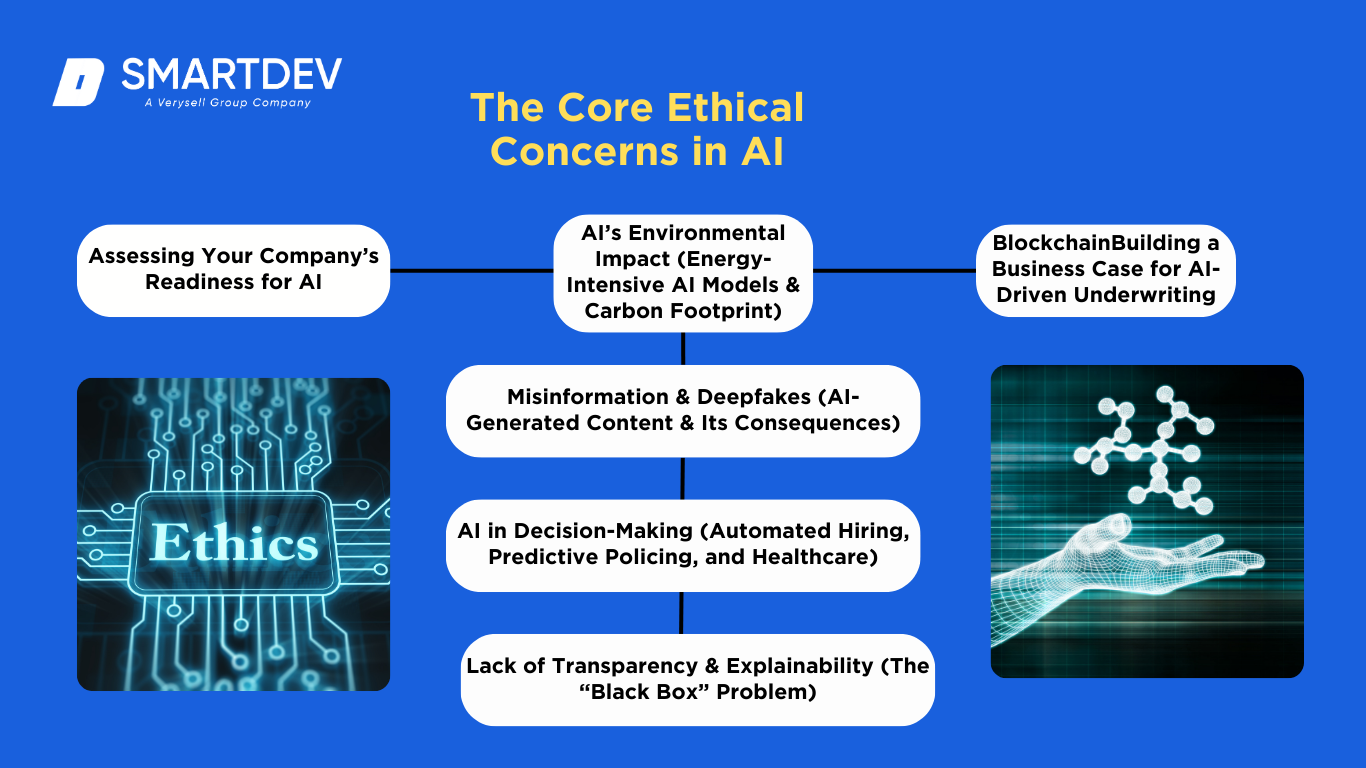

Les principales préoccupations éthiques en matière d'IA

Les technologies d'IA posent de nombreux défis éthiques. Les dirigeants d'entreprise et les décideurs politiques doivent comprendre principales préoccupations éthiques en matière d'IA afin de gérer les risques et de créer des systèmes d’IA fiables.

Les technologies d'IA posent de nombreux défis éthiques. Les dirigeants d'entreprise et les décideurs politiques doivent comprendre principales préoccupations éthiques en matière d'IA afin de gérer les risques et de créer des systèmes d’IA fiables.

Voici quelques-unes des préoccupations les plus urgentes :

Biais et discrimination dans les modèles d'IA

L’une des principales préoccupations éthiques de l’IA est algorithmique biais – lorsque les systèmes d’IA favorisent ou désavantagent injustement certains groupes.

Les modèles d'IA apprennent à partir de données historiques, qui peuvent coder les préjugés humains. Par conséquent, l'IA peut renforcer la discrimination raciale, sexuelle ou socio-économique si elle n'est pas soigneusement contrôlée.

Par exemple, il a été découvert qu'une IA de recrutement désormais tristement célèbre, développée chez Amazon, déclassait les CV contenant le mot « femme », reflétant la prédominance masculine de ses données de formation.En effet, le système s'est appris à privilégier les candidats masculins, démontrant ainsi la rapidité avec laquelle les préjugés peuvent s'infiltrer dans l'IA..

Dans le domaine de la justice pénale, il a été signalé que les logiciels de prédiction des risques comme COMPAS étiquetaient à tort les accusés noirs comme présentant un risque plus élevé que les accusés blancs, en raison de données et d'une conception biaisées..

Ces cas montrent que une IA non contrôlée peut perpétuer des biais systémiques, ce qui conduit à des résultats discriminatoires en matière d’embauche, de prêt, de maintien de l’ordre et au-delà.

Les entreprises doivent être vigilantes : une IA biaisée nuit non seulement aux individus et aux classes protégées, mais expose également les entreprises à des atteintes à leur réputation et à une responsabilité juridique en cas de discrimination.

IA et violations de la vie privée (sécurité des données, surveillance)

La soif de données de l'IA soulève des questions majeures confidentialité Les systèmes d'IA avancés s'appuient souvent sur de vastes quantités de données personnelles – des historiques d'achat et des publications sur les réseaux sociaux aux visages capturés par la caméra – ce qui peut mettre en danger la vie privée des individus.

La technologie de reconnaissance faciale en est un exemple frappant : des startups comme Clearview AI ont récupéré des milliards de photos en ligne pour créer une base de données d'identification faciale sans le consentement des utilisateurs. Cela a permis des capacités de surveillance invasives, suscitant l'indignation mondiale et des poursuites judiciaires..

Les régulateurs ont constaté que les pratiques de Clearview violaient les lois sur la protection de la vie privée en créant une « base de données massive d'empreintes faciales » et en permettant une surveillance secrète des citoyens..

De tels incidents illustrent la manière dont l'IA peut porter atteinte aux droits à la protection des données et aux attentes en matière de confidentialité. Les entreprises qui déploient l'IA doivent garantir la sécurité des données et le respect des réglementations en matière de confidentialité (comme le RGPD ou la loi HIPAA).

Des préoccupations éthiques se posent également en matière de surveillance de l'IA sur le lieu de travail : par exemple, la surveillance des communications des employés ou l'utilisation d'analyses de caméras pour suivre la productivité peuvent franchir les limites de la confidentialité et éroder la confiance.

Le respect du consentement des utilisateurs, la sécurisation des données contre les violations et la limitation de la collecte de données à ce qui est réellement nécessaire sont autant d'étapes essentielles pour y parvenir. IA responsable qui respecte la vie privée.

Désinformation et deepfakes (contenu généré par l'IA)

L’IA est désormais capable de générer du faux contenu très réaliste – ce qu’on appelle deepfakes Dans les vidéos, les fichiers audio et les textes. Cela crée une menace de désinformation considérable. Les faux articles, les fausses images ou les vidéos usurpées générés par l'IA peuvent se propager rapidement en ligne, induisant le public en erreur. Les conséquences pour les entreprises et la société sont graves : érosion de la confiance dans les médias, manipulation des élections et nouvelles formes de fraude. Lors des récentes élections, La désinformation générée par l’IA a été signalée comme une préoccupation majeure, le Forum économique mondial avertissant que l'IA amplifie le contenu manipulé qui pourrait « déstabiliser les sociétés ».

Par exemple, des vidéos deepfake de politiciens disant ou faisant des choses qu'ils n'ont jamais faites ont circulé, obligeant les entreprises et les gouvernements à concevoir de nouvelles stratégies de détection et de réponse. Préoccupations éthiques liées à l'IA Il y a deux objectifs : empêcher l'utilisation malveillante de l'IA générative à des fins trompeuses et veiller à ce que les algorithmes (comme les systèmes de recommandation des réseaux sociaux) n'amplifient pas de manière inconsidérée les faux contenus. Les entreprises du secteur des réseaux sociaux et de la publicité, en particulier, ont la responsabilité de détecter les deepfakes, d'étiqueter ou de supprimer les faux contenus et d'éviter de tirer profit de la désinformation. Ne pas lutter contre la désinformation générée par l'IA peut entraîner des préjudices publics et des réactions négatives de la part des autorités ; c'est donc une préoccupation que les dirigeants d'entreprise doivent traiter de toute urgence.

L'IA dans la prise de décision (biais automatisés dans le recrutement, la police et les soins de santé)

Les organisations utilisent de plus en plus l’IA pour automatiser les décisions à enjeux élevés, ce qui apporte de l’efficacité, mais aussi des risques éthiques. Prise de décision automatisée les systèmes sont utilisés dans le recrutement (sélection des candidats à un emploi), l'application de la loi (police prédictive ou recommandations de peine), finances (notation de crédit), et les soins de santé (diagnostic ou suggestions de traitement). La crainte est que ces systèmes d’IA puissent faire décisions injustes ou incorrectes qui ont un impact significatif sur la vie des gens, sans surveillance adéquate. Par exemple, certaines entreprises ont déployé des outils de recrutement basés sur l'IA pour classer les candidats, mais ont découvert que les algorithmes reproduisaient des biais (comme dans le cas d'Amazon concernant les préjugés sexistes)..

Dans le domaine policier, les algorithmes prédictifs qui signalent les individus susceptibles de récidiver ont été critiqués pour leur partialité raciale. L'enquête de ProPublica sur COMPAS a révélé que les accusés noirs étaient beaucoup plus susceptibles d'être classés à tort comme à haut risque que les blancs, en raison de la façon dont l'algorithme a été formé.Dans le domaine de la santé, un système d’IA pourrait par inadvertance donner la priorité au traitement d’un groupe plutôt qu’à un autre si les données de formation sous-représentent certaines populations. « biais d'automatisation » Il existe également un risque : les humains peuvent trop faire confiance à la décision d’une IA et ne pas la vérifier, même lorsqu’elle est erronée. transparence (discuté ensuite) aggrave cela.

Les entreprises qui utilisent l'IA pour prendre des décisions doivent mettre en place des mesures de protection : vérification humaine des résultats de l'IA, tests de biais et critères clairs pour savoir quand contourner l'IA. L'objectif doit être d'utiliser l'IA comme un outil d'aide à la décision, et non comme un juge, un jury et un bourreau.

Manque de transparence et d'explicabilité (le problème de la « boîte noire »)

De nombreux modèles d’IA, en particulier les réseaux complexes d’apprentissage profond, fonctionnent comme boîtes noires – leur fonctionnement interne et leur logique décisionnelle sont difficilement interprétables par les humains. Ce manque de transparence pose un sérieux problème éthique : si ni les utilisateurs ni les créateurs ne peuvent expliquer pourquoi une IA a pris une décision donnée, comment pouvons-nous lui faire confiance ou la tenir responsable ?

Pour les entreprises, il ne s'agit pas d'une simple inquiétude. Imaginez une banque refusant un prêt à un client via un algorithme d'IA : conformément à la réglementation et aux principes éthiques fondamentaux, le client mérite une explication. Mais si le modèle est trop opaque, la banque risque de ne pas être en mesure de justifier sa décision, ce qui entraînera des problèmes de conformité et une méfiance des clients. Les manquements à la transparence ont déjà suscité des réactions négatives ; par exemple, lorsque l'algorithme de carte de crédit d'Apple a été accusé d'offrir des limites de crédit plus basses aux femmes, l'absence d'explication a alimenté les critiques de partialité.

Explicabilité est crucial dans des domaines sensibles comme la santé (les médecins doivent comprendre un diagnostic d'IA) et la justice pénale (les accusés doivent savoir pourquoi un outil d'IA les a qualifiés de « à haut risque »). Le principe éthique de l'IA « interprétabilité » Il est nécessaire de concevoir des systèmes capables de justifier leurs résultats de manière compréhensible par l'homme. Des techniques comme l'IA explicable (XAI) peuvent contribuer à éclairer les modèles de boîte noire, et certaines réglementations (par exemple, la future loi européenne sur l'IA) imposent des obligations de transparence..

En fin de compte, les gens ont le droit de savoir comment les décisions d’IA qui les concernent sont prises – et les entreprises qui accordent la priorité à l’explicabilité seront récompensées par une plus grande confiance des parties prenantes.

Impact environnemental de l'IA (empreinte énergétique et carbone)

Bien que souvent négligé, le impact environnemental L'IA est une préoccupation éthique émergente pour les entreprises engagées dans le développement durable. L'entraînement et le déploiement de grands modèles d'IA nécessitent des ressources de calcul intensives, qui consomment beaucoup d'électricité et peuvent engendrer une empreinte carbone conséquente. Un exemple frappant : l'entraînement du modèle GPT-3 d'OpenAI (avec 175 milliards de paramètres) a consommé environ 1 287 MWh d'électricité et émis plus de 500 tonnes de dioxyde de carbone. – l’équivalent des émissions annuelles de plus de 100 voitures à essence.

À mesure que les modèles d’IA deviennent plus complexes (GPT-4, etc.), leur consommation d’énergie monte en flèche, soulevant des questions sur les émissions de carbone et même la consommation d’eau pour le refroidissement des centres de données.. Les entreprises qui adoptent l'IA à grande échelle ont la responsabilité sociale d'entreprise de prendre en compte ces impacts. L'IA, très énergivore, est non seulement incompatible avec les objectifs climatiques, mais peut également s'avérer coûteuse face à la hausse des prix de l'énergie.

Heureusement, cette préoccupation éthique s'accompagne de solutions concrètes : les entreprises peuvent adopter des architectures plus économes en énergie, faire appel à des fournisseurs de cloud alimentés par des énergies renouvelables et évaluer soigneusement si les avantages d'un modèle d'IA géant l'emportent sur son coût environnemental. En intégrant l'empreinte carbone de l'IA à l'évaluation des risques éthiques, les organisations alignent leur stratégie d'IA sur des engagements plus larges en matière de développement durable.

En résumé, une IA responsable ne se limite pas à l’équité et à la confidentialité : elle implique également de développer l’IA de manière respectueuse de l’environnement afin de garantir que les progrès technologiques ne se fassent pas au détriment de notre planète.

Préoccupations éthiques liées à l'IA dans différents secteurs

Les défis éthiques liés à l'IA se manifestent de manières spécifiques selon les secteurs. Une solution adaptée à un domaine peut s'avérer inadaptée à un autre. Les dirigeants d'entreprise doivent donc tenir compte du contexte spécifique.

Les défis éthiques liés à l'IA se manifestent de manières spécifiques selon les secteurs. Une solution adaptée à un domaine peut s'avérer inadaptée à un autre. Les dirigeants d'entreprise doivent donc tenir compte du contexte spécifique.

Voici un aperçu de la façon dont Préoccupations éthiques liées à l'IA se jouent dans divers secteurs :

L'IA dans le secteur de la santé : risques éthiques liés à l'IA médicale et à la confidentialité des patients

Dans le domaine de la santé, l’IA promet de meilleurs diagnostics et des traitements personnalisés, mais les erreurs ou les biais peuvent littéralement être une question de vie ou de mort.

Les préoccupations éthiques liées à l’IA médicale incluent : précision et biais – si un outil de diagnostic d’IA est principalement formé sur un groupe démographique, il peut mal diagnostiquer d’autres groupes (par exemple, sous-détection de maladies chez les minorités) ; responsabilité – si un système d’IA fait une recommandation néfaste, le médecin ou le fournisseur du logiciel est-il responsable ? ; et confidentialité des patients – les données de santé sont extrêmement sensibles et leur utilisation pour former l’IA ou déployer l’IA dans la surveillance des patients peut porter atteinte à la vie privée si elles ne sont pas correctement contrôlées.

Par exemple, il a été constaté qu'un système d'IA utilisé pour prioriser les patients en vue d'une transplantation rénale attribuait systématiquement des scores d'urgence inférieurs aux patients noirs en raison de données historiques biaisées, ce qui soulève des problèmes d'équité dans les soins. De plus, l'IA médicale fonctionne souvent de manière occultée, ce qui est problématique : les médecins doivent expliquer aux patients pourquoi un traitement leur a été recommandé.

Les atteintes à la vie privée constituent une autre préoccupation : certains hôpitaux utilisent l'IA pour analyser les images ou les données génétiques des patients ; sans une gouvernance rigoureuse des données, les informations des patients risquent d'être divulguées. Pour y remédier, les établissements de santé adoptent des solutions. « Comités d'éthique de l'IA » examiner les algorithmes pour détecter les biais et exiger que les outils d’IA fournissent des explications que les cliniciens peuvent valider.

Le maintien du consentement éclairé (les patients doivent savoir quand l’IA est impliquée dans leurs soins) et le respect des réglementations telles que HIPAA pour la protection des données sont également essentiels pour déployer l’IA de manière éthique en médecine.

L'IA dans la finance : trading algorithmique, approbations de prêts et biais dans la notation de crédit

Le secteur financier a adopté l'IA pour tous ses aspects, du trading automatisé à l'évaluation de crédit et à la détection des fraudes. Ces applications comportent toutefois des risques éthiques. Dans le trading algorithmique, les systèmes d'IA exécutent des transactions à grande vitesse et en grand volume ; si cela peut accroître l'efficacité du marché, cela soulève également des inquiétudes quant à la fiabilité. manipulation du marché et des krachs éclair déclenchés par des algorithmes incontrôlables. Les institutions financières doivent s'assurer que leurs IA de trading opèrent dans le respect des limites éthiques et légales, avec des coupe-circuits pour éviter une volatilité excessive.

Dans le domaine de la finance à la consommation, l'IA est au cœur de la stratégie approbation de prêt et notation de crédit Il a été constaté que les systèmes présentent parfois des préjugés discriminatoires, par exemple : biais algorithmique Cela a eu pour conséquence que les femmes obtenaient des limites de crédit nettement inférieures à celles des hommes ayant un profil similaire (comme l'a montré la controverse autour de l'Apple Card). De tels préjugés peuvent enfreindre les lois sur l'équité en matière de prêt et renforcer les inégalités.

De plus, le manque d'explications dans les décisions de crédit peut laisser les emprunteurs dans l'ignorance des raisons du refus, ce qui est à la fois contraire à l'éthique et potentiellement non conforme à la réglementation. Se pose également la question de confidentialité: les entreprises fintech utilisent l'IA pour analyser les données des clients afin de proposer des offres personnalisées, mais l'utilisation de données financières personnelles sans consentement clair peut rompre la confiance.

Les régulateurs financiers examinent de plus en plus attentivement les modèles d'IA pour en vérifier l'équité et la transparence. Par exemple, le Bureau de la protection financière des consommateurs des États-Unis a averti que les algorithmes de type « boîte noire » ne constituent pas un rempart contre la responsabilité. Les établissements financiers commencent donc à réaliser des audits de biais sur leur IA (afin de détecter les impacts disparates sur les catégories protégées) et à mettre en œuvre des techniques d'IA explicables afin que chaque décision automatisée de prêt ou d'assurance puisse être justifiée auprès du client et des régulateurs.

L’IA éthique dans la finance signifie en fin de compte équilibrer l’innovation avec l’équité, la transparence et des contrôles de risques robustes.

L'IA dans l'application de la loi : police prédictive, surveillance et droits de l'homme

Nulle part les préoccupations éthiques liées à l'IA ne sont aussi controversées que dans les domaines de l'application de la loi et de la sécurité. Les services de police et de sécurité déploient l'IA pour police prédictive – des algorithmes qui analysent les données criminelles pour prédire où les crimes pourraient se produire ou qui pourrait récidiver. Le problème éthique réside dans le fait que ces systèmes peuvent renforcer les biais existants dans les données policières (surveillance policière excessive dans certains quartiers, par exemple) et conduire à un profilage injuste des communautés de couleur.

Aux États-Unis, les outils de police prédictive ont été critiqués pour leur ciblage injuste des quartiers minoritaires en raison de données historiques biaisées sur la criminalité, automatisant ainsi les préjugés raciaux sous couvert de technologie. Cela soulève des questions. graves problèmes de droits de l'homme, car les gens pourraient être surveillés ou même arrêtés en raison d'une suggestion d'un algorithme plutôt que d'un acte répréhensible réel.

De plus, l’IA de reconnaissance faciale est utilisée par les forces de l’ordre pour identifier les suspects, mais des études ont montré qu’elle est beaucoup moins précise pour les femmes et les personnes à la peau plus foncée, ce qui conduit à de fausses arrestations dans certains cas très médiatisés d’erreur d’identité.

Le recours à l'IA pour la surveillance (de la reconnaissance faciale sur les caméras de vidéosurveillance publiques au suivi des individus via leur empreinte numérique) doit être mis en balance avec le droit à la vie privée et les libertés civiles. Les utilisations autoritaires de l'IA dans le maintien de l'ordre (comme la surveillance invasive des réseaux sociaux ou un système de crédit social) démontrent comment l'IA peut permettre oppression numérique.

Les entreprises qui vendent de l’IA à des agences gouvernementales sont également soumises à un contrôle éthique. Par exemple, les employés du secteur technologique de certaines entreprises ont protesté contre des projets qui fournissent des outils de surveillance de l’IA aux gouvernements, perçus comme violant les droits de l’homme.

La clé réside dans la mise en œuvre de l'IA avec des garanties : garantir un contrôle humain sur toute décision policière fondée sur l'IA, tester rigoureusement les biais et reformer les modèles, et garantir une responsabilité et une transparence claires envers le public. Certaines juridictions ont même interdit l'utilisation de la reconnaissance faciale par la police en raison de ces préoccupations.

Au minimum, les forces de l’ordre devraient suivre des directives éthiques strictes et des audits indépendants lorsqu’elles utilisent l’IA, afin d’empêcher que la technologie n’exacerbe l’injustice.

L'IA dans l'éducation : biais de notation, confidentialité des étudiants et risques liés à l'apprentissage personnalisé

L'éducation est un autre domaine qui connaît une adoption rapide de l'IA, des systèmes de notation automatisés aux applications d'apprentissage personnalisées et aux outils de surveillance. Ces évolutions suscitent des préoccupations éthiques. équité, exactitude et confidentialité Les systèmes de notation basés sur l'IA (utilisés pour les dissertations ou les examens) ont été critiqués lorsqu'il a été constaté qu'ils notaient de manière inégale. Par exemple, un algorithme utilisé pour prédire les résultats des étudiants aux tests au Royaume-Uni a connu une notoriété inquiétante. rétrogradé de nombreux élèves issus d’écoles défavorisées en 2020, ce qui a provoqué un tollé national et un revirement politique.

Cela a mis en évidence le risque de biais dans l’IA éducative, où un modèle unique peut ne pas tenir compte des divers contextes des apprenants, impactant injustement l’avenir (admissions à l’université, bourses) sur la base de jugements algorithmiques erronés.

Apprentissage personnalisé Les plateformes utilisent l'IA pour adapter le contenu à chaque étudiant, ce qui peut être bénéfique, mais si les recommandations de l'algorithme catégorisent les étudiants ou renforcent les biais (par exemple, en suggérant des parcours professionnels différents selon le sexe), cela peut limiter les opportunités. Une autre préoccupation majeure est confidentialité des étudiantsL'IA des technologies éducatives collecte souvent des données sur les performances et le comportement des étudiants, et même sur les vidéos prises par webcam lors des examens en ligne. Sans contrôle strict, ces données pourraient être utilisées à mauvais escient ou compromises.

L'IA de surveillance des examens à distance, qui surveille les mouvements oculaires et le bruit ambiant, a suscité des controverses. Certains la considèrent comme invasive et sujette à de fausses accusations de tricherie (par exemple, signaler un élève qui détourne le regard en raison d'un handicap). Les écoles et les entreprises du secteur de l'éducation doivent aborder ces questions en faisant preuve de transparence sur l'utilisation de l'IA, en garantissant que les décisions prises en la matière sont révisables par des enseignants et en protégeant les données des élèves.

Impliquer les enseignants et les éthiciens dans la conception de l'IA éducative peut contribuer à aligner la technologie sur les valeurs pédagogiques et l'équité. À terme, l'IA devrait améliorer l'apprentissage et préserver l'intégrité académique. sans compromettre les droits des étudiants ou traiter les apprenants de manière injuste.

L'IA dans les médias sociaux : fausses nouvelles, chambres d'écho et manipulation algorithmique

Les plateformes de médias sociaux fonctionnent grâce à des algorithmes d’IA qui décident du contenu que les utilisateurs voient – ce qui a suscité des débats éthiques sur leur influence sur la société. Algorithmes de recommandation de contenu peut créer chambres d'écho qui renforcent les croyances existantes des utilisateurs, contribuant ainsi à la polarisation politique.

Ils peuvent également promouvoir par inadvertance de la désinformation ou du contenu extrême, car les publications sensationnelles génèrent davantage d’engagement – un conflit éthique classique entre le profit (revenus publicitaires issus de l’engagement) et le bien-être sociétal.

Nous avons vu Facebook, YouTube, Twitter et d’autres être critiqués pour leurs flux algorithmiques qui amplifiaient les fausses nouvelles pendant les élections ou permettaient la propagation de théories du complot nuisibles.

Le scandale Cambridge Analytica a révélé comment les données et le ciblage par IA ont été utilisés pour manipuler les opinions des électeurs, soulevant des questions sur les limites éthiques de l'IA dans la publicité politique.

Deepfakes et bots Sur les réseaux sociaux (profils et publications générés par l’IA), les choses se compliquent encore davantage, car ils peuvent simuler des mouvements populaires ou un consensus public, trompant ainsi les vrais utilisateurs.

D’un point de vue commercial, les entreprises de médias sociaux risquent des mesures réglementaires si elles ne parviennent pas à contrôler la désinformation générée par l’IA et à protéger les utilisateurs (en effet, de nombreux pays envisagent désormais des lois obligeant les plateformes à assumer la responsabilité des recommandations de contenu).

La confiance des utilisateurs est également en jeu : si les utilisateurs ont le sentiment que l’IA de la plateforme les manipule ou viole leur vie privée en ciblant des publicités micro, ils peuvent fuir.

Les entreprises de médias sociaux ont commencé à mettre en œuvre des mesures éthiques en matière d'IA, telles qu'une modération améliorée du contenu avec des systèmes hybrides IA-humain, la rétrogradation du faux contenu et l'offre aux utilisateurs de plus de contrôle (par exemple, la possibilité de voir un flux chronologique au lieu d'un flux algorithmique).

Cependant, la tension demeure : les algorithmes optimisés uniquement pour l’engagement peuvent entrer en conflit avec l’intérêt public.

Pour une IA responsable, les entreprises de médias sociaux devront continuellement ajuster leurs algorithmes afin de donner la priorité qualité de l'information et le bien-être des utilisateurs, et soyez transparent sur la façon dont le contenu est classé.

La collaboration avec des vérificateurs de faits externes et l’étiquetage clair des médias générés ou manipulés par l’IA sont également des étapes clés pour atténuer les problèmes éthiques dans ce secteur.

L'IA dans l'emploi : suppression d'emplois, embauche automatisée et surveillance du lieu de travail

L'impact de l'IA sur le monde du travail soulève des préoccupations éthiques et socio-économiques pour les entreprises et la société. L'un des principaux enjeux est déplacement d'emploi:Alors que l’IA et l’automatisation prennent en charge les tâches (des robots de fabrication aux chatbots de service client IA), de nombreux travailleurs craignent de perdre leur emploi.

Si l’histoire montre que la technologie crée de nouveaux emplois tout en en détruisant d’autres, la transition peut être douloureuse et inégale. Les dirigeants d’entreprise sont confrontés à une question éthique quant à la manière dont ils mettent en œuvre les gains d’efficacité liés à l’IA : vont-ils simplement réduire leurs effectifs pour augmenter leurs bénéfices, ou vont-ils recycler et redéployer leurs employés vers de nouveaux rôles ?

Les approches responsables impliquent des initiatives de développement de la main-d’œuvre, dans lesquelles les entreprises améliorent les compétences des employés pour travailler aux côtés de l’IA (par exemple, en formant les ouvriers des chaînes de montage à gérer et à programmer les robots qui pourraient remplacer certaines tâches manuelles).

Un autre domaine est recrutement automatisé:Outre les problèmes de biais évoqués précédemment, il existe un problème éthique lié au fait de traiter les candidats uniquement comme des points de données. Une dépendance excessive au filtrage par l’IA peut signifier que d’excellents candidats sont éliminés en raison de particularités dans leur CV ou d’un manque de qualifications conventionnelles, et les candidats peuvent ne pas recevoir de retour si un algorithme a pris la décision.

Assurer une touche humaine dans le recrutement – par exemple, l’IA peut aider à réduire le nombre de candidats, mais les décisions finales et les entretiens impliquent un jugement humain – tend à conduire à des résultats plus justes.

Surveillance du lieu de travail est également de plus en plus rendu possible par l’IA : des outils existent pour surveiller l’utilisation des ordinateurs par les employés, suivre les mouvements ou même analyser le ton des communications pour évaluer le sentiment. Bien que les entreprises aient intérêt à la sécurité et à la productivité, la surveillance invasive peut violer la vie privée des employés et créer une culture de méfiance.

D'un point de vue éthique, les entreprises devraient faire preuve de transparence quant à toute surveillance par IA utilisée et permettre aux employés de s'exprimer sur ces pratiques (dans le cadre des exigences légales). Les syndicats et les régulateurs sont attentifs à ces tendances, et un recours excessif à la surveillance par IA pourrait entraîner des poursuites judiciaires ou nuire à la réputation de l'entreprise.

En résumé, l'IA dans l'emploi devrait idéalement compléter les travailleurs humains, et non les remplacer ou les opprimer arbitrairement. Une approche centrée sur l'humain – traiter les employés avec dignité, les impliquer dans la mise en œuvre des changements liés à l'IA et atténuer les impacts négatifs – est essentielle pour une utilisation éthique de l'IA sur le lieu de travail.

Échecs éthiques de l'IA dans le monde réel et leçons apprises

Rien n'illustre mieux les préoccupations éthiques liées à l'IA que des études de cas réels où les choses ont mal tourné. Plusieurs échecs retentissants ont fourni des mises en garde et de précieux enseignements aux entreprises sur ce qui se passe. pas faire.

Rien n'illustre mieux les préoccupations éthiques liées à l'IA que des études de cas réels où les choses ont mal tourné. Plusieurs échecs retentissants ont fourni des mises en garde et de précieux enseignements aux entreprises sur ce qui se passe. pas faire.

Examinons-en quelques-uns :

Outil de recrutement d'Amazon basé sur l'IA et les préjugés sexistes

L'échec : Amazon a développé un moteur de recrutement basé sur l'IA pour évaluer automatiquement les CV et identifier les meilleurs talents. Cependant, il s'est avéré que le système était fortement biaisé envers les femmes.

Formée à partir d'une décennie de CV (principalement de candidats masculins du secteur technologique), l'IA a appris à privilégier les candidatures masculines. Elle a commencé à déclasser les CV contenant la mention « féminin » (comme « capitaine de club d'échecs féminin ») et ceux provenant d'universités féminines..

En 2015, Amazon a réalisé que l'outil n'était pas neutre en termes de genre et qu'il était effectivement discriminer les candidatesMalgré les tentatives de peaufiner le modèle, ils ne pouvaient pas garantir qu'il ne trouverait pas de nouvelles façons d'être biaisé, et le projet a finalement été abandonné..

Leçon apprise : Ce cas illustre les dangers d'un déploiement de l'IA sans contrôle adéquat des biais. L'intention d'Amazon n'était pas de discriminer ; le biais était une propriété émergente des données historiques et des algorithmes non vérifiés.

Pour les entreprises, la leçon à retenir est de tester rigoureusement les modèles d’IA pour détecter des impacts différents. avant Les utiliser lors de recrutements ou d'autres décisions sensibles. Il est essentiel d'utiliser des données de formation diversifiées et de faire appel à des experts pour vérifier les biais des algorithmes.

L’expérience d’Amazon souligne également que l’IA doit augmenter, et non remplacer, le jugement humain dans le recrutement ; les recruteurs doivent rester vigilants et ne pas faire aveuglément confiance à un algorithme de notation.

Les conséquences pour Amazon ont été un embarras interne et un exemple public de « ce qui peut mal tourner » – d’autres entreprises citent désormais ce cas pour plaider en faveur d’une conception plus responsable de l’IA..

En bref: Les biais algorithmiques peuvent se cacher dans l'IA : il faut les détecter et les corriger rapidement. pour éviter des échecs coûteux.

Controverse sur l'éthique de l'IA chez Google et opposition des employés

L'échec : En 2020, Google, leader de l'IA, a connu des troubles internes lorsqu'un éminent chercheur en éthique de l'IA, le Dr Timnit Gebru, a quitté l'entreprise dans des circonstances controversées. Gebru, co-responsable de l'équipe IA éthique de Google, avait co-écrit un article soulignant les risques des grands modèles linguistiques (le type d'IA qui alimente la recherche et les produits de Google).

Elle affirme que Google l'a poussée à partir parce qu'elle avait soulevé des problèmes d'éthique, alors que la position officielle de Google était qu'il y avait des divergences sur le processus de publication.L'incident est rapidement devenu public et plus de 1 200 employés de Google ont signé une lettre de protestation contre son licenciement, accusant Google de censurer des recherches critiques..

Cette décision fait suite à d'autres controverses, comme la dissolution du conseil d'éthique de l'IA créé par Google en 2019 en raison du tollé suscité par la sélection de ses membres. L'incident de Gebru a notamment suscité un débat mondial sur l'engagement des géants de la tech en faveur d'une IA éthique et sur le traitement des lanceurs d'alerte.

Leçon apprise : La tourmente de Google enseigne aux entreprises que Les préoccupations éthiques liées à l’IA doivent être prises au sérieux au plus haut niveau, et ceux qui les soulèvent doivent être entendus et non réduits au silence.La réaction des employés a montré qu’un manque de transparence et de responsabilité dans la gestion des problèmes d’éthique interne peut gravement nuire au moral et à la réputation.

Pour les entreprises, il est essentiel de développer une culture de réflexion éthique autour de l'IA : encouragez vos équipes à s'interroger sur ses impacts et récompensez les objecteurs de conscience plutôt que de les sanctionner. Cet épisode a également mis en lumière la nécessité d'une surveillance externe : beaucoup ont avancé que des comités d'éthique indépendants ou des audits par des tiers auraient pu empêcher l'escalade du conflit.

En substance, l'expérience de Google est un avertissement : même les entreprises d'IA les plus avancées ne sont pas à l'abri de manquements à l'éthique. Le coût a porté atteinte à la crédibilité de Google en matière d'IA responsable. Les organisations devraient donc intégrer l'éthique à leur processus de développement de l'IA et s'assurer que la direction soutient cette mission, afin d'éviter les controverses publiques et la perte de confiance.

Clearview AI et le débat sur la confidentialité de la reconnaissance faciale

L'échec : Clearview AI, une startup de reconnaissance faciale, a créé un outil controversé en récupérant plus de 3 milliards de photos sur les réseaux sociaux et les sites Web sans autorisation.Elle a créé une application permettant aux clients (y compris les forces de l'ordre) de télécharger une photo d'une personne et de trouver des correspondances sur Internet, érodant ainsi essentiellement l'anonymat.

Lorsque le New York Times a révélé l'affaire Clearview en 2020, une vive polémique s'est ensuivie concernant la confidentialité et le consentement. Les autorités de régulation de plusieurs pays ont constaté que Clearview avait enfreint les lois sur la protection de la vie privée. Par exemple, l'entreprise a été poursuivie dans l'Illinois en vertu de la loi sur la confidentialité des informations biométriques et a finalement accepté de limiter la vente de son service..

Clearview a été condamnée à des amendes de plusieurs millions de dollars en Europe pour traitement illégal de données. Le public s'est inquiété de l'utilisation des photos de n'importe qui (votre profil Facebook ou LinkedIn, par exemple) pour identifier et suivre des personnes à leur insu. Cette affaire est devenue l'exemple type d'une surveillance par IA poussée trop loin.

Leçon apprise : Clearview AI illustre que Ce n'est pas parce que l'IA peut faire quelque chose qu'elle doit le faireD'un point de vue éthique et commercial, ignorer les normes de confidentialité peut entraîner de graves réactions négatives et des conséquences juridiques. Les entreprises utilisant la reconnaissance faciale ou l'IA biométrique doivent obtenir le consentement préalable à l'utilisation des données et garantir le respect de la réglementation. Tout manquement à cette obligation peut compromettre leur modèle économique.

Les difficultés rencontrées par Clearview ont également incité des entreprises technologiques comme Google et Facebook à exiger l'arrêt du scraping de leurs données. Cet épisode souligne l'importance d'intégrer la protection de la vie privée dès la conception des produits d'IA. Pour les décideurs politiques, ce fut un signal d'alarme : des règles plus strictes sont nécessaires pour les technologies de surveillance par l'IA.

La leçon pour les entreprises est claire : l’acceptation sociale des produits d’IA est essentielle. Si les gens estiment qu’une application d’IA porte atteinte à leur vie privée ou à leurs droits humains, ils s’y opposeront avec force (par le biais des tribunaux, de l’opinion publique et de la réglementation). IA responsable Il faut trouver un équilibre entre innovation, respect de la vie privée et des limites éthiques. Ceux qui ne parviennent pas à trouver cet équilibre, comme l'a appris Clearview, s'exposent à de lourdes conséquences.

Désinformation générée par l'IA pendant les élections

L'échec : Lors des récents cycles électoraux, nous avons constaté des cas où l'IA a été utilisée (ou détournée) pour générer des contenus trompeurs, suscitant des inquiétudes quant à l'intégrité des processus démocratiques. Un exemple s'est produit lors des élections internationales de 2024 : des observateurs ont découvert des dizaines d'images générées par l'IA et de vidéos deepfakes circulant sur les réseaux sociaux pour diffamer des candidats ou semer la confusion. Dans un cas, une vidéo deepfake d'un candidat à la présidentielle est apparue, le montrant faussement en train de tenir des propos incendiaires. Elle a été rapidement démentie, mais non sans avoir recueilli des milliers de vues.

De même, des réseaux de robots pilotés par l'IA ont été déployés pour inonder les forums de discussion de propagande. S'il est difficile d'identifier un seul « échec » électoral imputable uniquement à l'IA, le volume croissant de Désinformation générée par l'IA est perçu comme un échec des plateformes technologiques à garder une longueur d'avance sur les mauvais acteurs. préoccupation est devenu si important que les experts et les responsables ont mis en garde contre un « danger de deepfake » avant les élections majeures, et des organisations comme le Forum économique mondial ont qualifié la désinformation générée par l'IA de risque mondial grave à court terme..

Leçon apprise : La propagation de la désinformation électorale générée par l’IA enseigne aux parties prenantes – en particulier aux entreprises technologiques et aux décideurs politiques – que des mesures proactives sont nécessaires pour défendre la vérité à l'ère de l'IALes entreprises de médias sociaux ont appris qu’elles doivent améliorer les systèmes de détection d’IA pour détecter les faux contenus et se coordonner avec les autorités électorales pour supprimer ou signaler rapidement les médias trompeurs.

Il y a aussi une leçon à tirer de l'éducation publique : les citoyens sont désormais encouragés à se méfier des médias sensationnalistes et à vérifier leurs sources, devenant ainsi des vérificateurs de faits contre les faux témoignages d'IA. Pour les entreprises du secteur des médias sociaux, de la publicité ou des médias, investir dans des technologies d'authentification de contenu (comme les filigranes pour les contenus authentiques ou les enregistrements blockchain pour les vidéos) peut constituer un facteur de différenciation éthique.

Sur le plan politique, ce problème a suscité des appels à une réglementation plus stricte des publicités politiques et des deepfakes. En résumé, la lutte contre la désinformation alimentée par l'IA lors des élections met en lumière la responsabilité de ceux qui déploient l'IA d'anticiper les abus. Une pratique éthique de l'IA ne se limite pas à son utilisation directe, mais se préoccupe également de la manière dont votre technologie pourrait être instrumentalisée par d'autres, et de la prise de mesures pour atténuer ce risque.

Le pilote automatique de Tesla et l'éthique de l'IA dans les véhicules autonomes

L'échec : Le pilote automatique de Tesla – un système d'IA d'assistance à la conduite – a été impliqué dans plusieurs accidents, dont certains mortels, ce qui a soulevé des questions sur la fiabilité et la sécurité de la technologie de conduite semi-autonome. Un incident largement médiatisé en 2018 impliquait une Tesla en mode pilote automatique qui n'avait pas reconnu un semi-remorque traversant la route, entraînant un accident mortel. Les enquêtes ont révélé que le système d'assistance à la conduite n'était pas conçu pour les conditions routières rencontrées, mais son fonctionnement n'a pas été empêché..

D'autres accidents ont eu lieu où des conducteurs ont fait trop confiance au pilote automatique et sont devenus inattentifs, malgré les avertissements de Tesla les incitant à rester vigilants. D'un point de vue éthique, ces incidents mettent en évidence la zone grise entre la responsabilité du conducteur et celle du constructeur. La commercialisation de cette fonctionnalité par Tesla sous le nom d'« Autopilot » a été critiquée, car elle pourrait donner aux conducteurs un faux sentiment de sécurité.

En 2023, la National Highway Traffic Safety Administration des États-Unis a même examiné si les défauts de conception du pilote automatique contribuaient aux accidents, ce qui a conduit à des rappels et à des mises à jour logicielles.

Leçon apprise : L'affaire Tesla Autopilot souligne que la sécurité doit être primordiale dans le déploiement de l'IA, et la transparence sur les limites est essentielleLorsque des vies sont en jeu, comme dans les transports, diffuser une IA dont la sécurité n'est pas pleinement prouvée est éthiquement problématique. Tesla (et d'autres constructeurs de véhicules autonomes) ont appris à renforcer la surveillance du conducteur pour garantir l'attention des humains, et à clarifier dans la documentation que ces systèmes sont d'assistance et pas entièrement autonome.

Une autre leçon concerne la responsabilité : après que les premières enquêtes ont mis en cause une « erreur humaine », des analyses ultérieures ont également accusé Tesla d'avoir autorisé une utilisation en dehors des conditions prévues.Cela indique que les entreprises partageront la responsabilité si leur IA encourage les abus. Les constructeurs doivent intégrer des mesures de sécurité robustes, par exemple en interdisant au pilote automatique de fonctionner sur des routes non conçues pour lui, ou en rendant le contrôle au conducteur bien avant que la limite de performance du système ne soit atteinte.

D'un point de vue éthique, il est essentiel de communiquer clairement aux clients sur les capacités et les limites de l'IA (sans exagération). Pour toute entreprise déployant l'IA dans ses produits, l'expérience de Tesla rappelle qu'il faut anticiper l'inattendu et privilégier la sécurité dans la conception. Testez l'IA dans divers scénarios, surveillez-la en permanence sur le terrain et, si un problème d'éthique ou de sécurité survient, réagissez rapidement (par exemple, par des rappels, des mises à jour, voire la désactivation de fonctionnalités) avant que des dommages supplémentaires ne surviennent.

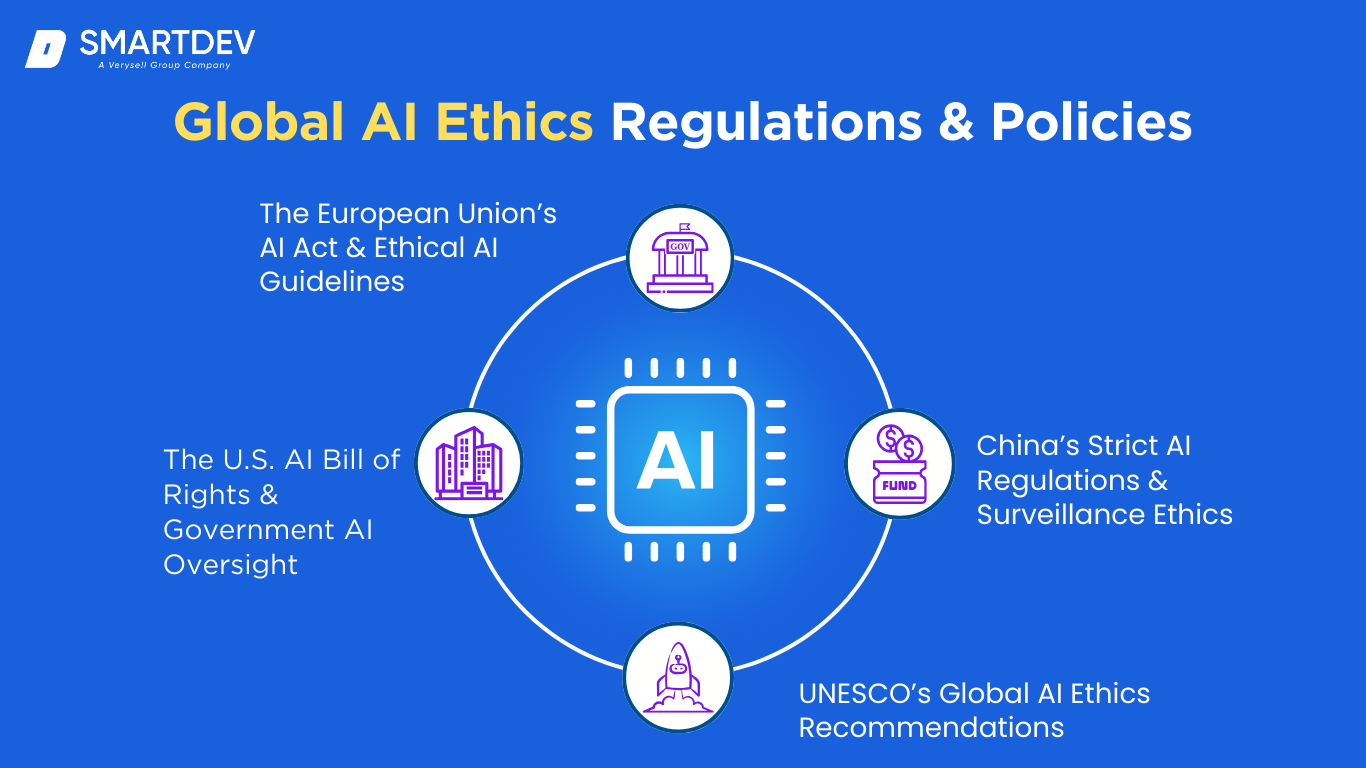

Réglementations et politiques mondiales en matière d'éthique de l'IA

Partout dans le monde, les gouvernements et les organismes de normalisation élaborent des cadres pour garantir un développement et une utilisation éthiques de l'IA. Il est crucial pour les entreprises de suivre ces politiques, car elles définissent les règles de l'innovation en matière d'IA.

Partout dans le monde, les gouvernements et les organismes de normalisation élaborent des cadres pour garantir un développement et une utilisation éthiques de l'IA. Il est crucial pour les entreprises de suivre ces politiques, car elles définissent les règles de l'innovation en matière d'IA.

Voici quelques initiatives mondiales majeures visant à résoudre ce problème. Préoccupations éthiques liées à l'IA:

Loi sur l'IA et lignes directrices éthiques de l'Union européenne en matière d'IA

L’UE prend l’initiative en matière de réglementation de l’IA avec sa prochaine Loi sur l'IA, qui devrait devenir le premier cadre juridique complet pour l'IA. La loi sur l'IA adopte une approche fondée sur les risques : elle catégorise les systèmes d'IA par niveau de risque (risque inacceptable, risque élevé, risque limité, risque minimal) et impose des exigences en conséquence. Elle interdira notamment purement et simplement certaines pratiques d'IA jugées trop néfastes, par exemple les systèmes de notation sociale comme ceux de la Chine ou la surveillance biométrique en temps réel en public (avec de rares exceptions).

L'IA à haut risque (comme les algorithmes utilisés pour le recrutement, le crédit, l'application de la loi, etc.) sera soumise à des obligations strictes en matière de transparence, d'évaluation des risques et de supervision humaine. L'objectif est de garantir IA digne de confiance qui défend les valeurs et les droits fondamentaux de l'UE. Les entreprises qui déploient l’IA en Europe devront se conformer à cette réglementation ou s’exposer à de lourdes amendes (de la même manière que le RGPD a imposé la protection de la vie privée).

En outre, l’UE dispose de règles non contraignantes Lignes directrices éthiques sur l'IA (élaborés par des experts en 2019) qui définissent des principes tels que la transparence, la responsabilité, la confidentialité et le bien-être sociétal – ceux-ci ont influencé l'approche de la loi sur l'IA. Pour les chefs d’entreprise, le principal point à retenir est que l’UE s’attend à ce que l’IA ait « garde-fous éthiques », et la conformité nécessitera de la diligence dans des domaines tels que la documentation des algorithmes, l’atténuation des biais et l’activation des droits des utilisateurs (comme les explications des décisions de l’IA).

La loi sur l'IA devrait être finalisée prochainement, et les entreprises avant-gardistes alignent déjà leurs systèmes d'IA sur ses dispositions afin d'éviter toute perturbation. L'impulsion réglementaire européenne est le signe que l'IA éthique est en passe de devenir une loi exécutoire.

Déclaration des droits de l'IA aux États-Unis et surveillance gouvernementale de l'IA

Aux États-Unis, bien qu'il n'existe pas encore de loi spécifique à l'IA aussi radicale que celle de l'UE, des initiatives importantes marquent l'orientation politique. Fin 2022, le Bureau de la politique scientifique et technologique de la Maison-Blanche a introduit une loi. Projet de charte des droits de l'IA – un ensemble de cinq principes directeurs pour la conception et le déploiement de systèmes d’IACes principes comprennent : Systèmes sûrs et efficaces (L'IA devrait être testée pour des raisons de sécurité), Protections contre la discrimination algorithmique (L’IA ne devrait pas faire de discrimination biaisée), Confidentialité des données (les utilisateurs doivent avoir le contrôle des données et la confidentialité doit être protégée), Avis et explication (les gens devraient savoir quand une IA est utilisée et comprendre ses décisions), et Alternatives humaines, considération et recours (il devrait y avoir des options humaines et la possibilité de se retirer de l’IA dans des scénarios critiques).

Bien que cette « Charte des droits de l'IA » n'ait pas force de loi, elle fournit un cadre politique aux agences fédérales et aux entreprises. Nous constatons également une surveillance accrue de l'IA par le biais des lois existantes : par exemple, la Commission pour l'égalité des chances en matière d'emploi (EEOC) examine les algorithmes de recrutement biaisés dans le cadre des lois anti-discrimination, et la Commission fédérale du commerce (FTC) a mis en garde contre les produits d'IA de type « charlatan », laissant entendre qu'elle utiliserait les lois de protection des consommateurs pour lutter contre les fausses allégations d'IA ou les pratiques néfastes.

Par ailleurs, des réglementations sectorielles spécifiques émergent : la FDA travaille à l'élaboration de lignes directrices pour l'IA dans les dispositifs médicaux, et les régulateurs financiers pour l'IA dans le secteur bancaire. Les décideurs politiques du Congrès ont proposé plusieurs projets de loi sur la transparence et la responsabilité de l'IA, mais aucun n'a encore été adopté.

Pour les entreprises opérant aux États-Unis, l'absence de loi unique ne signifie pas un manque de surveillance : les autorités réorientent la réglementation pour couvrir les impacts de l'IA (par exemple, une décision biaisée en matière d'IA peut toujours enfreindre la loi sur les droits civiques). L'alignement sur la esprit Mettre en œuvre dès maintenant la Déclaration des droits de l’IA – rendre les systèmes d’IA justes, transparents et contrôlables – est une stratégie judicieuse pour se préparer aux futures réglementations américaines, probablement plus formelles.

Réglementation stricte de l'IA et éthique de surveillance en Chine

La Chine dispose d'un environnement réglementaire très dynamique en matière d'IA, reflétant la volonté du gouvernement de favoriser la croissance de l'IA et de maîtriser ses impacts sociétaux. Contrairement aux approches occidentales qui privilégient les droits individuels, la gouvernance de l'IA en Chine est étroitement liée aux priorités de l'État (notamment la stabilité sociale et les valeurs du Parti). Ces dernières années, la Chine a mis en place des règles pionnières telles que la « Dispositions relatives à la gestion des recommandations algorithmiques des services d'information Internet » (en vigueur depuis mars 2022) qui obligent les entreprises à enregistrer leurs algorithmes auprès des autorités, être transparents quant à leur utilisation et ne pas s'engager dans des pratiques qui mettent en danger la sécurité nationale ou l'ordre social.

Ces règles imposent également aux utilisateurs la possibilité de désactiver les algorithmes de recommandation et exigent que ces derniers « promeuvent une énergie positive » (conformément au contenu approuvé). Début 2023, la Chine a introduit la Dispositions de synthèse profonde pour réglementer les deepfakes – en exigeant que les médias générés par l'IA soient clairement étiquetés et ne soient pas utilisés pour diffuser de fausses informations, sous peine de sanctions juridiques. En outre, la Chine a des projets de réglementation pour IA générative des services (comme les chatbots), exigeant que les résultats reflètent les valeurs socialistes fondamentales et ne portent pas atteinte au pouvoir de l'État.

Sur le plan éthique, si la Chine utilise massivement l'IA à des fins de surveillance (par exemple, la reconnaissance faciale pour le suivi des citoyens et un système de crédit social naissant), elle se préoccupe aussi paradoxalement de l'éthique dans la mesure où elle affecte la cohésion sociale. Par exemple, la Chine a interdit l'IA qui analyse les expressions faciales des candidats lors des entretiens d'embauche, la considérant comme une atteinte à la vie privée. Le gouvernement étudie également des lignes directrices éthiques en matière d'IA sur le plan académique, mais leur application se fait principalement par un contrôle strict et une censure.

Pour les entreprises opérant en Chine ou traitant des données de consommateurs chinois, le respect de ces réglementations détaillées est impératif : les algorithmes doivent être transparents, c'est-à-dire connus des régulateurs, et le contenu généré par l'IA est étroitement surveillé. Le débat éthique est ici complexe : les règles chinoises peuvent prévenir certains préjudices (comme la fraude deepfake), mais elles renforcent également la surveillance gouvernementale de l'IA et suscitent des inquiétudes quant à la liberté. Néanmoins, l'approche chinoise souligne un point essentiel : les gouvernements peuvent et vont exercer leur contrôle sur les technologies de l'IA pour répondre à leurs objectifs politiques, et les entreprises doivent gérer ces exigences avec prudence, sous peine d’être exclues d’un marché énorme.

Recommandations mondiales de l'UNESCO sur l'éthique de l'IA

Au niveau multinational, l'UNESCO a été le fer de lance d'un effort visant à créer un cadre éthique global pour l'IA. En novembre 2021, les 193 États membres de l'UNESCO ont adopté le Recommandation sur l'éthique de l'intelligence artificielle, le premier instrument mondial de normalisation sur l'éthique de l'IACe document complet n’est pas une loi contraignante, mais il fournit un point de référence commun pour les pays qui élaborent des politiques nationales en matière d’IA.

La recommandation de l'UNESCO énonce des valeurs et des principes tels que la dignité humaine, les droits de l'homme, la durabilité environnementale, la diversité et l'inclusion, et la paix, et préconise notamment que l'IA soit conçue pour respecter et promouvoir ces valeurs. Elle appelle à des actions telles que l'évaluation de l'impact de l'IA sur la société et l'environnement, l'éducation et la formation à l'IA éthique, et la coopération internationale en matière de gouvernance de l'IA.

Par exemple, elle suggère l'interdiction des systèmes d'IA manipulant le comportement humain et des mesures de protection contre l'utilisation abusive des données biométriques. Bien que de haut niveau, ces lignes directrices ont un poids moral et influencent les politiques. On constate déjà une convergence : la loi européenne sur l'IA et diverses stratégies nationales en la matière reprennent des thèmes issus des recommandations de l'UNESCO (comme l'évaluation des risques et la supervision humaine).

Pour les entreprises et les décideurs politiques, l'implication de l'UNESCO montre que l'éthique de l'IA est une préoccupation mondiale, et pas seulement nationale. Les entreprises opérant au-delà des frontières pourraient à terme être confrontées à une mosaïque de réglementations, mais le cadre de l'UNESCO pourrait favoriser une certaine harmonisation. Sur le plan éthique, cela rappelle que l'impact de l'IA transcende les frontières : des problématiques comme les deepfakes, les préjugés ou les armes autonomes ont une portée internationale et nécessitent une collaboration.

Les organisations doivent se tenir informées de ces normes mondiales, car elles précèdent souvent les réglementations concrètes. L'adhésion volontaire aux principes de l'UNESCO peut renforcer la réputation d'une entreprise en tant que leader éthique en matière d'IA et la préparer à l'évolution des attentes des gouvernements et du public mondial.

Normes ISO et IEEE pour une IA éthique

Au-delà des gouvernements, des organismes de normalisation comme ISO (Organisation internationale de normalisation) et IEEE (Institut des ingénieurs électriciens et électroniciens) élaborent des normes techniques pour guider le développement d'une IA éthique. Ces normes ne sont pas des lois, mais elles fournissent des bonnes pratiques et peuvent être adoptées dans le cadre de l'autorégulation du secteur ou des exigences d'approvisionnement.

L'ISO, par l'intermédiaire de son sous-comité SC 42 sur l'IA, travaille à l'élaboration de lignes directrices pour la gouvernance et la fiabilité de l'IA. Par exemple, la norme ISO/IEC 24028 se concentre sur l'évaluation de la robustesse des algorithmes d'apprentissage automatique, et la norme ISO/IEC 23894 fournit des orientations sur la gestion des risques liés à l'IA, aidant ainsi les organisations à identifier et à atténuer les risques tels que les biais, les erreurs ou les problèmes de sécurité.En suivant les normes ISO, une entreprise peut systématiquement aborder les aspects éthiques (équité, fiabilité, transparence) et disposer d’une documentation pour montrer aux auditeurs ou aux clients que la diligence raisonnable a été effectuée.

L'IEEE a adopté une approche très directe de l'éthique de l'IA avec son L'éthique dans les systèmes autonomes Initiative qui a produit la série de normes IEEE 7000. Celles-ci incluent notamment les normes IEEE 7001 pour la transparence des systèmes autonomes, IEEE 7002 pour la confidentialité des données en IA et IEEE 7010 pour l'évaluation de l'impact de l'IA sur le bien-être.. L'une des normes les plus importantes est la norme IEEE 7000-2021, un modèle de processus permettant aux ingénieurs de prendre en compte les préoccupations éthiques lors de la conception de systèmes – un véritable guide pratique pour une « éthique dès la conception ». Une autre norme, la norme IEEE 7003, traite des considérations relatives aux biais algorithmiques.

Adhérer aux normes IEEE peut aider les développeurs à intégrer des valeurs telles que l'équité ou l'explicabilité dès le départ dans leur technologie. Les entreprises commencent à rechercher des certifications ou des audits selon ces normes pour attester de leur fiabilité (par exemple, l'IEEE propose un programme de certification éthique en IA). L'avantage des normes est qu'elles proposent des listes de contrôle et des processus concrets pour mettre en œuvre des principes éthiques abstraits.

Lorsque les régulateurs cherchent à faire respecter l'éthique de l'IA, ils se réfèrent souvent à ces normes. Concrètement, une entreprise qui aligne ses projets d'IA sur les directives ISO/IEEE risque moins d'être prise au dépourvu par de nouvelles règles ou les préoccupations des parties prenantes. C'est un investissement dans qualité et gouvernance cela peut se traduire par une conformité plus fluide, de meilleurs résultats en matière d’IA et une confiance accrue des parties prenantes.

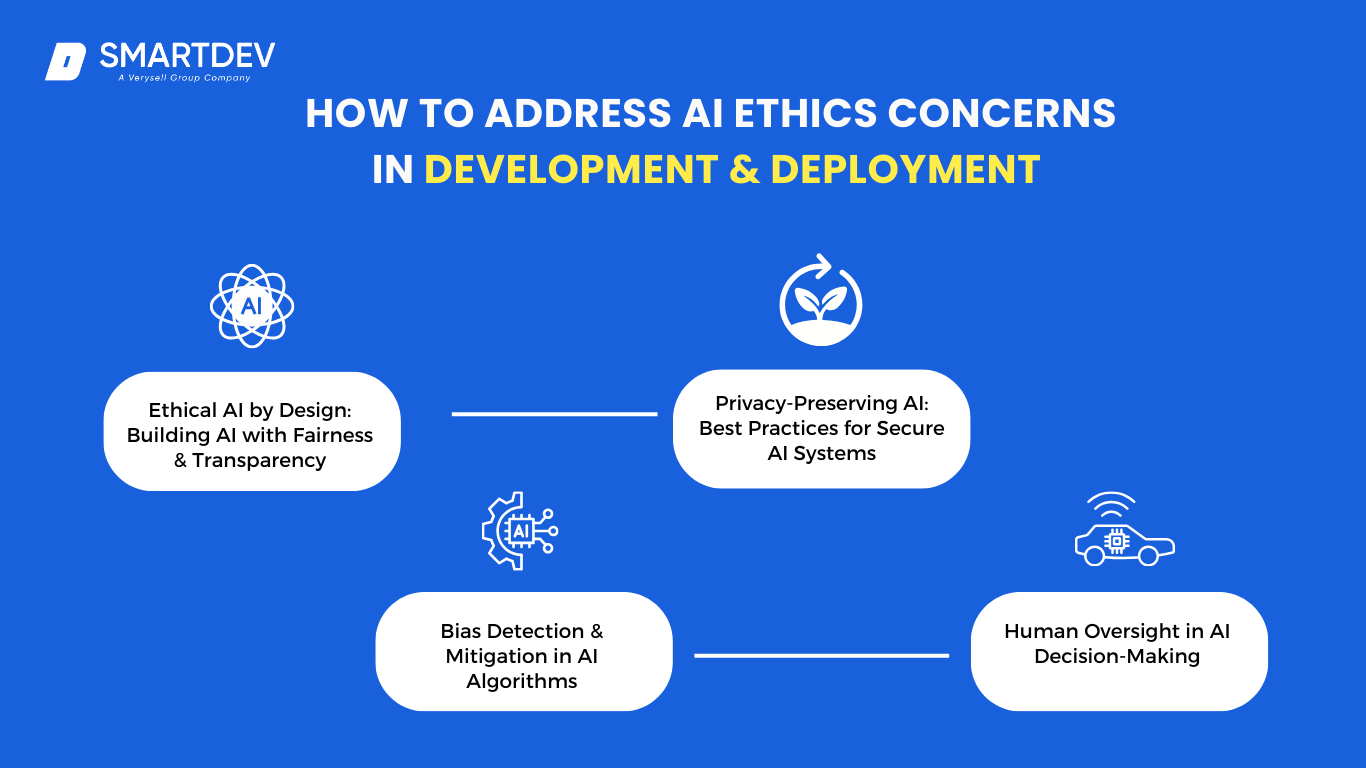

Comment répondre aux préoccupations éthiques liées au développement et au déploiement de l'IA

Comprendre les enjeux éthiques liés à l'IA n'est que la moitié du chemin à parcourir ; l'autre moitié consiste à prendre des mesures concrètes pour les résoudre lors de la conception ou de l'utilisation de systèmes d'IA. Pour les entreprises, une approche proactive et systématique de l'IA éthique peut transformer un risque potentiel en atout.

Comprendre les enjeux éthiques liés à l'IA n'est que la moitié du chemin à parcourir ; l'autre moitié consiste à prendre des mesures concrètes pour les résoudre lors de la conception ou de l'utilisation de systèmes d'IA. Pour les entreprises, une approche proactive et systématique de l'IA éthique peut transformer un risque potentiel en atout.

Voici quelques stratégies clés pour développer et déployer l'IA de manière responsable:

IA éthique dès la conception : construire une IA équitable et transparente

Tout comme les produits peuvent être conçus pour la sécurité ou la convivialité, les systèmes d’IA doivent être conçu pour l'éthique dès le départUne « IA éthique dès la conception » implique l'intégration de principes tels que l'équité, la transparence et la responsabilité dans le cycle de développement de l'IA. Concrètement, cela implique la mise en place d'un cadre ou d'une charte éthique de l'IA au sein de votre organisation (de nombreuses entreprises l'ont fait, comme en témoigne la forte augmentation des chartes éthiques de l'IA)..

Commencez chaque projet d'IA en identifiant les risques éthiques potentiels et les parties prenantes concernées. Par exemple, si vous concevez une IA d'approbation de prêt, identifiez le risque de discrimination et les parties prenantes (demandeurs, régulateurs, communauté) à prendre en compte. Ensuite, mettez en œuvre le projet. critères d'équité Objectifs du modèle : non seulement précision, mais aussi mesures visant à minimiser les biais entre les groupes. Choisir les données d'entraînement avec soin (diversifiées, représentatives et vérifiées pour détecter les biais avant utilisation).

De plus, concevez le système de manière à ce qu'il soit aussi transparent que possibleConservez une documentation sur la construction du modèle, l'utilisation de certaines fonctionnalités et ses performances sur différents segments de données. Dans la mesure du possible, privilégiez des modèles ou des techniques plus simples, comme l'IA explicative, qui peuvent fournir des codes de raisonnement pour les décisions. Si vous utilisez un modèle complexe, envisagez de créer un système complémentaire explicatif capable d'analyser le comportement du modèle principal.

Il est important d'impliquer une équipe diversifiée dans le processus de conception, incluant des personnes d'horizons différents, et même des éthiciens ou des experts du domaine capables d'identifier les problèmes que les développeurs pourraient manquer. En intégrant ces étapes dès les premières phases de conception (plutôt que de tenter d'adapter l'éthique en fin de processus), les entreprises peuvent éviter de nombreux écueils. Une IA éthique dès la conception envoie également le message aux employés : l'innovation responsable est une attente, et non une considération secondaire.

Cette approche permet de créer des produits d’IA qui non seulement fonctionnent bien, mais qui s’alignent également sur les valeurs sociétales et les attentes des utilisateurs dès le premier jour.

Détection et atténuation des biais dans les algorithmes d'IA

Étant donné que les biais dans l’IA peuvent être pernicieux et difficiles à détecter à l’œil nu, les organisations devraient mettre en œuvre des mesures formelles de détection. détection et atténuation des biais Processus. Commencez par tester les modèles d'IA sur différents groupes démographiques et segments clés avant leur déploiement. Par exemple, si vous disposez d'une IA qui examine les CV, évaluez ses recommandations en fonction des candidats masculins et féminins, des différents groupes ethniques, etc., afin de déterminer si les taux d'erreur ou les sélections sont inégaux. Des techniques comme l'analyse d'impact disparate (vérifiant si les décisions nuisent de manière disproportionnée à un groupe protégé) sont utiles.

Si des problèmes sont détectés, des mesures d'atténuation sont nécessaires : cela peut impliquer de réentraîner le modèle sur des données plus équilibrées, ou d'ajuster ses paramètres ou ses seuils de décision pour corriger le biais. Dans certains cas, vous pouvez mettre en œuvre des techniques algorithmiques telles que rééchantillonnage (équilibrage des données d'entraînement), repondération (en accordant plus d'importance aux exemples de classes minoritaires pendant la formation), ou en ajoutant des contraintes d'équité à l'objectif d'optimisation du modèle (afin qu'il essaie directement d'atteindre la parité entre les groupes).

Par exemple, une IA de reconnaissance d'images initialement confrontée à des problèmes de teint foncé pourrait être réentraînée avec des images plus diversifiées et, éventuellement, avec une architecture adaptée pour garantir une précision équivalente. Une autre mesure d'atténuation importante est la sélection des caractéristiques : veillez à ce que les attributs qui remplacent des caractéristiques protégées (le code postal peut représenter l'origine ethnique, par exemple) soient soigneusement traités ou supprimés s'ils ne sont pas absolument nécessaires. Documentez toutes ces interventions dans le cadre d'une responsabilité algorithmique rapport.

De plus, l'atténuation des biais n'est pas une solution ponctuelle ; elle nécessite une surveillance continue. Une fois l'IA en production, suivez les résultats par groupe démographique lorsque cela est possible. Si de nouveaux biais apparaissent (par exemple, une modification du flux de données ou un traitement différent pour un groupe d'utilisateurs), vous devez mettre en place un processus pour les détecter et les corriger.

Il existe également des outils et des boîtes à outils émergents (comme la bibliothèque open source AI Fairness 360 d'IBM) qui fournissent des indicateurs et des algorithmes facilitant la détection et l'atténuation des biais. Les entreprises peuvent les intégrer à leur processus de développement. En recherchant activement les biais et en optimisant les systèmes d'IA pour les réduire, les entreprises construisent des systèmes plus équitables et se protègent contre les plaintes pour discrimination.

Ce travail peut être difficile, car l’équité parfaite est difficile à atteindre et dépend souvent du contexte, mais démontrer un effort sincère et rigoureux contribue grandement à une pratique responsable de l’IA.

Supervision humaine dans la prise de décision en IA

Peu importe à quel point l’IA progresse, le maintien surveillance humaine est cruciale pour garantir l'éthique. L'idée de « l'intervention humaine » repose sur le principe selon lequel l'IA devrait assister, et non remplacer totalement, les décideurs humains dans de nombreux contextes, notamment lorsque les décisions ont des implications éthiques ou juridiques importantes. Pour mettre en œuvre ce principe, les entreprises peuvent mettre en place processus d'approbation L'IA fournit une recommandation qu'un humain valide ou annule avant toute action. Par exemple, une IA peut signaler une transaction financière comme frauduleuse, mais un analyste humain examine le dossier avant le blocage de la carte du client, afin de s'assurer qu'il ne s'agit pas d'un faux positif. Ce type de surveillance permet d'éviter que les erreurs d'IA ne causent des dommages.

Dans certains cas, l'intervention humaine pourrait être trop lente (par exemple, pour les décisions concernant les voitures autonomes). Les entreprises pourraient alors adopter une approche impliquant une intervention humaine, où les humains supervisent et peuvent intervenir ou arrêter un système d'IA s'ils constatent un dysfonctionnement. Le projet de réglementation de l'UE sur l'IA impose en effet une surveillance humaine pour les systèmes d'IA à haut risque., soulignant que les utilisateurs ou les opérateurs doivent avoir la capacité d’interpréter et d’influencer le résultat.

Pour que la supervision soit efficace, les organisations doivent former les superviseurs humains aux capacités et aux limites de l'IA. L'un des défis est biais d'automatisation – les gens peuvent devenir complaisants et accorder une confiance excessive à l'IA. Pour lutter contre ce phénomène, des exercices périodiques ou des audits aléatoires des décisions de l'IA peuvent maintenir l'attention des examinateurs humains (par exemple, vérifier ponctuellement certains cas où l'IA a refusé le prêt afin de s'assurer que la décision était justifiée).

Il est également important de cultiver un état d'esprit organisationnel qui valorise l'intuition humaine et le jugement éthique, parallèlement à la logique algorithmique. Le personnel de terrain doit se sentir habilité à remettre en question ou à annuler les décisions de l'IA si quelque chose semble anormal. Dans l'industrie aéronautique, les pilotes sont formés pour savoir quand se fier au pilote automatique et quand prendre les commandes. De même, les entreprises doivent élaborer des protocoles pour déterminer quand s'appuyer sur l'IA et quand une intervention humaine est nécessaire.

En fin de compte, la surveillance humaine offre un filet de sécurité et une boussole morale, permettant de détecter les problèmes que les algorithmes, manquant de compréhension ou d'empathie, pourraient manquer. Elle rassure les clients quant à la responsabilité : savoir qu'un humain peut entendre leur appel ou examiner leur dossier renforce la confiance que nous ne sommes pas à la merci de machines insensibles.

IA préservant la confidentialité : meilleures pratiques pour des systèmes d'IA sécurisés

Les systèmes d’IA ont souvent besoin de données, mais le respect de la vie privée tout en exploitant les données est un équilibre essentiel. IA préservant la confidentialité Il s'agit de techniques et de pratiques permettant d'obtenir des informations issues de l'IA sans compromettre les informations personnelles ou sensibles. Une pratique fondamentale est minimisation des données: Ne collectez et n'utilisez que les données réellement nécessaires à l'objectif de l'IA. Si un modèle d'IA peut atteindre son objectif sans certains identifiants personnels, ne les incluez pas. Des techniques comme anonymisation ou pseudonymisation peut aider – par exemple, avant d’analyser les données sur le comportement des clients, supprimez les noms ou remplacez-les par des identifiants aléatoires.

Cependant, une véritable anonymisation peut être difficile (l'IA peut parfois réidentifier des modèles), c'est pourquoi des approches plus robustes gagnent du terrain, telles que Apprentissage fédéré et Confidentialité différentielleL'apprentissage fédéré permet de former des modèles d'IA sur plusieurs sources de données sans que les données ne quittent jamais leur source. Par exemple, une IA de clavier de smartphone qui apprend des modèles de frappe des utilisateurs peut mettre à jour un modèle global sans télécharger les frappes individuelles, conservant ainsi les données personnelles sur l'appareil.

La confidentialité différentielle ajoute un bruit soigneusement calibré aux données ou aux résultats de requêtes afin que l'IA puisse apprendre des modèles agrégés, mais rien ne peut être identifié avec certitude concernant un individu en particulier. Des entreprises comme Apple et Google ont utilisé la confidentialité différentielle en pratique pour collecter des statistiques d'utilisation sans identifier les utilisateurs. Les entreprises qui traitent des données sensibles (santé, finances, localisation, etc.) devraient s'intéresser à ces techniques pour préserver la confiance de leurs clients et respecter les lois sur la confidentialité. Le chiffrement est également indispensable, tant au niveau du stockage (chiffrement des données au repos) qu'en transit.

De plus, considérez contrôles d'accès Pour les modèles d'IA, il arrive que le modèle lui-même divulgue involontairement des données (par exemple, un modèle de langage peut régurgiter des parties de son texte d'entraînement). Limitez les personnes autorisées à interroger les modèles sensibles et surveillez les résultats. Au niveau organisationnel, alignez vos projets d'IA sur les réglementations relatives à la protection des données (RGPD, CCPA, etc.) dès la phase de conception ; réalisez des évaluations d'impact sur la vie privée pour les nouveaux systèmes d'IA.

Soyez transparent avec les utilisateurs sur l'utilisation des données : obtenez leur consentement éclairé si nécessaire et proposez des options de désinscription à ceux qui ne souhaitent pas que leurs données soient utilisées pour l'entraînement de l'IA. En intégrant la protection de la vie privée au développement de l'IA, les entreprises protègent les droits des utilisateurs et évitent les incidents tels que les fuites de données ou les scandales d'utilisation abusive. C'est un investissement dans la pérennité des données : si les utilisateurs ont confiance dans le traitement éthique de leurs données, ils seront plus enclins à autoriser leur utilisation, alimentant ainsi l'innovation en IA dans un cercle vertueux.

Audit éthique de l'IA : stratégies de surveillance et de conformité continues

Tout comme les processus financiers sont audités, les systèmes d’IA bénéficient de audits d'éthique et de conformité. Un audit éthique de l'IA Il s'agit d'examiner systématiquement le respect par un système d'IA de certaines normes ou principes (équité, exactitude, confidentialité, etc.), avant son déploiement et périodiquement par la suite. Les entreprises devraient mettre en place une fonction d'audit de l'IA – un comité interne ou des auditeurs externes (ou les deux) – pour évaluer les systèmes d'IA importants. Par exemple, une banque utilisant l'IA pour ses décisions de crédit pourrait confier à une équipe d'audit la vérification de la conformité du modèle à toutes les exigences réglementaires (comme l'ECOA américaine relative à l'équité des prêts) et aux critères éthiques, et produire un rapport de conclusions et de recommandations.

Les éléments clés à vérifier comprennent : mesures de biais (les résultats sont-ils équitables ?), taux d'erreur et performances (en particulier dans les systèmes critiques pour la sécurité – sont-ils dans une plage acceptable ?), explicabilité (les décisions peuvent-elles être interprétées et justifiées ?), lignée de données (les données de formation sont-elles correctement sourcées et utilisées ?), et sécurité (le modèle est-il vulnérable aux attaques adverses ou aux fuites de données ?).

Les audits peuvent également examiner le processus de développement : la documentation était-elle adéquate ? Les approbations et les tests appropriés ont-ils été effectués avant le lancement ? Certaines organisations adoptent des listes de contrôle issues de cadres comme Série IEEE 7000 ou le Cadre de gestion des risques liés à l'IA du NIST comme critères d'audit de base. Il est judicieux d'impliquer des experts pluridisciplinaires dans les audits : data scientists, juristes, responsables de la conformité, éthiciens et experts du domaine.

Après un audit, il est essentiel de mettre en place un plan pour traiter les signaux d'alerte, par exemple en reprogrammant un modèle, en améliorant la documentation, voire en retirant un outil d'IA de la production jusqu'à la résolution des problèmes. De plus, le suivi doit être continu : mise en place de tableaux de bord ou de tests automatisés pour les indicateurs éthiques (par exemple, une alerte si la composition démographique des approbations de prêts s'écarte des normes attendues, indiquant un éventuel biais). Avec l'arrivée de nouvelles réglementations, la tenue de pistes d'audit contribuera également à démontrer la conformité aux autorités.

Au-delà des audits formels, les entreprises peuvent encourager dénonciation et retour d'information Boucles d'IA : permettez aux employés, voire aux utilisateurs, de signaler sans crainte leurs préoccupations liées à l'IA et d'enquêter rapidement. En résumé, considérez la gouvernance éthique de l'IA comme un processus continu, et non comme une simple case à cocher. En instaurant des audits réguliers et une surveillance rigoureuse, les entreprises peuvent détecter les problèmes en amont, s'adapter aux nouvelles normes éthiques et garantir que leurs systèmes d'IA restent dignes de confiance dans la durée.

Pour une analyse plus approfondie de la manière de mettre en œuvre les principes éthiques lors du développement de l'IA, consultez notre guide complet sur développement éthique de l'IA.

L'avenir de l'éthique de l'IA : préoccupations et solutions émergentes

L’IA est un domaine en évolution rapide, et avec elle viennent nouvelles frontières éthiques que les entreprises et les décideurs politiques devront gérer.Pour l’avenir, voici quelques préoccupations émergentes en matière d’éthique de l’IA et des solutions potentielles :

L’IA est un domaine en évolution rapide, et avec elle viennent nouvelles frontières éthiques que les entreprises et les décideurs politiques devront gérer.Pour l’avenir, voici quelques préoccupations émergentes en matière d’éthique de l’IA et des solutions potentielles :

L'IA dans la guerre : armes autonomes et éthique de l'IA militaire

L’utilisation de l’IA dans les applications militaires – des drones autonomes aux cyberarmes pilotées par l’IA – suscite des inquiétudes à l’échelle mondiale. Armes autonomes, souvent surnommés « robots tueurs », pourraient prendre des décisions de vie ou de mort sans intervention humaine. Les enjeux éthiques sont ici profonds : une machine peut-elle respecter le droit international humanitaire de manière fiable ? Qui est responsable si une IA identifie une cible de manière erronée et tue des civils ?