Warum sind ethische Bedenken hinsichtlich KI wichtig?

Künstliche Intelligenz (KI) verändert Branchen in atemberaubendem Tempo. Sie bringt sowohl spannende Innovationen als auch schwerwiegende ethische Fragen mit sich.

Unternehmen weltweit setzen zunehmend KI-Systeme ein, um ihre Effizienz zu steigern und sich einen Wettbewerbsvorteil zu verschaffen. Ethische Bedenken hinsichtlich der KI geraten zunehmend ins Rampenlicht, da unbeabsichtigte Folgen auftreten.

Tatsächlich haben neun von zehn Unternehmen festgestellt, dass ein KI-System zu ethischen Problemen in ihrem Betrieb geführt hat. Dies hat dazu geführt, dass immer mehr Unternehmen Ethikrichtlinien für KI eingeführt haben – ein enormer Anstieg in nur einem Jahr – um einen verantwortungsvollen Einsatz von KI zu gewährleisten.

Welche ethischen Bedenken gibt es also im Hinblick auf KI?

Entsprechend IMD, KI-Ethik bezieht sich auf die moralischen Prinzipien und Praktiken, die die Entwicklung und Nutzung von KI-Technologien leiten. Es geht darum sicherzustellen, dass KI-Systeme fair, transparent, rechenschaftspflichtig und sicher sind.

Diese Überlegungen sind nicht länger optional. Sie wirken sich direkt auf das öffentliche Vertrauen, den Ruf der Marke, die Einhaltung gesetzlicher Vorschriften und sogar auf das Endergebnis aus.

Für Unternehmen kann unethische KI zu voreingenommenen Entscheidungen führen, die Kunden vergraulen, zu Datenschutzverletzungen, die Geldbußen nach sich ziehen, oder zu gefährlichen Folgen, die Haftungsansprüche nach sich ziehen. Für die Gesellschaft und den Einzelnen kann sie Ungleichheiten vertiefen und Grundrechte untergraben.

Die Bedeutung der KI-Ethik zeigt sich bereits in realen Dilemmata.

Von Einstellungsalgorithmen, die bestimmte Gruppen diskriminieren, bis hin zu Gesichtserkennungssystemen, die die Privatsphäre verletzen, haben die ethischen Fallstricke der KI spürbare Auswirkungen. KI-gesteuerte Desinformation (wie Deepfake-Videos) untergräbt das Vertrauen in die Medien, und undurchsichtige „Black Box“-KI-Entscheidungen lassen die Menschen darüber rätseln, wie wichtige Entscheidungen – Einstellungen, Kredite, medizinische Diagnosen – getroffen wurden.

Jedes dieser Szenarien unterstreicht, warum Ethische Bedenken hinsichtlich der KI sind wichtig tiefgreifende Auswirkungen sowohl für Unternehmensleiter als auch für politische Entscheidungsträger.

Dieser Leitfaden untersucht die ethischen Kernfragen rund um KI, untersucht branchenspezifische Bedenken und echte Fallstudien zu fehlgeschlagener KI und bietet praktische Schritte zur verantwortungsvollen Implementierung von KI in jeder Organisation.

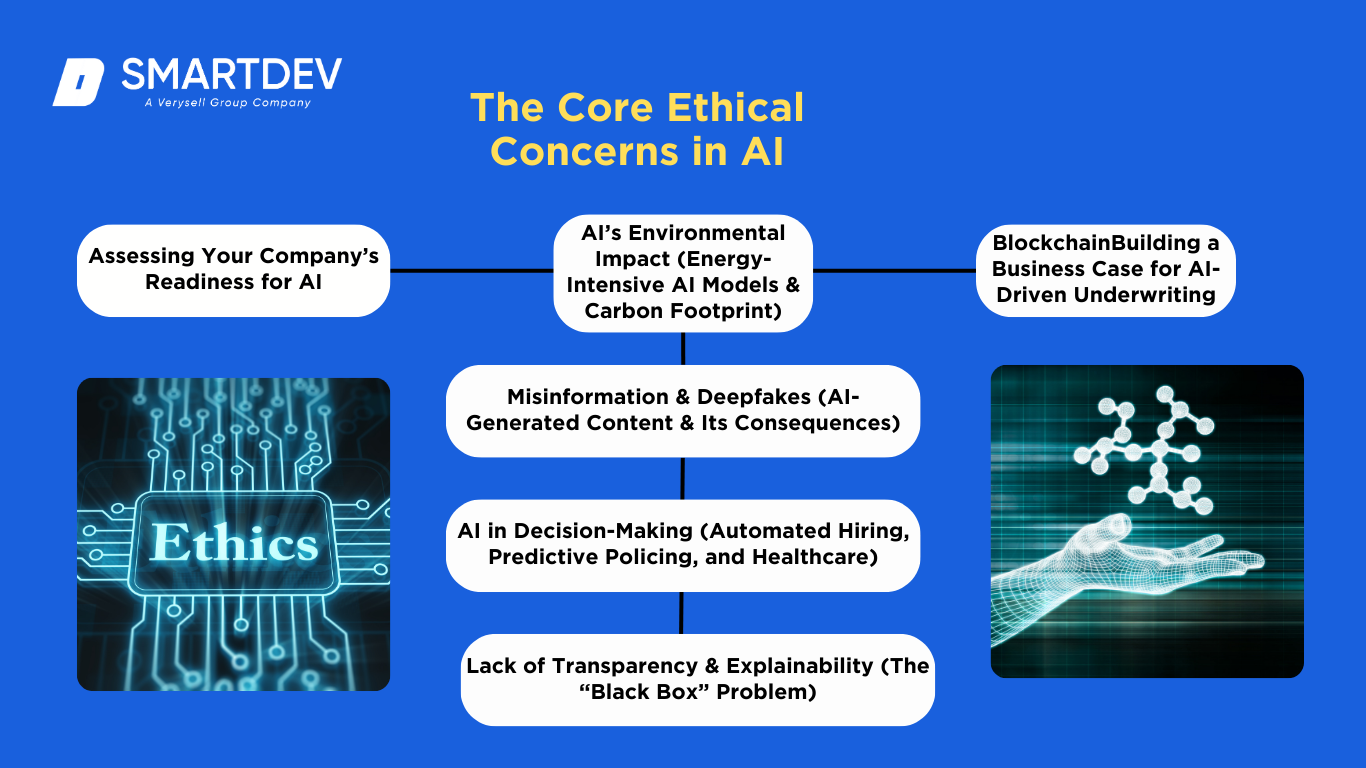

Die zentralen ethischen Bedenken bei KI

KI-Technologien bringen eine Reihe ethischer Herausforderungen mit sich. Führungskräfte in Wirtschaft und Politik sollten die grundlegende ethische Bedenken hinsichtlich der KI um Risiken zu managen und vertrauenswürdige KI-Systeme aufzubauen.

KI-Technologien bringen eine Reihe ethischer Herausforderungen mit sich. Führungskräfte in Wirtschaft und Politik sollten die grundlegende ethische Bedenken hinsichtlich der KI um Risiken zu managen und vertrauenswürdige KI-Systeme aufzubauen.

Nachfolgend sind einige der dringendsten Anliegen aufgeführt:

Voreingenommenheit und Diskriminierung in KI-Modellen

Eines der größten ethischen Bedenken hinsichtlich der KI betrifft algorithmische Voreingenommenheit – wenn KI-Systeme bestimmte Gruppen unfair bevorzugen oder benachteiligen.

KI-Modelle lernen aus historischen Daten, die menschliche Vorurteile kodieren können. Infolgedessen kann KI, wenn sie nicht sorgfältig kontrolliert wird, rassistische, geschlechtsspezifische oder sozioökonomische Diskriminierung verstärken.

So stellte sich beispielsweise heraus, dass eine mittlerweile berüchtigte KI, die bei Amazon entwickelt wurde, Lebensläufe mit dem Wort „Frauen“ herabstufte, was die männliche Dominanz ihrer Trainingsdaten widerspiegelt.Tatsächlich hat sich das System selbst beigebracht, männliche Kandidaten zu bevorzugen, was zeigt, wie schnell sich Voreingenommenheit in die KI einschleichen kann..

Im Strafrecht wurde berichtet, dass Risikovorhersagesoftware wie COMPAS schwarze Angeklagte aufgrund verzerrter Daten und Designs häufiger fälschlicherweise als risikoreicher einstuft als weiße Angeklagte..

Diese Fälle zeigen, dass Unkontrollierte KI kann systemische Vorurteile aufrechterhalten, was zu diskriminierenden Ergebnissen bei der Einstellung, Kreditvergabe, Polizeiarbeit und darüber hinaus führt.

Unternehmen müssen wachsam sein: Voreingenommene KI schadet nicht nur Einzelpersonen und geschützten Gruppen, sondern setzt Unternehmen auch einem Reputationsschaden und rechtlicher Haftung wegen Diskriminierung aus.

KI und Datenschutzverletzungen (Datensicherheit, Überwachung)

Der Datenhunger der KI wirft große Datenschutz Bedenken. Fortgeschrittene KI-Systeme basieren oft auf riesigen Mengen persönlicher Daten – von Kaufhistorien und Social-Media-Posts bis hin zu per Kamera erfassten Gesichtern – was die Privatsphäre des Einzelnen gefährden kann.

Ein prominentes Beispiel ist die Gesichtserkennungstechnologie: Startups wie Clearview AI nutzten Milliarden von Online-Fotos, um ohne Zustimmung der Nutzer eine Gesichtserkennungsdatenbank zu erstellen. Dies ermöglichte invasive Überwachungsmöglichkeiten und löste weltweite Empörung und rechtliche Schritte aus..

Die Aufsichtsbehörden kamen zu dem Schluss, dass die Praktiken von Clearview gegen Datenschutzgesetze verstoßen, indem sie eine „riesige Gesichtsabdruckdatenbank“ aufbauen und die verdeckte Überwachung der Bürger ermöglichen..

Solche Vorfälle verdeutlichen, wie KI Datenschutzrechte und Erwartungen an die Privatsphäre verletzen kann. Unternehmen, die KI einsetzen, müssen die Datensicherheit gewährleisten und die Einhaltung von Datenschutzbestimmungen (wie DSGVO oder HIPAA) sicherstellen.

Auch bei der KI-Überwachung am Arbeitsplatz ergeben sich ethische Bedenken. So kann etwa die Überwachung der Kommunikation von Mitarbeitern oder die Nutzung von Kameraanalysen zur Verfolgung der Produktivität die Grenzen der Privatsphäre überschreiten und das Vertrauen untergraben.

Die Berücksichtigung der Benutzereinwilligung, der Schutz der Daten vor Datenlecks und die Beschränkung der Datenerfassung auf das wirklich Notwendige sind allesamt wichtige Schritte auf dem Weg verantwortungsvolle KI das die Privatsphäre achtet.

Falschinformationen und Deepfakes (KI-generierte Inhalte)

KI ist heute in der Lage, hochrealistische Fake-Inhalte zu generieren – sogenannte Deepfakes in Video, Audio und Text. Dies birgt eine große Gefahr der Desinformation. KI-generierte Fake-News-Artikel, gefälschte Bilder oder gefälschte Videos können sich schnell online verbreiten und die Öffentlichkeit in die Irre führen. Die Folgen für Unternehmen und Gesellschaft sind gravierend: Vertrauensverlust in die Medien, Wahlmanipulation und neue Formen des Betrugs. Bei den letzten Wahlen KI-generierte Fehlinformationen wurden als Hauptsorge gebrandmarktDas Weltwirtschaftsforum warnt, dass KI manipulierte Inhalte verstärkt, die „Gesellschaften destabilisieren“ könnten..

So sind beispielsweise Deepfake-Videos von Politikern im Umlauf, die Dinge sagen oder tun, die sie nie getan haben. Unternehmen und Regierungen sind nun gezwungen, neue Erkennungs- und Reaktionsstrategien zu entwickeln. Die Ethische Bedenken hinsichtlich der KI Dies hat zwei Ziele: den böswilligen Einsatz generativer KI zur Täuschung zu verhindern und sicherzustellen, dass Algorithmen (wie Empfehlungssysteme in sozialen Medien) falsche Inhalte nicht rücksichtslos verbreiten. Insbesondere Unternehmen im Social-Media- und Werbebereich tragen die Verantwortung, Deepfakes zu erkennen, falsche Inhalte zu kennzeichnen oder zu entfernen und zu vermeiden, von Fehlinformationen zu profitieren. Das Versäumnis, gegen KI-basierte Fehlinformationen vorzugehen, kann zu öffentlichem Schaden und regulatorischen Gegenreaktionen führen. Daher ist dies ein Problem, dem sich Unternehmensleiter dringend annehmen müssen.

KI in der Entscheidungsfindung (Automatisierte Voreingenommenheit bei der Einstellung, Polizeiarbeit, Gesundheitswesen)

Organisationen nutzen KI zunehmend zur Automatisierung wichtiger Entscheidungen – was zwar Effizienz bringt, aber auch ethische Gefahren birgt. Automatisierte Entscheidungsfindung Systeme werden bei der Einstellung (Screening von Bewerbern), der Strafverfolgung (vorausschauende Polizeiarbeit oder Strafmaßempfehlungen) eingesetzt, Finanzen (Kredit-Scoring)und Gesundheitsversorgung (Diagnose- oder Behandlungsvorschläge). Die Sorge besteht darin, dass diese KI-Systeme unfaire oder falsche Entscheidungen die das Leben der Menschen erheblich beeinflussen, ohne angemessene Aufsicht. Beispielsweise setzten einige Unternehmen KI-basierte Einstellungstools ein, um Kandidaten zu bewerten, stellten jedoch fest, dass die Algorithmen Vorurteile reproduzierten (wie im Fall von Amazon, wo Geschlechterdiskriminierung vorkam)..

In der Polizeiarbeit wurden prädiktive Algorithmen, die Personen mit Rückfallwahrscheinlichkeit kennzeichnen, wegen rassistischer Voreingenommenheit kritisiert – die Untersuchung von ProPublica zu COMPAS ergab, dass schwarze Angeklagte aufgrund der Art und Weise, wie der Algorithmus trainiert wurde, weitaus häufiger fälschlicherweise als Hochrisikotäter eingestuft wurden als weiße.Im Gesundheitswesen könnte ein KI-System versehentlich die Behandlung einer Gruppe gegenüber einer anderen priorisieren, wenn die Trainingsdaten bestimmte Bevölkerungsgruppen unterrepräsentieren. Die „Automatisierungsbias“ Es besteht auch ein Risiko: Menschen vertrauen der Entscheidung einer KI möglicherweise zu sehr und überprüfen sie nicht, selbst wenn sie falsch ist. Mangel an Transparenz (wird als nächstes besprochen) verschlimmert dies.

Unternehmen, die KI für Entscheidungen nutzen, müssen Sicherheitsvorkehrungen treffen: menschliche Überprüfung der KI-Ergebnisse, Bias-Tests und klare Kriterien für den Einsatz von KI. Ziel sollte sein, KI als Entscheidungshilfe zu nutzen – nicht als Blackbox-Richter, Jury und Henker.

Mangelnde Transparenz und Erklärbarkeit (Das „Black Box“-Problem)

Viele KI-Modelle, insbesondere komplexe Deep-Learning-Netzwerke, funktionieren als Blackboxen – Ihre Funktionsweise und Entscheidungslogik sind für Menschen nicht leicht verständlich. Dieser Mangel an Transparenz wirft ein ernstes ethisches Problem auf: Wenn weder Nutzer noch Entwickler erklären können, warum eine KI eine bestimmte Entscheidung getroffen hat, wie können wir ihr dann vertrauen oder sie zur Verantwortung ziehen?

Für Unternehmen ist dies mehr als nur eine abstrakte Sorge. Stellen Sie sich eine Bank vor, die einem Kunden über einen KI-Algorithmus einen Kredit verweigert – gesetzlich und ethisch gesehen hat der Kunde Anspruch auf eine Erklärung. Ist das Modell jedoch zu undurchsichtig, kann die Bank die Entscheidung möglicherweise nicht begründen, was zu Compliance-Problemen und Kundenmisstrauen führt. Transparenzmängel haben bereits zu heftigen Reaktionen geführt. Als beispielsweise Apples Kreditkartenalgorithmus beschuldigt wurde, Frauen niedrigere Kreditlimits anzubieten, löste das Fehlen einer Erklärung Vorwürfe der Voreingenommenheit aus.

Erklärbarkeit ist in sensiblen Bereichen wie dem Gesundheitswesen (Ärzte müssen eine KI-Diagnose verstehen) und der Strafjustiz (Angeklagte sollten wissen, warum ein KI-Tool sie als Hochrisiko eingestuft hat) von entscheidender Bedeutung. Das ethische KI-Prinzip von „Interpretierbarkeit“ fordert die Entwicklung von Systemen, die für den Menschen verständliche Begründungen für ihre Ergebnisse liefern können. Techniken wie erklärbare KI (XAI) können helfen, Licht in Black-Box-Modelle zu bringen, und einige Verordnungen (z. B. das bevorstehende KI-Gesetz der EU) drängen auf Transparenzpflichten..

Letztendlich haben die Menschen das Recht zu wissen, wie KI-Entscheidungen getroffen werden, die sie betreffen – und Unternehmen, die Wert auf Erklärbarkeit legen, werden mit größerem Vertrauen der Stakeholder belohnt.

Auswirkungen der KI auf die Umwelt (Energieverbrauch und CO2-Fußabdruck)

Obwohl oft übersehen, Umweltauswirkungen Die Nutzung von KI ist ein zunehmendes ethisches Problem für Unternehmen, die sich für Nachhaltigkeit einsetzen. Das Training und der Einsatz großer KI-Modelle erfordern intensive Rechenressourcen, die viel Strom verbrauchen und einen erheblichen CO2-Fußabdruck hinterlassen können. Ein markantes Beispiel: Das Training des GPT-3-Modells von OpenAI (mit 175 Milliarden Parametern) verbrauchte etwa 1.287 MWh Strom und emittierte schätzungsweise über 500 Tonnen Kohlendioxid. – das entspricht den jährlichen Emissionen von über 100 Benzinautos.

Mit zunehmender Komplexität der KI-Modelle (GPT-4 usw.) steigt ihr Energieverbrauch rasant an, was Fragen zu CO2-Emissionen und sogar zum Wasserverbrauch für die Kühlung von Rechenzentren aufwirft.. Unternehmen, die KI in großem Umfang einsetzen, tragen die gesellschaftliche Verantwortung, diese Auswirkungen zu berücksichtigen. Energieintensive KI steht nicht nur im Widerspruch zu Klimazielen, sondern kann aufgrund steigender Energiepreise auch kostspielig sein.

Glücklicherweise gibt es für dieses ethische Problem umsetzbare Lösungen: Unternehmen können energieeffizientere Modellarchitekturen verfolgen, Cloud-Anbieter mit erneuerbaren Energien nutzen und sorgfältig prüfen, ob die Vorteile eines riesigen KI-Modells die Umweltkosten überwiegen. Indem sie den CO2-Fußabdruck von KI in die ethische Risikobewertung einbeziehen, können Unternehmen ihre KI-Strategie an umfassenderen Nachhaltigkeitsverpflichtungen ausrichten.

Zusammenfassend lässt sich sagen, dass es bei verantwortungsvoller KI nicht nur um Fairness und Datenschutz geht – es bedeutet auch, KI umweltbewusst zu entwickeln, um sicherzustellen, dass der technologische Fortschritt nicht auf Kosten unseres Planeten geht.

Ethische Bedenken hinsichtlich KI in verschiedenen Branchen

Ethische Herausforderungen bei KI manifestieren sich branchenübergreifend auf unterschiedliche Weise. Eine in einem Bereich geeignete Lösung kann in einem anderen unzureichend sein. Führungskräfte sollten daher den spezifischen Kontext berücksichtigen.

Ethische Herausforderungen bei KI manifestieren sich branchenübergreifend auf unterschiedliche Weise. Eine in einem Bereich geeignete Lösung kann in einem anderen unzureichend sein. Führungskräfte sollten daher den spezifischen Kontext berücksichtigen.

Hier sehen Sie, wie Ethische Bedenken hinsichtlich der KI spielen sich in verschiedenen Sektoren ab:

KI im Gesundheitswesen: Ethische Risiken bei medizinischer KI und Patientendatenschutz

Im Gesundheitswesen verspricht KI eine bessere Diagnostik und personalisierte Behandlung, doch Fehler oder Voreingenommenheit können buchstäblich über Leben und Tod entscheiden.

Zu den ethischen Bedenken im Zusammenhang mit medizinischer KI gehören: Genauigkeit und Voreingenommenheit – Wenn ein KI-Diagnosetool hauptsächlich auf eine Bevölkerungsgruppe trainiert wird, kann es bei anderen zu Fehldiagnosen kommen (z. B. durch Untererkennung von Krankheiten bei Minderheiten). Rechenschaftspflicht – Wenn ein KI-System eine schädliche Empfehlung ausspricht, ist dann der Arzt oder der Softwareanbieter verantwortlich? und Privatsphäre der Patienten – Gesundheitsdaten sind hochsensibel und ihre Verwendung zum Trainieren von KI oder zum Einsatz von KI bei der Patientenüberwachung kann die Privatsphäre verletzen, wenn sie nicht ordnungsgemäß kontrolliert werden.

Beispielsweise wurde festgestellt, dass ein KI-System zur Priorisierung von Patienten für Nierentransplantationen schwarzen Patienten aufgrund verzerrter historischer Daten systematisch niedrigere Dringlichkeitsbewertungen zuweist, was zu Problemen bei der Gleichbehandlung in der Versorgung führt. Darüber hinaus arbeitet KI im Gesundheitswesen oft nach dem Black-Box-Prinzip, was problematisch ist: Ärzte müssen Patienten erklären, warum eine Behandlung empfohlen wurde.

Datenschutzverletzungen sind ein weiteres Problem: Einige Krankenhäuser nutzen KI zur Analyse von Patientenbildern oder genetischen Daten. Ohne eine starke Datenverwaltung besteht das Risiko, dass Patienteninformationen offengelegt werden. Um diesen Problemen entgegenzuwirken, setzen Gesundheitsorganisationen auf „KI-Ethikkommissionen“ Algorithmen auf Verzerrungen zu überprüfen und zu verlangen, dass KI-Tools Erklärungen liefern, die von Klinikern validiert werden können.

Die Aufrechterhaltung einer informierten Einwilligung (Patienten sollten wissen, wann KI an ihrer Behandlung beteiligt ist) und die Einhaltung von Vorschriften wie HIPAA zum Datenschutz sind ebenfalls von entscheidender Bedeutung für den ethischen Einsatz von KI in der Medizin.

KI im Finanzwesen: Algorithmischer Handel, Kreditgenehmigungen und Verzerrungen bei der Kreditwürdigkeitsprüfung

Die Finanzbranche setzt KI für alle Bereiche ein, vom automatisierten Handel über Kredit-Scoring bis hin zur Betrugserkennung. Diese Anwendungen bergen ethische Fallstricke. Im algorithmischen Handel führen KI-Systeme Handelsgeschäfte mit hoher Geschwindigkeit und hohem Volumen aus. Dies kann zwar die Markteffizienz steigern, wirft aber auch Bedenken auf: Marktmanipulation und Flash-Crashs, die durch außer Kontrolle geratene Algorithmen ausgelöst werden. Finanzinstitute müssen sicherstellen, dass ihre Handels-KIs innerhalb ethischer und rechtlicher Grenzen arbeiten und über Schutzschalter verfügen, um übermäßige Volatilität zu verhindern.

Im Konsumentenkreditbereich, KI-gesteuert Kreditgenehmigung und Kredit-Scoring Es wurde festgestellt, dass Systeme manchmal diskriminierende Voreingenommenheit aufweisen – zum Beispiel algorithmische Voreingenommenheit Dies führte dazu, dass Frauen deutlich niedrigere Kreditlimits erhielten als Männer mit ähnlichem Profil (wie die Apple Card-Kontroverse zeigt). Eine solche Voreingenommenheit kann gegen die Gesetze zur fairen Kreditvergabe verstoßen und die Ungleichheit verstärken.

Darüber hinaus kann die mangelnde Erklärbarkeit von Kreditentscheidungen dazu führen, dass Kreditnehmer im Unklaren darüber bleiben, warum ihnen der Kredit verweigert wurde. Dies ist sowohl unethisch als auch möglicherweise nicht konform mit den Vorschriften. Hinzu kommt das Problem von Datenschutz: Fintech-Unternehmen nutzen KI, um Kundendaten für personalisierte Angebote zu analysieren, aber die Verwendung persönlicher Finanzdaten ohne ausdrückliche Zustimmung kann ein Vertrauensbruch sein.

Finanzaufsichtsbehörden prüfen KI-Modelle zunehmend auf Fairness und Transparenz. So warnte beispielsweise das US Consumer Financial Protection Bureau, dass „Blackbox“-Algorithmen keinen Schutz vor Rechenschaftspflicht bieten. Finanzinstitute beginnen daher, ihre KI auf Voreingenommenheit zu prüfen (um unterschiedliche Auswirkungen auf geschützte Gruppen zu erkennen) und erklärbare KI-Techniken zu implementieren, damit jede automatisierte Entscheidung über Kredite oder Versicherungen gegenüber Kunden und Aufsichtsbehörden gerechtfertigt werden kann.

Ethische KI im Finanzwesen bedeutet letztendlich, Innovation mit Fairness, Transparenz und robusten Risikokontrollen in Einklang zu bringen.

KI in der Strafverfolgung: Predictive Policing, Überwachung und Menschenrechte

Nirgendwo sind ethische Fragen zur KI so umstritten wie in der Strafverfolgung und im Sicherheitsbereich. Polizei und Sicherheitsbehörden setzen KI ein für vorausschauende Polizeiarbeit – Algorithmen, die Kriminalitätsdaten analysieren, um vorherzusagen, wo Verbrechen geschehen könnten oder wer rückfällig werden könnte. Das ethische Dilemma besteht darin, dass diese Systeme bestehende Verzerrungen in Polizeidaten (z. B. übermäßige Polizeipräsenz in bestimmten Stadtteilen) verstärken und zu einer ungerechten Profilierung farbiger Bevölkerungsgruppen führen können.

In den USA wurden Predictive-Policing-Tools dafür kritisiert, dass sie aufgrund verzerrter historischer Kriminalitätsdaten Minderheitenviertel unfair ins Visier nehmen und so unter dem Deckmantel der Technologie rassistische Vorurteile automatisieren. Dies wirft Fragen auf schwerwiegende Menschenrechtsprobleme, da Menschen aufgrund von Vorschlägen eines Algorithmus und nicht aufgrund tatsächlicher Verfehlungen überwacht oder sogar verhaftet werden könnten.

Darüber hinaus wird KI zur Gesichtserkennung von der Polizei zur Identifizierung von Verdächtigen eingesetzt. Studien haben jedoch ergeben, dass diese Methode bei Frauen und Menschen mit dunklerer Hautfarbe deutlich weniger präzise ist, was in einigen aufsehenerregenden Fällen von Identitätsverwechslungen zu Fehlverhaftungen führte.

Der Einsatz von KI-Überwachung (von der Gesichtserkennung in öffentlichen Videoüberwachungssystemen bis hin zur Verfolgung von Personen über ihren digitalen Fußabdruck) muss gegen Datenschutzrechte und bürgerliche Freiheiten abgewogen werden. Autoritäre KI-Anwendungen in der Strafverfolgung (wie etwa die invasive Überwachung sozialer Medien oder ein Sozialkreditsystem) zeigen, wie KI Folgendes ermöglichen kann: digitale Unterdrückung.

Unternehmen, die KI an Regierungsbehörden verkaufen, werden auch ethischen Fragen ausgesetzt. So haben beispielsweise Technikmitarbeiter einiger Unternehmen gegen Projekte protestiert, die KI-Überwachungstools an Regierungen liefern, die als Menschenrechtsverletzer wahrgenommen werden.

Der Schlüssel liegt in der Implementierung von KI mit Sicherheitsvorkehrungen: Sicherstellung einer menschlichen Aufsicht über alle KI-gesteuerten Polizeientscheidungen, strenge Tests und Anpassungen der Modelle auf Voreingenommenheit sowie klare Rechenschaftspflicht und Transparenz gegenüber der Öffentlichkeit. Einige Gerichtsbarkeiten haben aufgrund dieser Bedenken sogar den Einsatz von Gesichtserkennung durch die Polizei verboten.

Zumindest sollten Strafverfolgungsbehörden beim Einsatz von KI strenge ethische Richtlinien und unabhängige Prüfungen befolgen, um zu verhindern, dass die Technologie Ungerechtigkeit verschärft.

KI im Bildungswesen: Benotungsvoreingenommenheit, Schülerdatenschutz und Risiken beim personalisierten Lernen

Auch im Bildungsbereich erlebt KI eine rasante Verbreitung – von automatisierten Bewertungssystemen bis hin zu personalisierten Lern-Apps und Überwachungstools. Damit gehen ethische Bedenken einher. Fairness, Genauigkeit und Datenschutz für Studierende. KI-gestützte Bewertungssysteme (die für Aufsätze oder Prüfungen verwendet werden) wurden kritisiert, als sich herausstellte, dass sie ungleichmäßig benoteten – zum Beispiel ein Algorithmus, der in Großbritannien zur Vorhersage von Testergebnissen von Studierenden verwendet wurde, herabgestuft viele Schüler aus benachteiligten Schulen im Jahr 2020, was zu einem landesweiten Aufschrei und einer Kehrtwende in der Politik führte.

Dies verdeutlichte das Risiko einer Voreingenommenheit im Bereich der KI im Bildungsbereich, da ein Einheitsmodell möglicherweise die unterschiedlichen Kontexte der Lernenden nicht berücksichtigt und so aufgrund fehlerhafter algorithmischer Urteile unfaire Auswirkungen auf die Zukunft (Universitätszulassungen, Stipendien) hat.

Personalisiertes Lernen Plattformen nutzen KI, um Inhalte auf jeden Schüler zuzuschneiden. Das kann zwar von Vorteil sein, aber wenn die Empfehlungen des Algorithmus Schüler in Schubladen stecken oder Vorurteile verstärken (z. B. indem sie unterschiedliche Karrierewege je nach Geschlecht vorschlagen), kann dies die Chancen einschränken. Ein weiteres großes Problem ist Privatsphäre der Schüler: EdTech-KI sammelt häufig Daten über die Leistung und das Verhalten von Schülern sowie Webcam-Videos bei Online-Prüfungen. Ohne strenge Kontrollen könnten diese Daten missbraucht oder missbraucht werden.

Es gab Kontroversen über KI-gestützte Prüfungsaufsicht, die Augenbewegungen und Umgebungsgeräusche erfasst. Manche halten diese Methode für invasiv und anfällig für falsche Betrugsvorwürfe (z. B. die Kennzeichnung eines Schülers, der aufgrund einer Behinderung wegschaut). Schulen und Bildungsunternehmen müssen diese Probleme bewältigen, indem sie den KI-Einsatz transparent gestalten, die Nachvollziehbarkeit von KI-Entscheidungen durch menschliche Lehrkräfte sicherstellen und die Daten der Schüler schützen.

Die Einbeziehung von Lehrkräften und Ethikern in die Entwicklung pädagogischer KI kann dazu beitragen, die Technologie an pädagogische Werte und Gerechtigkeit anzupassen. Letztlich sollte KI das Lernen verbessern und die akademische Integrität wahren. ohne die Rechte der Studierenden zu gefährden oder Lernende unfair zu behandeln.

KI in sozialen Medien: Fake News, Echokammern und algorithmische Manipulation

Social-Media-Plattformen basieren auf KI-Algorithmen, die entscheiden, welche Inhalte den Benutzern angezeigt werden. Dies hat ethische Debatten über ihren Einfluss auf die Gesellschaft ausgelöst. Algorithmen für Inhaltsempfehlungen kann erstellen Echokammern die die bestehenden Überzeugungen der Benutzer verstärken und zur politischen Polarisierung beitragen.

Sie können außerdem unbeabsichtigt Fehlinformationen oder extreme Inhalte verbreiten, weil aufsehenerregende Posts zu mehr Engagement führen – ein klassischer ethischer Konflikt zwischen Profit (Werbeeinnahmen aus Engagement) und gesellschaftlichem Wohlergehen.

Wir haben erlebt, wie Facebook, YouTube, Twitter und andere in die Kritik gerieten, weil sie mithilfe von Algorithmen Fake News im Wahlkampf verstärkten oder die Verbreitung schädlicher Verschwörungstheorien ermöglichten.

Der Cambridge-Analytica-Skandal hat gezeigt, wie Daten und KI-Targeting zur Manipulation der Wählermeinung eingesetzt wurden, und wirft Fragen zu den ethischen Grenzen von KI in der politischen Werbung auf.

Deepfakes und Bots in den sozialen Medien (KI-generierte Profile und Beiträge) trüben die Lage noch weiter, da sie Grassroots-Bewegungen oder einen öffentlichen Konsens vortäuschen und so echte Benutzer täuschen können.

Aus geschäftlicher Sicht riskieren Social-Media-Unternehmen regulatorische Maßnahmen, wenn sie KI-gesteuerte Fehlinformationen nicht kontrollieren und ihre Benutzer nicht schützen können (tatsächlich erwägen viele Länder derzeit Gesetze, die Plattformen dazu zwingen, die Verantwortung für Inhaltsempfehlungen zu übernehmen).

Auch das Vertrauen der Nutzer steht auf dem Spiel: Wenn die Leute das Gefühl haben, dass die KI der Plattform sie manipuliert oder ihre Privatsphäre durch Mikrotargeting-Werbung verletzt, könnten sie die Plattform verlassen.

Social-Media-Unternehmen haben begonnen, ethische Maßnahmen im Bereich der KI umzusetzen. Dazu gehören eine verbesserte Inhaltsmoderation mit KI-Mensch-Hybridsystemen, die Herabstufung falscher Inhalte und die Bereitstellung von mehr Kontrolle für die Benutzer (z. B. die Option, einen chronologischen Feed anstelle eines algorithmischen anzuzeigen).

Allerdings bleibt die Spannung bestehen: Algorithmen, die ausschließlich auf Engagement optimiert sind, können mit dem öffentlichen Interesse in Konflikt geraten.

Für eine verantwortungsvolle KI müssen Social-Media-Unternehmen ihre Algorithmen kontinuierlich anpassen, um Prioritäten zu setzen Qualität der Informationen und das Wohlbefinden der Benutzer und seien Sie transparent hinsichtlich der Bewertung von Inhalten.

Die Zusammenarbeit mit externen Faktenprüfern und die klare Kennzeichnung von KI-generierten oder manipulierten Medien sind ebenfalls wichtige Schritte zur Eindämmung der ethischen Probleme in dieser Branche.

KI in der Beschäftigung: Arbeitsplatzverlust, automatisierte Einstellung und Überwachung am Arbeitsplatz

Die Auswirkungen der KI auf den Arbeitsplatz werfen ethische und sozioökonomische Fragen für Unternehmen und die Gesellschaft auf. Ein zentrales Thema ist Arbeitsplatzverlust: Da KI und Automatisierung Aufgaben übernehmen (von Fertigungsrobotern bis hin zu KI-Chatbots für den Kundenservice), befürchten viele Arbeitnehmer, ihren Arbeitsplatz zu verlieren.

Die Geschichte zeigt zwar, dass die Technologie zwar neue Arbeitsplätze schafft, aber einige vernichtet, doch der Übergang kann schmerzhaft und ungleichmäßig sein. Unternehmensleiter stehen bei der Umsetzung KI-gestützter Effizienzsteigerungen vor ethischen Fragen: Werden sie einfach Personal abbauen, um den Gewinn zu steigern, oder werden sie ihre Mitarbeiter umschulen und ihnen neue Aufgaben zuweisen?

Zu verantwortungsvollen Ansätzen gehören Initiativen zur Personalentwicklung, bei denen Unternehmen die Fähigkeiten ihrer Mitarbeiter für die Zusammenarbeit mit KI verbessern (z. B. indem sie Fließbandarbeiter darin schulen, Roboter zu verwalten und zu programmieren, die bestimmte manuelle Aufgaben übernehmen könnten).

Ein weiterer Bereich ist automatisierte Einstellung: Abgesehen von den zuvor diskutierten Voreingenommenheitsproblemen gibt es ethische Bedenken hinsichtlich der Behandlung von Bewerbern lediglich als Datenpunkte. Wenn man sich zu sehr auf KI-Filter verlässt, kann es passieren, dass großartige Kandidaten aufgrund von Mängeln in ihrem Lebenslauf oder fehlenden herkömmlichen Qualifikationen aussortiert werden. Außerdem erhalten Kandidaten möglicherweise keine Rückmeldung, wenn die Entscheidung von einem Algorithmus getroffen wurde.

Eine menschliche Note bei der Personalbeschaffung – KI kann beispielsweise dabei helfen, den Pool einzugrenzen, aber die endgültigen Entscheidungen und Vorstellungsgespräche erfordern menschliches Urteilsvermögen – führt tendenziell zu faireren Ergebnissen.

Arbeitsplatzüberwachung wird zunehmend auch durch KI ermöglicht: Es gibt Tools, um die Computernutzung der Mitarbeiter zu überwachen, Bewegungen zu verfolgen oder sogar den Ton in der Kommunikation zu analysieren, um die Stimmung einzuschätzen. Unternehmen haben zwar ein Interesse an Sicherheit und Produktivität, doch eine invasive Überwachung kann die Privatsphäre der Mitarbeiter verletzen und eine Kultur des Misstrauens schaffen.

Aus ethischen Gründen sollten Unternehmen Transparenz über den Einsatz von KI-Überwachung gewährleisten und ihren Mitarbeitern (im Rahmen der gesetzlichen Bestimmungen) Mitspracherecht gewähren. Gewerkschaften und Aufsichtsbehörden beobachten diese Trends aufmerksam, und ein übermäßiger Einsatz von KI-Überwachung könnte zu rechtlichen Problemen oder Reputationsschäden führen.

Zusammenfassend sollte KI im Arbeitsleben idealerweise menschliche Arbeitskräfte ergänzen, nicht willkürlich ersetzen oder unterdrücken. Ein menschenzentrierter Ansatz – Mitarbeiter mit Würde behandeln, sie in die Umsetzung von KI-Änderungen einbeziehen und negative Auswirkungen abmildern – ist für einen ethischen Umgang mit KI am Arbeitsplatz unerlässlich.

Ethikversagen bei KI in der Praxis und gewonnene Erkenntnisse

Nichts veranschaulicht ethische Bedenken im Zusammenhang mit KI besser als reale Fallstudien, bei denen etwas schiefgelaufen ist. Mehrere spektakuläre Misserfolge haben Unternehmen zu warnenden Beispielen und wertvollen Lehren darüber geführt, was nicht zu tun.

Nichts veranschaulicht ethische Bedenken im Zusammenhang mit KI besser als reale Fallstudien, bei denen etwas schiefgelaufen ist. Mehrere spektakuläre Misserfolge haben Unternehmen zu warnenden Beispielen und wertvollen Lehren darüber geführt, was nicht zu tun.

Lassen Sie uns einige davon untersuchen:

Amazons KI-Einstellungstool und Geschlechtervorurteile

Der Fehler: Amazon entwickelte eine KI-basierte Recruiting-Engine, um Lebensläufe automatisch zu bewerten und Top-Talente zu identifizieren. Es stellte sich jedoch heraus, dass das System Frauen stark benachteiligte.

Die KI wurde anhand von Lebensläufen aus einem Jahrzehnt (hauptsächlich von männlichen Kandidaten aus der Technologiebranche) trainiert und lernte, männliche Bewerber zu bevorzugen. Sie begann, Lebensläufe mit dem Wort „Frauen“ (wie etwa „Kapitänin eines Frauenschachclubs“) und von Frauenhochschulen herabzustufen..

Im Jahr 2015 erkannte Amazon, dass das Tool nicht geschlechtsneutral war und Diskriminierung weiblicher BewerberTrotz der Versuche, das Modell zu optimieren, konnten sie nicht garantieren, dass es nicht neue Wege finden würde, verzerrt zu werden, und das Projekt wurde schließlich aufgegeben..

Lektion gelernt: Dieser Fall zeigt die Gefahren des Einsatzes von KI ohne angemessene Voreingenommenheitsprüfung. Amazons Absicht war nicht die Diskriminierung – die Voreingenommenheit war eine emergente Eigenschaft historischer Daten und unkontrollierter Algorithmen.

Für Unternehmen besteht die Lehre darin, KI-Modelle gründlich auf unterschiedliche Auswirkungen zu testen vor Sie werden bei Einstellungs- oder anderen sensiblen Entscheidungen nicht verwendet. Es ist wichtig, vielfältige Trainingsdaten zu verwenden und Experten einzubeziehen, um Algorithmen auf Voreingenommenheit zu prüfen.

Die Erfahrungen von Amazon unterstreichen auch, dass KI das menschliche Urteilsvermögen bei der Einstellung von Mitarbeitern ergänzen und nicht ersetzen sollte. Personalvermittler müssen wachsam bleiben und dürfen einem Bewertungsalgorithmus nicht blind vertrauen.

Die Folgen für Amazon waren interne Peinlichkeiten und ein öffentliches Beispiel dafür, „was alles schiefgehen kann“ – andere Unternehmen berufen sich nun auf diesen Fall, um für ein verantwortungsvolleres KI-Design einzutreten..

Zusamenfassend: In der KI können algorithmische Verzerrungen lauern – finden und beheben Sie sie frühzeitig um kostspielige Ausfälle zu vermeiden.

Googles KI-Ethik-Kontroverse und Gegenwehr der Mitarbeiter

Der Fehler: Im Jahr 2020 geriet Google, ein führendes Unternehmen im Bereich KI, in interne Turbulenzen, als sich die prominente KI-Ethikforscherin Dr. Timnit Gebru unter umstrittenen Umständen vom Unternehmen trennte. Gebru, Co-Leiterin des Google-Teams für ethische KI, war Mitautorin eines Papiers, das die Risiken großer Sprachmodelle (der Art von KI, die Googles Suche und Produkte antreibt) hervorhob.

Sie behauptet, Google habe sie wegen ethischer Bedenken hinausgedrängt, während Googles offizielle Darstellung lautete, es habe Meinungsverschiedenheiten über den Veröffentlichungsprozess gegeben.Der Vorfall wurde schnell öffentlich, und über 1.200 Google-Mitarbeiter unterzeichneten einen Brief, in dem sie gegen ihre Entlassung protestierten und Google vorwarfen, kritische Forschung zu zensieren..

Dies geschah nach anderen Kontroversen, wie etwa der 2019 von Google eingerichteten Ethikkommission für KI, die aufgrund öffentlicher Proteste über die Auswahl ihrer Mitglieder wieder aufgelöst wurde. Insbesondere der Gebru-Vorfall löste eine globale Debatte über das Engagement der großen Technologieunternehmen für ethische KI und den Umgang mit Whistleblowern aus.

Lektion gelernt: Die Turbulenzen bei Google lehren Unternehmen, dass Ethische Bedenken hinsichtlich der KI müssen auf höchster Ebene ernst genommen werden, und diejenigen, die sie äußern, sollten gehört und nicht zum Schweigen gebracht werden.Der Widerstand der Mitarbeiter hat gezeigt, dass ein Mangel an Transparenz und Verantwortlichkeit im Umgang mit internen Ethikfragen die Moral und den Ruf des Unternehmens schwer schädigen kann.

Für Unternehmen ist der Aufbau einer Kultur der ethischen Auseinandersetzung mit KI entscheidend. Ermutigen Sie Ihre Teams, die Auswirkungen von KI zu hinterfragen, und belohnen Sie Kriegsdienstverweigerer, anstatt sie zu bestrafen. Der Vorfall verdeutlichte auch die Notwendigkeit externer Aufsicht: Viele argumentierten, unabhängige Ethikkommissionen oder Audits durch Dritte hätten eine Eskalation des Konflikts verhindern können.

Im Wesentlichen ist Googles Erfahrung eine Warnung, dass selbst die fortschrittlichsten KI-Unternehmen nicht vor ethischen Verfehlungen gefeit sind. Dies hat Googles Glaubwürdigkeit in Sachen verantwortungsvolle KI stark beschädigt. Unternehmen sollten daher Ethik in ihren KI-Entwicklungsprozess integrieren und sicherstellen, dass die Führung diese Mission unterstützt, um öffentliche Kontroversen und Vertrauensverlust zu vermeiden.

Clearview AI und die Datenschutzdebatte zur Gesichtserkennung

Der Fehler: Clearview AI, ein Startup für Gesichtserkennung, hat ein umstrittenes Tool entwickelt, indem es ohne Erlaubnis über 3 Milliarden Fotos aus sozialen Medien und von Websites gescraped hat. Es wurde eine App entwickelt, mit der Kunden (einschließlich Strafverfolgungsbehörden) ein Foto einer Person hochladen und im Internet nach Übereinstimmungen suchen können, wodurch die Anonymität im Wesentlichen untergraben wird.

Als die New York Times Clearview im Jahr 2020 entlarvte, entbrannte ein Sturm der Entrüstung über Datenschutz und Einwilligung. Aufsichtsbehörden in mehreren Ländern stellten fest, dass Clearview gegen Datenschutzgesetze verstieß – so wurde das Unternehmen beispielsweise in Illinois auf Grundlage des Biometric Information Privacy Act verklagt und stimmte schließlich Beschränkungen beim Verkauf seiner Dienste zu..

Clearview wurde in Europa wegen unrechtmäßiger Datenverarbeitung mit Millionenstrafen belegt. Die Öffentlichkeit war alarmiert, dass Fotos von Personen (z. B. Facebook- oder LinkedIn-Profilen) dazu verwendet werden könnten, sie ohne ihr Wissen zu identifizieren und zu verfolgen. Dieser Fall wurde zum Paradebeispiel für eine KI-gesteuerte Überwachung, die zu weit ging.

Lektion gelernt: Clearview AI veranschaulicht, dass nur weil KI etwas kann, heißt das nicht, dass sie es auch tun sollteAus ethischer und geschäftlicher Sicht kann die Missachtung von Datenschutznormen schwerwiegende Folgen und rechtliche Konsequenzen haben. Unternehmen, die mit Gesichtserkennung oder biometrischer KI arbeiten, sollten die Zustimmung zur Datennutzung einholen und die Einhaltung der Vorschriften sicherstellen – andernfalls kann ein Geschäftsmodell scheitern.

Die Probleme von Clearview veranlassten auch Technologieunternehmen wie Google und Facebook, das Unternehmen zu fordern, die Datensammlung einzustellen. Der Vorfall unterstreicht die Bedeutung von Privacy-by-Design in KI-Produkten. Für politische Entscheidungsträger war dies ein Weckruf, dass strengere Regeln für KI-Überwachungstechnologie erforderlich sind.

Die Lehre für Unternehmen ist klar: Die gesellschaftliche Akzeptanz von KI-Produkten ist wichtig. Wenn Menschen das Gefühl haben, dass eine KI-Anwendung ihre Privatsphäre oder Menschenrechte verletzt, werden sie sich energisch wehren (durch Gerichte, die öffentliche Meinung und Regulierung). Verantwortungsvolle KI erfordert die Balance zwischen Innovation und Respekt für die Privatsphäre des Einzelnen sowie ethischen Grenzen. Wer diese Balance nicht findet, muss, wie Clearview erfahren musste, mit schwerwiegenden Konsequenzen rechnen.

Von KI generierte Fehlinformationen während Wahlen

Der Fehler: In den letzten Wahlzyklen gab es Fälle, in denen KI zur Generierung irreführender Inhalte eingesetzt (oder missbraucht) wurde, was Zweifel an der Integrität demokratischer Prozesse aufkommen ließ. Ein Beispiel hierfür ereignete sich bei den internationalen Wahlen 2024, als Beobachter Dutzende von KI-generierten Bildern und Deepfake-Videos in den sozialen Medien entdeckten, die entweder Kandidaten diffamieren oder Verwirrung stiften sollten. In einem Fall tauchte ein Deepfake-Video eines Präsidentschaftskandidaten auf, das ihn fälschlicherweise bei aufrührerischen Äußerungen zeigte – es wurde zwar schnell entlarvt, erreichte aber zuvor bereits Tausende von Aufrufen.

In ähnlicher Weise wurden Netzwerke von KI-gesteuerten Bots eingesetzt, um Diskussionsforen mit Propaganda zu überfluten. Obwohl es schwierig ist, einen einzigen Wahl-„Misserfolg“ zu benennen, der ausschließlich auf KI zurückzuführen ist, ist die wachsende Zahl von Von KI generierte Desinformation wird als Versagen der Tech-Plattformen angesehen, den böswilligen Akteuren immer einen Schritt voraus zu sein. Sorge wurde so groß, dass Experten und Beamte vor wichtigen Wahlen vor einer „Deepfake-Gefahr“ warnten und Organisationen wie das Weltwirtschaftsforum KI-gesteuerte Desinformation als ernstes kurzfristiges globales Risiko bezeichneten.

Lektion gelernt: Die Verbreitung von KI-generierten Wahlfehlinformationen lehrt die Beteiligten – insbesondere Technologieunternehmen und politische Entscheidungsträger –, dass Im Zeitalter der KI sind proaktive Maßnahmen erforderlich, um die Wahrheit zu verteidigenSocial-Media-Unternehmen haben gelernt, dass sie ihre KI-Erkennungssysteme für gefälschte Inhalte verbessern und sich mit den Wahlbehörden abstimmen müssen, um irreführende Medien schnell zu entfernen oder zu kennzeichnen.

Auch für die öffentliche Bildung bietet sich eine Lektion: Bürger werden nun dazu angehalten, Sensationsmedien skeptisch gegenüberzustehen und Quellen zu überprüfen. Sie werden so zu Faktenprüfern gegen KI-Fälschungen. Für Unternehmen im Social-Media-, Werbe- oder Mediensektor kann die Investition in Technologien zur Inhaltsauthentifizierung (wie Wasserzeichen für authentische Inhalte oder Blockchain-Datensätze für Videos) ein ethisches Unterscheidungsmerkmal sein.

Politisch hat dieses Thema Forderungen nach einer stärkeren Regulierung politischer Anzeigen und Deepfakes ausgelöst. Kurz gesagt: Der Kampf gegen KI-gestützte Falschinformationen bei Wahlen unterstreicht die Verantwortung der KI-Einsatzkräfte, Missbrauch zu verhindern. Bei der ethischen KI-Praxis geht es nicht nur um den direkten Anwendungsfall, sondern auch darum, zu berücksichtigen, wie die eigene Technologie von anderen als Waffe eingesetzt werden könnte – und Maßnahmen zu ergreifen, um dieses Risiko zu minimieren.

Teslas Autopilot und die Ethik der KI in autonomen Fahrzeugen

Der Fehler: Teslas Autopilot – ein KI-System zur Fahrassistenz – war in mehrere Unfälle verwickelt, darunter auch tödliche. Dies warf Fragen zur Einsatzbereitschaft und Sicherheit der teilautonomen Fahrtechnologie auf. Ein vielbeachteter Vorfall aus dem Jahr 2018 betraf einen Tesla im Autopilot-Modus, der einen querenden Sattelschlepper nicht erkannte, was zu einem tödlichen Unfall führte. Untersuchungen ergaben, dass das Fahrerassistenzsystem nicht für die vorgefundenen Straßenverhältnisse ausgelegt war, dennoch wurde sein Betrieb dort nicht verhindert..

Es gab weitere Unfälle, bei denen Fahrer dem Autopiloten übermäßig vertrauten und unaufmerksam wurden, obwohl Tesla sie ermahnte, aufmerksam zu bleiben. Aus ethischer Sicht verdeutlichen diese Vorfälle die Grauzone zwischen Fahrer- und Herstellerverantwortung. Teslas Vermarktung der Funktion als „Autopilot“ wurde kritisiert, da sie Fahrern möglicherweise ein falsches Sicherheitsgefühl vermittelt.

Im Jahr 2023 untersuchte die US-amerikanische National Highway Traffic Safety Administration sogar, ob Konstruktionsfehler des Autopiloten zu Unfällen beitrugen, was zu Rückrufen und Software-Updates führte.

Lektion gelernt: Der Fall Tesla Autopilot unterstreicht, dass Sicherheit muss beim Einsatz von KI an erster Stelle stehen, und Transparenz über Einschränkungen ist entscheidendWenn Menschenleben auf dem Spiel stehen, wie im Transportwesen, ist die Einführung von KI, deren Sicherheit nicht vollständig nachgewiesen ist, ethisch problematisch. Tesla (und andere Hersteller autonomer Fahrzeuge) haben gelernt, die Fahrerüberwachung zu verstärken, um die Aufmerksamkeit der Menschen zu gewährleisten, und in der Dokumentation klarzustellen, dass diese Systeme unterstützend und nicht vollständig selbstfahrend.

Eine weitere Lektion betrifft die Verantwortlichkeit: Nachdem in ersten Untersuchungen „menschliches Versagen“ festgestellt wurde, wurde Tesla in späteren Untersuchungen auch dafür verantwortlich gemacht, dass es die Nutzung außerhalb der vorgesehenen Bedingungen erlaubte.Dies deutet darauf hin, dass Unternehmen eine Mitschuld tragen, wenn ihre KI Missbrauch fördert. Hersteller müssen robuste Sicherheitsvorkehrungen treffen – zum Beispiel, indem sie den Autopiloten nicht auf Straßen einsetzen lassen, für die er nicht ausgelegt ist, oder indem sie die Kontrolle lange vor Erreichen der Leistungsgrenze des Systems an den Fahrer zurückgeben.

Aus ethischer Sicht ist es unerlässlich, den Kunden klar zu vermitteln, was die KI kann und was nicht (keine übertriebene Werbung). Für jedes Unternehmen, das KI in Produkten einsetzt, ist Teslas Erfahrung eine Mahnung, mit dem Unerwarteten zu rechnen und bei der Entwicklung auf Sicherheit zu achten. Testen Sie KI in verschiedenen Szenarien, überwachen Sie sie kontinuierlich im Feld und reagieren Sie bei ethischen oder sicherheitsrelevanten Problemen schnell (z. B. durch Rückrufe, Updates oder sogar die Deaktivierung von Funktionen), bevor weiterer Schaden entsteht.

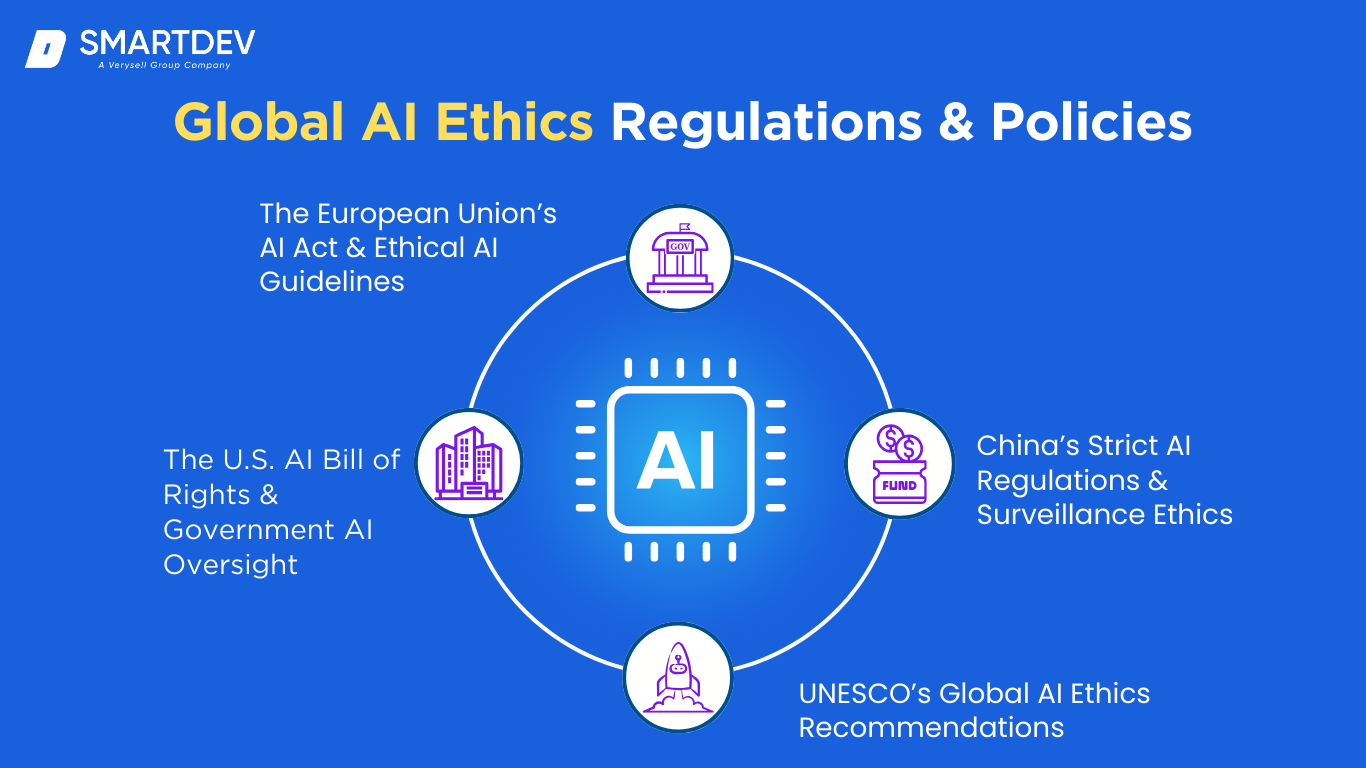

Globale KI-Ethikvorschriften und -richtlinien

Weltweit entwickeln Regierungen und Normungsorganisationen Rahmenbedingungen, um eine ethische Entwicklung und Nutzung von KI sicherzustellen. Die Überwachung dieser Richtlinien ist für Unternehmen von entscheidender Bedeutung, da sie die Spielregeln für KI-Innovationen festlegen.

Weltweit entwickeln Regierungen und Normungsorganisationen Rahmenbedingungen, um eine ethische Entwicklung und Nutzung von KI sicherzustellen. Die Überwachung dieser Richtlinien ist für Unternehmen von entscheidender Bedeutung, da sie die Spielregeln für KI-Innovationen festlegen.

Hier sind einige wichtige globale Initiativen, die sich mit Ethische Bedenken hinsichtlich der KI:

Das KI-Gesetz und die ethischen KI-Richtlinien der Europäischen Union

Die EU übernimmt eine Vorreiterrolle bei der Regulierung der KI mit ihrem bevorstehenden KI-Gesetz, der erste umfassende Rechtsrahmen für KI. Das KI-Gesetz verfolgt einen risikobasierten Ansatz: Es kategorisiert KI-Systeme nach Risikostufen (inakzeptables Risiko, hohes Risiko, begrenztes Risiko, minimales Risiko) und legt entsprechende Anforderungen fest. Insbesondere werden bestimmte KI-Praktiken, die als zu schädlich erachtet werden, gänzlich verboten – zum Beispiel Social-Scoring-Systeme wie in China oder biometrische Echtzeitüberwachung in der Öffentlichkeit (mit wenigen Ausnahmen).

Für KI mit hohem Risiko (wie etwa Algorithmen für Personalbeschaffung, Kreditvergabe, Strafverfolgung usw.) gelten strenge Verpflichtungen hinsichtlich Transparenz, Risikobewertung und menschlicher Aufsicht. Ziel ist es sicherzustellen, vertrauenswürdige KI die die Werte und Grundrechte der EU hochhält. Unternehmen, die in Europa KI einsetzen, müssen sich an die Vorschriften halten, andernfalls drohen ihnen hohe Geldstrafen (ähnlich wie die DSGVO den Datenschutz durchgesetzt hat).

Darüber hinaus verfügt die EU über nicht bindende Richtlinien für ethische KI (von Experten im Jahr 2019 entwickelt), in dem Grundsätze wie Transparenz, Rechenschaftspflicht, Datenschutz und gesellschaftliches Wohlergehen dargelegt werden – diese haben den Ansatz des AI Act beeinflusst. Für Unternehmensführer ist die wichtigste Erkenntnis, dass die EU erwartet, dass KI „ethische Leitplanken“, und die Einhaltung erfordert Sorgfalt in Bereichen wie der Dokumentation von Algorithmen, der Minderung von Verzerrungen und der Gewährung von Benutzerrechten (wie etwa Erklärungen zu KI-Entscheidungen).

Das KI-Gesetz soll bald verabschiedet werden, und zukunftsorientierte Unternehmen richten ihre KI-Systeme bereits an den Bestimmungen aus, um Störungen zu vermeiden. Europas Regulierungsinitiative ist ein Zeichen dafür, dass ethische KI zu einem durchsetzbaren Gesetz wird.

Die US-amerikanische KI-Bill of Rights und die staatliche KI-Aufsicht

In den Vereinigten Staaten gibt es zwar noch kein KI-spezifisches Gesetz, das so umfassend ist wie das der EU, aber es gibt wichtige Initiativen, die die politische Richtung vorgeben. Ende 2022 führte das Büro für Wissenschafts- und Technologiepolitik des Weißen Hauses ein Blaupause für eine KI-Bill of Rights – ein Satz von fünf Leitprinzipien für die Entwicklung und den Einsatz von KI-SystemenZu diesen Grundsätzen gehören: Sichere und effektive Systeme (KI sollte auf Sicherheit getestet werden), Schutz vor algorithmischer Diskriminierung (KI sollte nicht voreingenommen diskriminieren), Datenschutz (Nutzer sollen die Kontrolle über die Daten haben und die Privatsphäre soll geschützt werden), Hinweis und Erläuterung (Menschen sollten wissen, wann eine KI eingesetzt wird und ihre Entscheidungen verstehen) und Menschliche Alternativen, Erwägungen und Rückfall (Es sollte menschliche Optionen und die Möglichkeit geben, sich in kritischen Szenarien von der KI abzumelden).

Obwohl diese „KI-Bill of Rights“ kein Gesetz ist, bietet sie Bundesbehörden und Unternehmen einen politischen Leitfaden. Wir beobachten zudem eine verstärkte Kontrolle von KI durch bestehende Gesetze – beispielsweise untersucht die Equal Employment Opportunity Commission (EEOC) voreingenommene Einstellungsalgorithmen im Rahmen von Antidiskriminierungsgesetzen, und die Federal Trade Commission (FTC) warnt vor fragwürdigen KI-Produkten und deutet an, dass sie Verbraucherschutzgesetze gegen falsche KI-Behauptungen oder schädliche Praktiken einsetzen wird.

Darüber hinaus entstehen branchenspezifische Regelungen: Die FDA arbeitet an Richtlinien für KI in Medizinprodukten und die Finanzaufsichtsbehörden an Richtlinien für KI im Bankwesen. Politiker im Kongress haben verschiedene Gesetzesentwürfe zu Transparenz und Rechenschaftspflicht im KI-Bereich vorgelegt, von denen jedoch noch keiner verabschiedet wurde.

Für Unternehmen in den USA bedeutet das Fehlen eines einheitlichen Gesetzes nicht, dass es an Aufsicht mangelt – die Behörden nutzen Vorschriften, um die Auswirkungen von KI abzudecken (so kann beispielsweise eine voreingenommene KI-Entscheidung immer noch gegen Bürgerrechte verstoßen). Die Anpassung an die Geist Die Umsetzung der AI Bill of Rights – KI-Systeme fair, transparent und kontrollierbar zu machen – ist eine kluge Strategie, um auf künftige, wahrscheinlich formellere US-Vorschriften vorbereitet zu sein.

Chinas strenge KI-Vorschriften und Überwachungsethik

China verfügt über ein sehr aktives Regulierungsumfeld für KI. Dies spiegelt den Wunsch der Regierung wider, sowohl das KI-Wachstum zu fördern als auch die Kontrolle über ihre gesellschaftlichen Auswirkungen zu behalten. Im Gegensatz zu westlichen Ansätzen, die individuelle Rechte betonen, ist Chinas KI-Governance eng mit den staatlichen Prioritäten (einschließlich sozialer Stabilität und Parteiwerten) verknüpft. In den letzten Jahren hat China bahnbrechende Regeln eingeführt, wie zum Beispiel die „Bestimmungen zum algorithmischen Empfehlungsmanagement für Internetinformationsdienste“ (gültig ab März 2022), die Unternehmen dazu verpflichten, ihre Algorithmen bei den Behörden registrieren, transparent über ihre Verwendung sein und sich nicht an Praktiken beteiligen, die die nationale Sicherheit oder die soziale Ordnung gefährden.

Diese Regeln schreiben den Nutzern auch die Möglichkeit vor, Empfehlungsalgorithmen zu deaktivieren und verlangen, dass Algorithmen „positive Energie“ fördern (im Einklang mit genehmigten Inhalten). Anfang 2023 führte China die Bestimmungen zur Tiefensynthese Deepfakes zu regulieren – die Forderung, dass KI-generierte Medien klar gekennzeichnet sein und nicht zur Verbreitung falscher Informationen verwendet werden dürfen, andernfalls drohen rechtliche Sanktionen. Darüber hinaus hat China Regelungsentwürfe für generative KI Dienste (wie Chatbots), deren Ergebnisse sozialistische Grundwerte widerspiegeln und die Staatsmacht nicht untergraben sollen.

In ethischer Hinsicht setzt China zwar massiv KI zur Überwachung ein (z. B. durch Gesichtserkennung zur Überwachung von Bürgern und ein neu entstehendes Sozialkreditsystem), beschäftigt sich aber paradoxerweise auch mit ethischen Fragen, da diese den sozialen Zusammenhalt beeinträchtigen. So hat China beispielsweise KI, die die Mimik von Bewerbern in Vorstellungsgesprächen analysiert, verboten, da dies als Eingriff in die Privatsphäre angesehen wird. Die Regierung untersucht auch wissenschaftlich ethische Richtlinien für KI, die Durchsetzung erfolgt jedoch meist durch strenge Kontrolle und Zensur.

Für Unternehmen, die in China tätig sind oder mit chinesischen Verbraucherdaten arbeiten, ist die Einhaltung dieser detaillierten Vorschriften zwingend erforderlich – Algorithmen müssen transparent sein, d. h. den Aufsichtsbehörden bekannt sein, und die von KI generierten Inhalte werden streng überwacht. Die ethische Debatte ist komplex: Chinas Regeln mögen zwar einige Schäden (wie Deepfake-Betrug) verhindern, zementieren aber auch die staatliche Aufsicht über KI und wecken Bedenken hinsichtlich der Freiheit. Dennoch unterstreicht Chinas Ansatz einen wichtigen Punkt: Regierungen können und werden die Kontrolle über KI-Technologien ausüben um ihre politischen Ziele zu erreichen, und die Unternehmen müssen diese Anforderungen sorgfältig umsetzen, sonst laufen sie Gefahr, von einem riesigen Markt ausgeschlossen zu werden.

UNESCO-Empfehlungen zur globalen KI-Ethik

Auf multinationaler Ebene hat die UNESCO die Bemühungen zur Schaffung eines übergreifenden ethischen Rahmens für KI vorangetrieben. Im November 2021 verabschiedeten alle 193 UNESCO-Mitgliedsstaaten den Empfehlung zur Ethik der Künstlichen Intelligenz, das erste globale Standardinstrument zur KI-EthikDieses umfassende Dokument ist kein verbindliches Gesetz, bietet aber einen gemeinsamen Bezugspunkt für Länder, die nationale KI-Richtlinien entwickeln.

Die UNESCO-Empfehlung skizziert Werte und Prinzipien wie Menschenwürde, Menschenrechte, ökologische Nachhaltigkeit, Vielfalt und Inklusion sowie Frieden und fordert im Wesentlichen, dass KI so gestaltet wird, dass diese Werte respektiert und gefördert werden. Sie fordert Maßnahmen wie: die Bewertung der Auswirkungen von KI auf Gesellschaft und Umwelt, Bildung und Schulung im Bereich ethische KI sowie internationale Zusammenarbeit bei der KI-Governance.

So schlägt sie beispielsweise ein Verbot von KI-Systemen vor, die menschliches Verhalten manipulieren, sowie Schutzmaßnahmen gegen den Missbrauch biometrischer Daten. Diese Richtlinien sind zwar hochrangig, haben aber moralisches Gewicht und beeinflussen die Politik. Bereits jetzt ist eine Übereinstimmung erkennbar: Das KI-Gesetz der EU und verschiedene nationale KI-Strategien greifen Themen der UNESCO-Empfehlungen auf (wie Risikobewertung und menschliche Aufsicht).

Für Unternehmen und politische Entscheidungsträger signalisiert das Engagement der UNESCO, dass KI-Ethik ein globales und nicht nur ein nationales Anliegen ist. Grenzüberschreitend tätige Unternehmen könnten sich letztlich mit einem Flickenteppich an Vorschriften konfrontiert sehen, doch der Rahmen der UNESCO könnte zu einer Harmonisierung beitragen. Ethisch gesehen ist es eine Erinnerung daran, dass die Auswirkungen von KI Grenzen überschreiten – Themen wie Deepfakes, Voreingenommenheit oder autonome Waffen sind international und erfordern Zusammenarbeit.

Organisationen sollten sich solcher globalen Normen bewusst sein, da sie oft konkreten Regelungen vorausgehen. Die freiwillige Übernahme der UNESCO-Prinzipien kann den Ruf eines Unternehmens als ethisch führendes Unternehmen im Bereich KI stärken und es auf die sich entwickelnden Erwartungen von Regierungen und der Öffentlichkeit weltweit vorbereiten.

ISO- und IEEE-Standards für ethische KI

Neben Regierungen gibt es auch Standardisierungsgremien wie ISO (Internationale Organisation für Normung) Und IEEE (Institut für Elektro- und Elektronikingenieure) entwickeln technische Standards für eine ethische KI-Entwicklung. Diese Standards sind keine Gesetze, sondern bieten Best Practices und können im Rahmen der Selbstregulierung der Branche oder der Beschaffungsanforderungen übernommen werden.

Die ISO arbeitet über ihren Unterausschuss SC 42 für KI an Richtlinien für KI-Governance und Vertrauenswürdigkeit. So konzentriert sich ISO/IEC 24028 beispielsweise auf die Bewertung der Robustheit von Algorithmen des maschinellen Lernens, und ISO/IEC 23894 bietet Leitlinien zum Risikomanagement für KI und hilft Unternehmen, Risiken wie Verzerrungen, Fehler oder Sicherheitsprobleme zu erkennen und zu minimieren.Durch die Einhaltung der ISO-Normen kann ein Unternehmen ethische Aspekte (Fairness, Zuverlässigkeit, Transparenz) systematisch berücksichtigen und Prüfern oder Kunden anhand der Dokumentation nachweisen, dass die gebotene Sorgfalt walten gelassen wurde.

Das IEEE hat einen sehr direkten Ansatz zur KI-Ethik gewählt mit seinem Ethik in autonomen Systemen Initiative, die die IEEE 7000-Standardreihe hervorbringt. Dazu gehören Standards wie IEEE 7001 für Transparenz autonomer Systeme, IEEE 7002 für Datenschutz in der KI, IEEE 7010 für die Bewertung der Auswirkungen von KI auf das Wohlbefinden und andere.. Ein bemerkenswertes Beispiel hierfür ist IEEE 7000-2021, ein Modellprozess für Ingenieure zur Berücksichtigung ethischer Bedenken beim Systemdesign – im Wesentlichen eine Anleitung für „Ethik durch Design“. Ein weiteres Beispiel, IEEE 7003, befasst sich mit Überlegungen zu algorithmischen Verzerrungen.

Die Einhaltung von IEEE-Standards kann Entwicklern helfen, Werte wie Fairness und Erklärbarkeit von Grund auf in die Technologie zu integrieren. Unternehmen streben zunehmend Zertifizierungen oder Audits anhand dieser Standards an, um Vertrauenswürdigkeit zu signalisieren (IEEE bietet beispielsweise ein Zertifizierungsprogramm für ethische KI an). Der Vorteil von Standards besteht darin, dass sie konkrete Checklisten und Prozesse zur Umsetzung abstrakter ethischer Prinzipien bieten.

Wenn Regulierungsbehörden die Durchsetzung ethischer Grundsätze im Bereich KI anstreben, beziehen sie sich häufig auf diese Standards. In der Praxis ist ein Unternehmen, das seine KI-Projekte an den ISO/IEEE-Richtlinien ausrichtet, weniger anfällig für neue Regeln oder Bedenken der Stakeholder. Es ist eine Investition in Qualität und Governance Dies kann sich in einer reibungsloseren Einhaltung von Vorschriften, besseren KI-Ergebnissen und einem gesteigerten Vertrauen der Stakeholder auszahlen.

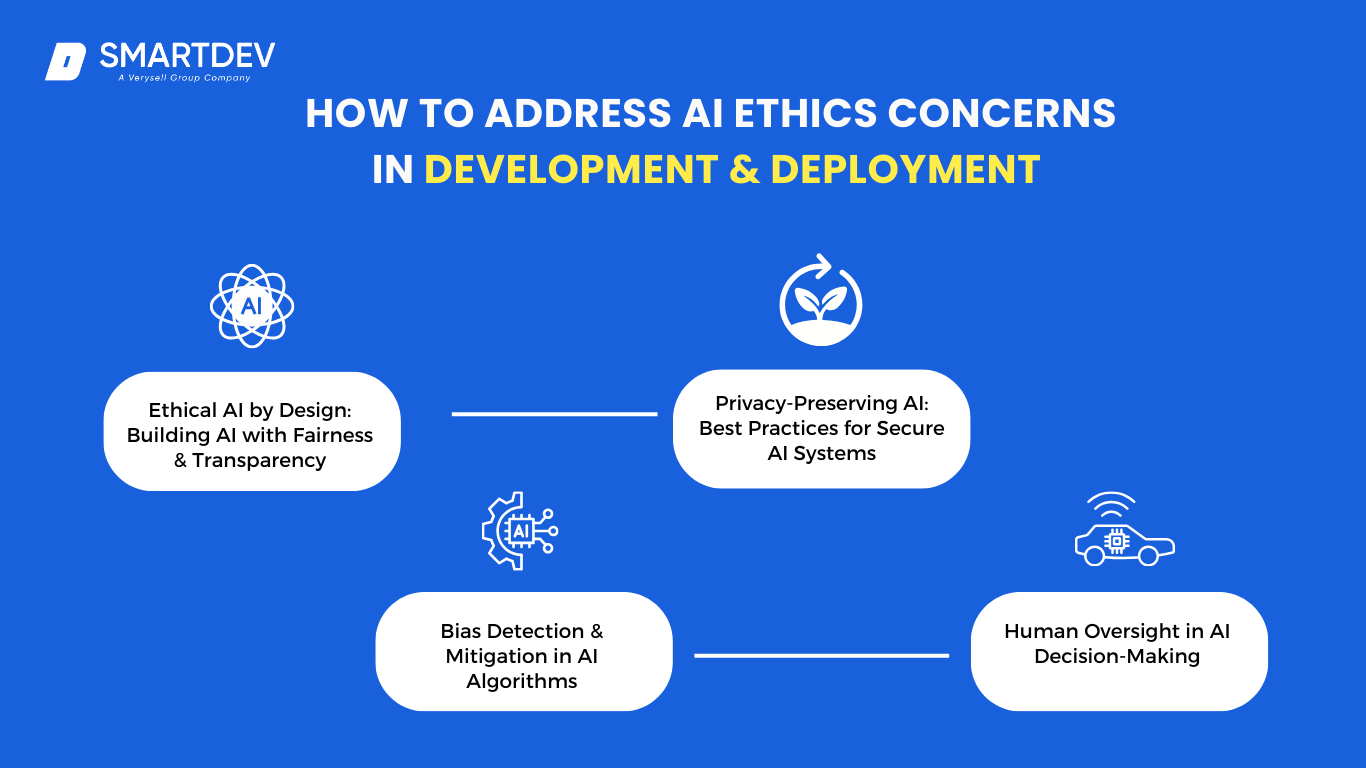

Wie man ethische Bedenken hinsichtlich KI bei Entwicklung und Einsatz berücksichtigt

Das Verständnis ethischer KI-Bedenken ist nur die halbe Miete – die andere Hälfte besteht darin, diese Probleme beim Aufbau oder Einsatz von KI-Systemen konkret anzugehen. Für Unternehmen kann ein proaktiver und systematischer Ansatz für ethische KI ein potenzielles Risiko in eine Stärke verwandeln.

Das Verständnis ethischer KI-Bedenken ist nur die halbe Miete – die andere Hälfte besteht darin, diese Probleme beim Aufbau oder Einsatz von KI-Systemen konkret anzugehen. Für Unternehmen kann ein proaktiver und systematischer Ansatz für ethische KI ein potenzielles Risiko in eine Stärke verwandeln.

Hier sind die wichtigsten Strategien für Verantwortungsvolle Entwicklung und Bereitstellung von KI:

Ethische KI durch Design: KI mit Fairness und Transparenz entwickeln

So wie Produkte auf Sicherheit oder Benutzerfreundlichkeit ausgelegt werden können, sollten KI-Systeme von Anfang an auf Ethik ausgelegt„Ethical AI by Design“ bedeutet, Prinzipien wie Fairness, Transparenz und Verantwortlichkeit in den KI-Entwicklungszyklus zu integrieren. In der Praxis bedeutet dies, einen KI-Ethikrahmen oder eine Charta in Ihrem Unternehmen zu etablieren (viele Unternehmen haben dies bereits getan, wie der starke Anstieg ethischer KI-Chartas zeigt)..

Beginnen Sie jedes KI-Projekt mit der Identifizierung potenzieller ethischer Risiken und der betroffenen Stakeholder. Wenn Sie beispielsweise eine KI für die Kreditvergabe entwickeln, berücksichtigen Sie das Diskriminierungsrisiko und die Stakeholder (Antragsteller, Aufsichtsbehörden, die Community), die berücksichtigt werden müssen. Implementieren Sie dann Fairnesskriterien in den Modellzielen – nicht nur in der Genauigkeit, sondern auch in Maßnahmen zur Minimierung von Verzerrungen zwischen Gruppen. Wählen Sie die Trainingsdaten sorgfältig aus (vielfältig, repräsentativ und vor der Verwendung auf Verzerrungen geprüft).

Darüber hinaus gestalten Sie das System so, dass so transparent wie möglich: Dokumentieren Sie, wie das Modell erstellt wurde, warum bestimmte Funktionen verwendet werden und wie es sich bei verschiedenen Datensegmenten verhält. Entscheiden Sie sich nach Möglichkeit für einfachere Modelle oder Techniken wie erklärbare KI, die Begründungen für Entscheidungen liefern können. Bei Verwendung eines komplexen Modells sollten Sie die Entwicklung eines erklärenden Begleitsystems in Erwägung ziehen, das das Verhalten des Hauptmodells analysieren kann.

Wichtig ist, ein vielfältiges Team in den Designprozess einzubeziehen – mit Menschen unterschiedlicher Herkunft und sogar Ethikern oder Fachexperten, die Probleme erkennen können, die Entwickler möglicherweise übersehen. Indem Unternehmen diese Schritte bereits in der frühen Designphase integrieren (anstatt am Ende zu versuchen, ethische Aspekte nachzurüsten), können sie viele Fallstricke vermeiden. Ethische KI vermittelt den Mitarbeitern zudem, dass verantwortungsvolle Innovation erwartet wird und nicht erst im Nachhinein erfolgt.

Dieser Ansatz trägt dazu bei, KI-Produkte zu entwickeln, die nicht nur gut funktionieren, sondern auch vom ersten Tag an mit gesellschaftlichen Werten und Benutzererwartungen übereinstimmen.

Erkennung und Minderung von Verzerrungen in KI-Algorithmen

Da Voreingenommenheit in der KI schädlich sein kann und mit bloßem Auge schwer zu erkennen ist, sollten Organisationen formelle Erkennung und Minderung von Voreingenommenheit Prozesse. Testen Sie KI-Modelle vor dem Einsatz zunächst an verschiedenen demografischen Gruppen und Schlüsselsegmenten. Wenn Sie beispielsweise eine KI zur Überprüfung von Lebensläufen einsetzen, bewerten Sie deren Empfehlungen für männliche und weibliche Kandidaten, für verschiedene ethnische Gruppen usw., um festzustellen, ob Fehlerraten oder Auswahlen ungleichmäßig sind. Techniken wie die Disparate Impact Analysis (Prüfung, ob Entscheidungen eine geschützte Gruppe unverhältnismäßig schädigen) sind hilfreich.

Wenn Probleme gefunden werden, sind entsprechende Maßnahmen erforderlich: Dies kann eine Neuschulung des Modells mit ausgewogeneren Daten oder die Anpassung der Modellparameter oder Entscheidungsschwellenwerte zur Korrektur der Schiefe umfassen. In manchen Fällen können algorithmische Techniken wie Neuabtastung (Ausbalancierung der Trainingsdaten), Neugewichtung (Beispielen aus Minderheitsklassen während des Trainings mehr Bedeutung beimessen) oder dem Optimierungsziel des Modells Fairnessbeschränkungen hinzufügen (sodass es direkt versucht, Parität zwischen Gruppen zu erreichen).

Beispielsweise könnte eine KI zur Bilderkennung, die anfänglich mit dunkleren Hauttönen zu kämpfen hatte, mit vielfältigeren Bildern und einer angepassten Architektur neu trainiert werden, um eine gleichbleibende Genauigkeit zu gewährleisten. Eine weitere wichtige Abhilfemaßnahme ist die Merkmalsauswahl. Stellen Sie sicher, dass Attribute, die für geschützte Merkmale stehen (die Postleitzahl könnte beispielsweise stellvertretend für die ethnische Zugehörigkeit stehen), sorgfältig behandelt oder entfernt werden, wenn dies nicht unbedingt erforderlich ist. Dokumentieren Sie alle diese Eingriffe im Rahmen einer algorithmische Verantwortlichkeit Bericht.

Darüber hinaus ist die Minderung von Verzerrungen keine einmalige Lösung; sie erfordert eine kontinuierliche Überwachung. Sobald die KI in Produktion ist, sollten die Ergebnisse nach Möglichkeit nach demografischen Merkmalen verfolgt werden. Sollten neue Verzerrungen auftreten (z. B. wenn sich der Datenfluss verschiebt oder eine bestimmte Benutzergruppe anders behandelt wird), benötigen Sie einen Prozess, um diese zu erkennen und zu korrigieren.

Es gibt auch neue Tools und Toolkits (wie IBMs AI Fairness 360, eine Open-Source-Bibliothek), die Metriken und Algorithmen zur Erkennung und Minderung von Vorurteilen bereitstellen – Unternehmen können diese in ihre Entwicklungspipeline integrieren. Indem Unternehmen aktiv nach Vorurteilen suchen und KI-Systeme optimieren, um diese zu reduzieren, schaffen sie fairere Systeme und schützen sich gleichzeitig vor Diskriminierungsklagen.

Diese Arbeit kann eine Herausforderung darstellen, da vollkommene Fairness schwer zu erreichen und oft kontextabhängig ist. Doch aufrichtige und konsequente Bemühungen tragen wesentlich zu einer verantwortungsvollen KI-Praxis bei.

Menschliche Aufsicht bei KI-Entscheidungen

Egal wie fortgeschritten die KI wird, die Aufrechterhaltung menschliche Aufsicht ist entscheidend für ethische Sicherheit. Die Idee von „Human-in-the-Loop“ besteht darin, dass KI menschliche Entscheidungsträger in vielen Kontexten unterstützen, nicht vollständig ersetzen soll – insbesondere wenn Entscheidungen erhebliche ethische oder rechtliche Auswirkungen haben. Um dies umzusetzen, können Unternehmen Folgendes einrichten: Genehmigungsprozesse Dabei gibt KI eine Empfehlung ab, die ein Mensch validiert oder überschreibt, bevor Maßnahmen ergriffen werden. Beispielsweise kann eine KI eine Finanztransaktion als betrügerisch kennzeichnen, doch ein menschlicher Analyst überprüft den Fall, bevor die Karte des Kunden gesperrt wird, um sicherzustellen, dass es sich nicht um ein Fehlalarm handelt. Diese Art der Kontrolle kann verhindern, dass KI-Fehler Schaden anrichten.

In manchen Fällen könnte „Human-in-the-Loop“ zu langsam sein (z. B. bei Entscheidungen selbstfahrender Autos). Unternehmen könnten jedoch einen „Human-on-the-Loop“-Ansatz verfolgen, bei dem Menschen ein KI-System überwachen und eingreifen oder es abschalten können, wenn sie feststellen, dass es nicht richtig funktioniert. Der KI-Regelentwurf der EU schreibt tatsächlich eine menschliche Aufsicht für risikoreiche KI-Systeme vor., wobei betont wird, dass Benutzer oder Betreiber die Möglichkeit haben müssen, das Ergebnis zu interpretieren und zu beeinflussen.

Um die Aufsicht effektiv zu gestalten, sollten Unternehmen die menschlichen Vorgesetzten über die Fähigkeiten und Grenzen der KI schulen. Eine Herausforderung besteht darin Automatisierungsbias – Menschen können selbstgefällig werden und der KI zu viel vertrauen. Um dem entgegenzuwirken, können regelmäßige Übungen oder stichprobenartige Überprüfungen von KI-Entscheidungen menschliche Prüfer einbeziehen (z. B. Stichprobenprüfungen einiger Fälle, in denen die KI „Kredit ablehnen“ sagte, um sicherzustellen, dass die Entscheidung gerechtfertigt war).

Es ist außerdem wichtig, eine organisatorische Denkweise zu fördern, die menschliche Intuition und ethisches Urteilsvermögen neben algorithmischer Logik wertschätzt. Mitarbeiter an der Front sollten sich befugt fühlen, KI-Entscheidungen zu hinterfragen oder zu widerrufen, wenn ihnen etwas nicht passt. In der Luftfahrtindustrie werden Piloten darin geschult, wann sie sich auf den Autopiloten verlassen und wann sie die Kontrolle übernehmen sollen. Unternehmen sollten daher Protokolle entwickeln, wann sie sich auf KI verlassen und wann ein Mensch eingreifen muss.

Letztendlich bietet die menschliche Aufsicht ein Sicherheitsnetz und einen moralischen Kompass. Sie erkennt Probleme, die Algorithmen, denen es an echtem Verständnis oder Empathie mangelt, möglicherweise übersehen. Sie gibt den Kunden die Gewissheit, dass es Verantwortlichkeit gibt – das Wissen, dass ein Mensch ihren Einspruch anhört oder ihren Fall prüft, schafft Vertrauen, dass wir nicht gefühllosen Maschinen ausgeliefert sind.

Datenschutzwahrende KI: Best Practices für sichere KI-Systeme

KI-Systeme benötigen oft Daten – doch die Wahrung der Privatsphäre bei gleichzeitiger Nutzung von Daten ist ein kritischer Balanceakt. Datenschutzwahrende KI geht es um Techniken und Praktiken, die KI-Erkenntnisse ermöglichen, ohne persönliche oder sensible Informationen zu gefährden. Eine grundlegende Praxis ist Datenminimierung: Sammeln und verwenden Sie nur die Daten, die für den Zweck der KI wirklich benötigt werden. Wenn ein KI-Modell sein Ziel ohne bestimmte personenbezogene Identifikatoren erreichen kann, sollten Sie diese nicht verwenden. Techniken wie Anonymisierung oder Pseudonymisierung kann hilfreich sein – beispielsweise können Sie vor der Analyse von Daten zum Kundenverhalten Namen entfernen oder durch zufällige IDs ersetzen.

Eine echte Anonymisierung kann jedoch schwierig sein (KI kann manchmal Muster wiedererkennen), sodass robustere Ansätze an Bedeutung gewinnen, wie zum Beispiel Föderiertes Lernen Und Differenzielle PrivatsphäreFederated Learning ermöglicht das Trainieren von KI-Modellen über mehrere Datenquellen hinweg, ohne dass die Daten ihre Quelle jemals verlassen. So kann beispielsweise eine KI für die Smartphone-Tastatur, die aus den Tippmustern der Benutzer lernt, ein globales Modell aktualisieren, ohne einzelne Tastenanschläge hochzuladen, wodurch persönliche Daten auf dem Gerät verbleiben.

Differential Privacy fügt Daten oder Abfrageergebnissen sorgfältig kalibriertes Rauschen hinzu, sodass KI aggregierte Muster erlernen kann, jedoch keine eindeutigen Rückschlüsse auf einzelne Personen zulässt. Unternehmen wie Apple und Google setzen Differential Privacy in der Praxis ein, um Nutzungsstatistiken zu sammeln, ohne die Nutzer zu identifizieren. Unternehmen, die mit sensiblen Daten (Gesundheit, Finanzen, Standort usw.) arbeiten, sollten diese Techniken nutzen, um das Vertrauen ihrer Kunden zu wahren und Datenschutzgesetze einzuhalten. Verschlüsselung ist ein weiteres Muss: sowohl bei der Speicherung (Verschlüsselung ruhender Daten) als auch bei der Übertragung.

Darüber hinaus berücksichtigen Zugriffskontrollen Bei KI-Modellen kann es vorkommen, dass das Modell selbst unbeabsichtigt Daten verliert (beispielsweise kann ein Sprachmodell Teile seines Trainingstextes wiedergeben). Beschränken Sie den Personenkreis, der sensible Modelle abfragen und die Ergebnisse überwachen kann. Richten Sie Ihre KI-Projekte auf organisatorischer Ebene bereits in der Konzeptionsphase an die Datenschutzbestimmungen (DSGVO, CCPA usw.) aus und führen Sie Datenschutz-Folgenabschätzungen für neue KI-Systeme durch.

Seien Sie gegenüber Nutzern transparent hinsichtlich der Datennutzung: Holen Sie gegebenenfalls eine Einwilligung ein und bieten Sie Opt-out-Möglichkeiten für diejenigen an, die ihre Daten nicht für das KI-Training verwenden möchten. Indem Unternehmen den Datenschutz in die KI-Entwicklung integrieren, schützen sie die Rechte der Nutzer und vermeiden Missgeschicke wie Datenlecks oder Missbrauchsskandale. Dies ist eine Investition in die langfristige Datensicherheit – wenn die Nutzer darauf vertrauen, dass ihre Daten ethisch korrekt behandelt werden, stimmen sie deren Verwendung eher zu und fördern so die KI-Innovation in einem positiven Kreislauf.

Ethisches KI-Auditing: Kontinuierliche Überwachung und Compliance-Strategien

So wie Finanzprozesse geprüft werden, profitieren KI-Systeme von Ethik- und Compliance-Audits. Ein Ethisches KI-Audit beinhaltet die systematische Überprüfung eines KI-Systems auf die Einhaltung bestimmter Standards oder Prinzipien (Fairness, Genauigkeit, Datenschutz usw.) sowohl vor der Einführung als auch regelmäßig danach. Unternehmen sollten eine KI-Auditfunktion einrichten – entweder ein internes Komitee oder externe Prüfer (oder beides) – um wichtige KI-Systeme zu bewerten. Beispielsweise könnte eine Bank, die KI für Kreditentscheidungen einsetzt, ein Prüfteam prüfen lassen, ob das Modell alle regulatorischen Anforderungen (wie den US-amerikanischen ECOA für Kreditvergabegerechtigkeit) und ethischen Maßstäbe erfüllt, und einen Bericht mit den Ergebnissen und Empfehlungen erstellen.

Zu den wichtigsten zu prüfenden Elementen gehören: Bias-Metriken (Sind die Ergebnisse gerecht?), Fehlerraten und Leistung (insbesondere bei sicherheitskritischen Systemen – liegen sie im akzeptablen Bereich?), Erklärbarkeit (Können die Entscheidungen interpretiert und begründet werden?), Datenherkunft (Werden die Trainingsdaten ordnungsgemäß bezogen und verwendet?) und Sicherheit (Ist das Modell anfällig für feindliche Angriffe oder Datenlecks?).

Audits können auch den Entwicklungsprozess überprüfen – gab es ausreichende Dokumentation? Wurden vor der Markteinführung die erforderlichen Genehmigungen und Tests durchgeführt? Einige Organisationen übernehmen Checklisten aus Frameworks wie dem IEEE 7000-Reihe oder die NIST-Rahmenwerk für KI-Risikomanagement als grundlegende Auditkriterien. Es ist ratsam, multidisziplinäre Experten in Audits einzubeziehen: Datenwissenschaftler, Rechtsexperten, Compliance-Beauftragte, Ethiker und Fachexperten.

Nach einem Audit sollte ein Plan zur Behebung etwaiger Warnsignale vorliegen – beispielsweise durch die Neuschulung eines Modells, die Verbesserung der Dokumentation oder sogar die Stilllegung eines KI-Tools bis zur Behebung der Probleme. Darüber hinaus sollte die Überwachung kontinuierlich erfolgen: Richten Sie Dashboards oder automatisierte Tests für ethische Kennzahlen ein (z. B. eine Warnung, wenn die demografische Zusammensetzung der Kreditgenehmigungen von den erwarteten Normen abweicht, was auf eine mögliche Voreingenommenheit hindeutet). Angesichts künftiger Regulierungen trägt die Pflege von Prüfpfaden auch dazu bei, die Einhaltung der Vorschriften gegenüber den Behörden nachzuweisen.

Über formelle Audits hinaus können Unternehmen Whistleblowing und Feedback Schleifen – ermöglichen Sie Mitarbeitern und sogar Nutzern, KI-bezogene Bedenken ohne Bedenken zu melden und diese umgehend zu untersuchen. Kurz gesagt: Behandeln Sie ethische KI-Governance als fortlaufenden Prozess, nicht als einmaliges Kontrollkästchen. Durch regelmäßige Audits und strenge Aufsicht können Unternehmen Probleme frühzeitig erkennen, sich an neue ethische Standards anpassen und sicherstellen, dass ihre KI-Systeme langfristig vertrauenswürdig bleiben.

Um tiefer in die Umsetzung ethischer Prinzipien bei der KI-Entwicklung einzutauchen, lesen Sie unseren umfassenden Leitfaden zu ethische KI-Entwicklung.

Die Zukunft der KI-Ethik: Neue Bedenken und Lösungen

KI ist ein sich schnell entwickelndes Feld und mit ihr kommen neue ethische Grenzen die Unternehmen und politische Entscheidungsträger meistern müssen.Mit Blick auf die Zukunft sind hier einige aufkommende ethische Bedenken hinsichtlich der KI und mögliche Lösungen aufgeführt:

KI ist ein sich schnell entwickelndes Feld und mit ihr kommen neue ethische Grenzen die Unternehmen und politische Entscheidungsträger meistern müssen.Mit Blick auf die Zukunft sind hier einige aufkommende ethische Bedenken hinsichtlich der KI und mögliche Lösungen aufgeführt:

KI in der Kriegsführung: Autonome Waffen und militärische KI-Ethik

Der Einsatz von KI in militärischen Anwendungen – von autonomen Drohnen bis hin zu KI-gesteuerten Cyberwaffen – löst weltweit Alarm aus. Autonome Waffen, oft als „Killerroboter“ bezeichnet, könnten ohne menschliches Eingreifen über Leben und Tod entscheiden. Die ethischen Fragen sind dabei tiefgreifend: Kann eine Maschine das humanitäre Völkerrecht zuverlässig einhalten? Wer haftet, wenn eine KI ein Ziel falsch identifiziert und Zivilisten tötet?

Es gibt eine wachsende Bewegung, darunter Technologieführer und Robotiker, die ein Verbot tödlicher autonomer Waffen fordert. Sogar der Generalsekretär der Vereinten Nationen drängte auf ein Verbot und warnte, dass Maschinen, die Menschen autonom töten können, verboten werden sollten.Einige Länder streben Verträge zur Kontrolle dieser Technologie an. Für Unternehmen, die im Rüstungsbereich tätig sind, sind diese Debatten von entscheidender Bedeutung.

Unternehmen müssen entscheiden, ob und wie sie sich an der Entwicklung von KI für den Kampfeinsatz beteiligen. Einige haben sich aus ethischen Gründen dagegen entschieden (Google zog sich beispielsweise nach Mitarbeiterprotesten aus einem KI-Projekt im Pentagon zurück). Bei der Entwicklung militärischer KI ist die Verankerung strenger Beschränkungen (wie etwa die Einbindung des Menschen vor einem Angriff – „Human-in-the-Loop“ bei tödlichen Aktionen) ein ethisches Muss.

Es besteht zudem die Gefahr eines KI-Wettrüstens, bei dem sich die Nationen gezwungen sehen, ihre autonomen Arsenale zu erweitern, was die Konfliktschwelle senken könnte. Ein hoffnungsvoller Weg nach vorn ist eine internationale Regulierung: Ähnlich wie bei chemischen und biologischen Waffen plädieren viele für die Regulierung von KI-Waffen. vor sie vermehren sich.

Die Angst vor KI in der Kriegsführung erinnert uns daran, dass es bei der KI-Ethik nicht nur um Fairness in Werbung oder Krediten geht – es kann auch um das Grundrecht auf Leben und die Regeln des Krieges gehen. Technologieunternehmen, Ethiker und Regierungen müssen zusammenarbeiten, um sicherzustellen, dass der Einsatz von KI in der Kriegsführung, sollte er fortgesetzt werden, streng an menschlichen Werten und globalen Vereinbarungen ausgerichtet ist.

Der Aufstieg der künstlichen allgemeinen Intelligenz (AGI) und existenzielle Risiken

Der Großteil der KI, über die wir heute sprechen, ist „schmale KI“, die sich auf spezifische Aufgaben konzentriert. Doch mit Blick auf die Zukunft denken viele darüber nach Künstliche allgemeine Intelligenz (AGI) – KI, die die menschlichen kognitiven Fähigkeiten in einem breiten Aufgabenspektrum erreichen oder übertreffen könnte. Einige Experten schätzen, dass AGI innerhalb weniger Jahrzehnte entwickelt werden könnte, was die existenzielle Risiken und ethische Fragen einer anderen Größenordnung.

Wenn eine KI deutlich intelligenter wäre als der Mensch (oft als Superintelligenz bezeichnet), könnten wir dann sicherstellen, dass sie mit menschlichen Werten und Zielen im Einklang bleibt? Visionäre wie Stephen Hawking und Elon Musk haben gewarnt, dass unkontrollierte superintelligente KI sogar eine existenzielle Bedrohung für die Menschheit darstellen könnte. Im Jahr 2023 unterzeichneten zahlreiche KI-Wissenschaftler und CEOs eine öffentliche Erklärung, in der sie warnten, dass KI bei Missmanagement möglicherweise zum Aussterben der Menschheit führen könnte, und forderten weltweite Priorität bei der Eindämmung dieses Risikos.. Diese Sorge, die einst als Science-Fiction galt, ist zunehmend Teil ernsthafter politischer Diskussionen.

Wie planen wir ethisch für eine zukünftige Technologie, die unser Verständnis übersteigen könnte? Ein Lösungsansatz ist KI-Ausrichtungsforschung – ein Bereich, der sich dafür einsetzt, dass fortschrittliche KI-Systeme nützliche Ziele verfolgen und sich nicht unerwartet und gefährlich verhalten. Ein weiterer Aspekt ist die Governance: Die Vorschläge reichen von der internationalen Überwachung von AGI-Projekten über Verträge, die die Entwicklung ab einer bestimmten Leistungsschwelle verlangsamen, bis hin zur Forderung, dass AGIs unter Sicherheitsvorkehrungen und gegebenenfalls unter offener Kontrolle entwickelt werden müssen.