1. Einführung in KI-Agenten

KI-Agenten sind keine futuristischen Konzepte mehr – sie sind bereits da und verändern unsere Arbeits-, Lebens- und Entscheidungsfindung. Von der Automatisierung des Kundenservice bis hin zur Verwaltung komplexer Geschäftsabläufe verändern KI-Agenten die Rolle der Technologie vom passiven Werkzeug zum proaktiven Problemlöser.

In diesem Abschnitt erfahren Sie:

Was KI-Agenten wirklich sind – in einfachen, praktischen Worten.

Warum sie wichtig sind – und wie sie Einzelpersonen und Unternehmen helfen, mit weniger mehr zu erreichen.

Wo sie bereits Wirkung zeigen – durch reale Anwendungsfälle in verschiedenen Branchen.

Wie sie sich entwickelt haben – von einfachen, regelbefolgenden Bots bis hin zu intelligenten, autonomen Systemen.

Egal, ob Sie gerade erst anfangen oder Ihr Verständnis vertiefen möchten, dieser Abschnitt vermittelt Ihnen das notwendige Wissen, um zu erkennen, wo KI-Agenten ins Gesamtbild passen – und wie Sie sie zu Ihrem Vorteil nutzen können.

Was ist ein KI-Agent?

Künstliche Intelligenz (KI) Agenten sind Software-Einheiten, die ihre Umgebung wahrnehmen, Entscheidungen treffen und autonom handeln können, um bestimmte Ziele zu erreichen. Einfacher ausgedrückt: Ein KI-Agent dient als digitaler "Agent" in Ihrem Namen, verarbeitet Informationen und führt Aufgaben ohne ständige menschliche Anleitung aus.

Für Geschäftsinhaber stellen KI-Agenten eine transformative Technologie dar, die komplexe Prozesse automatisieren, Kundeninteraktionen verbessern und die Entscheidungsfindung mit datengesteuerten Erkenntnissen vorantreiben kann.

Mehr lesen: KI-Modelle vs. KI-Agenten verstehen

Warum sind KI-Agenten wichtig? Reale Fälle in der heutigen Welt

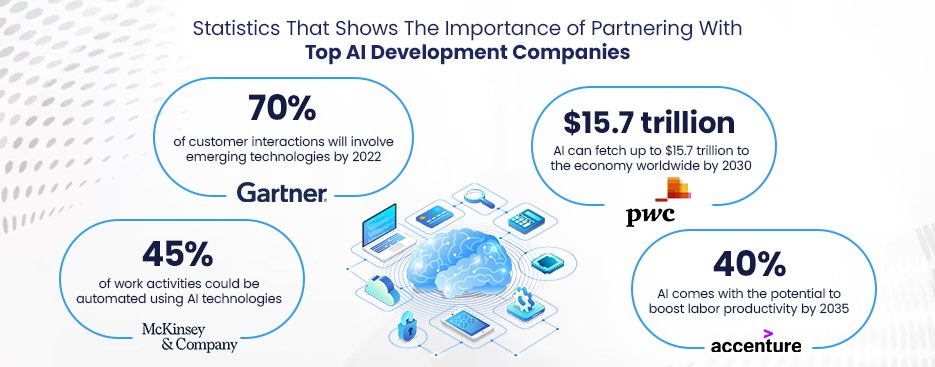

Die Bedeutung von KI-Agenten für Unternehmen kann heute nicht hoch genug eingeschätzt werden. Im Kundenservice beispielsweise bearbeiten KI-Agenten (wie intelligente Chatbots) einen wachsenden Anteil der Anfragen und bieten rund um die Uhr sofortigen Support. Tatsächlich Gartner Prognosen gehen davon aus, dass bis 2025 etwa 70% der Kundeninteraktionen durch KI-Technologien verwaltet werden. Dies unterstreicht, wie allgegenwärtig und wichtig diese Agenten für die Bereitstellung eines effizienten Kundenerlebnisses geworden sind.

Reale Anwendungen von KI-Agenten Branchenübergreifend: E-Commerce-Giganten setzen KI-Agenten für personalisierte Empfehlungen ein (die laut McKinsey)Banken nutzen KI-Handelsagenten für algorithmischen Handel und Betrugserkennung und Krankenhäuser setzen KI-Agenten zur Unterstützung bei der Diagnostik und Patiententriage ein.

Diese Beispiele verdeutlichen die Entwicklung von frühen regelbasierten Systemen hin zu den heutigen autonomen, lernenden Agenten. Mit der Weiterentwicklung der Technologie sind wir von statischen, regelbasierten Programmen zu adaptiven Agenten übergegangen, die sich mit der Zeit verbessern können und somit zu einem unverzichtbaren Bestandteil moderner Geschäftsmodelle geworden sind.

Entwicklung von KI-Agenten: Von regelbasiert zu autonom

Aus SmartDevs Sicht haben wir diese Entwicklung hautnah miterlebt. Als wir vor Jahren mit der Entwicklung von KI-Lösungen begannen, bestanden viele Geschäftsautomatisierungssysteme im Wesentlichen aus fest programmierten Entscheidungsbäumen. Sie konnten zwar vorhersehbare Szenarien bewältigen, versagten aber bei Nuancen.

Heute befolgen unsere KI-Agenten nicht nur Anweisungen, sondern können auch den Kontext verstehen, sich an neue Informationen anpassen und mit einem Grad an Autonomie agieren, der vor nur einem Jahrzehnt noch Science-Fiction war.

In den folgenden Abschnitten teilen wir unsere Branchenkenntnisse und Erfahrungen bei SmartDev mit Ihnen, wie Sie einen KI-Agenten erstellen, der diese Funktionen in Ihr Unternehmen bringen kann.

2. Die Komponenten eines KI-Agenten verstehen

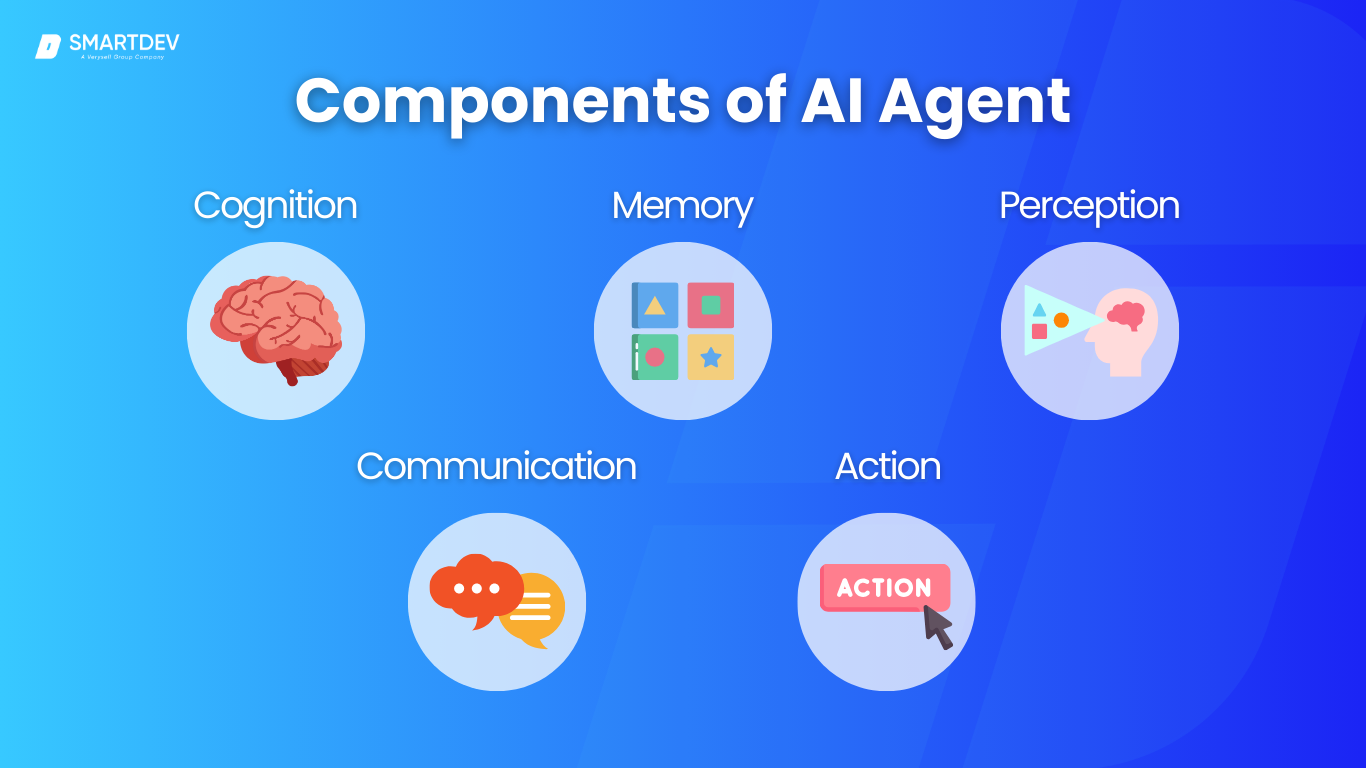

Um einen robusten KI-Agenten zu entwickeln, ist es wichtig, seine Kernkomponenten zu verstehen – im Wesentlichen den Verstand und die Sinne des Agenten. Jede dieser Komponenten spielt eine besondere Rolle für die Funktionsweise des Agenten:

2.1. Kognition – Wie KI denkt

Dies ist das „Gehirn“ des KI-Agenten. Kognition beschreibt, wie der Agent denkt, Daten analysiert und Entscheidungen trifft. Sie umfasst die Algorithmen oder Modelle, die Schlussfolgerungen ermöglichen, beispielsweise die Entscheidung über die beste Vorgehensweise zur Erreichung eines Ziels.

Beispielsweise könnte ein KI-Agent mithilfe eines Planungsalgorithmus die optimale Lieferroute für ein Logistikunternehmen ermitteln oder ein maschinelles Lernmodell einsetzen, um zu entscheiden, ob eine Transaktion betrügerisch ist.

Kognitive Prozesse beinhalten häufig die Bewertung von Optionen (mithilfe von Logik oder erlernten Mustern) und die Auswahl von Aktionen, die den Erfolg entsprechend den Zielen des Agenten maximieren (dies könnte eine Nutzenfunktion, ein Belohnungssignal beim bestärkenden Lernen usw. sein).

2.2. Gedächtnis – Wie sich KI erinnert

Das Gedächtnis ist die Art und Weise, wie sich der Agent Informationen merkt und speichert. So wie Menschen über ein Kurzzeit- und Langzeitgedächtnis verfügen, verfügen KI-Agenten über schnelle Caches und langfristige Wissensbasen. Das Gedächtnis kann eine Datenbank mit Fakten, ein Vektorspeicher mit eingebettetem Wissen oder ein beliebiges Repository sein, das der Agent abfragen kann.

Beispielsweise könnte ein KI-Agent im Kundensupport auf eine Wissensdatenbank mit FAQs und früheren Interaktionen zurückgreifen, auf die er bei der Beantwortung einer Frage zurückgreifen kann. Das Gedächtnis ist entscheidend, um den Kontext langfristig zu bewahren – wenn ein Nutzer einem Chatbot seinen Namen oder seine Präferenzen mitteilt, kann der Agent diese Informationen später im Gespräch dank seines Gedächtnisses abrufen.

2.3. Wahrnehmung – Wie KI Daten sammelt

Perzeption ist die Art und Weise, wie der KI-Agent Daten aus seiner Umgebung sammelt. Je nach Rolle können die „Sensoren“ eines Agenten physisch (Kameras, Mikrofone, IoT-Sensoren) oder virtuell (APIs, Echtzeit-Datenfeeds, Benutzereingaben) sein.

Beispielsweise könnte ein KI-Sicherheitsagent Video-Feeds und Netzwerkprotokolle nutzen, um Anomalien zu erkennen, während ein Einkaufsassistent Benutzeranfragen und das Surfverhalten als Eingaben wahrnimmt. Diese Eingabephase entspricht den menschlichen Sinnen – es sind die Rohinformationen, die in die Wahrnehmung des Agenten einfließen.

Eine hochwertige Wahrnehmung ist unerlässlich. Wenn Ihr Agent seine Eingaben nicht genau versteht, sind seine Entscheidungen fehlerhaft. Moderne KI-Agenten integrieren häufig Technologien wie Computer Vision für die Bild-/Videowahrnehmung, Natural Language Processing (NLP) für die Text-/Audiowahrnehmung und andere Sensorintegrationen, um das Geschehen umfassend zu erfassen.

2.4. Kommunikation – Wie KI interagiert

Kommunikation bezeichnet die Art und Weise, wie der Agent mit Benutzern oder anderen Systemen interagiert und kommuniziert. Für viele Geschäftsanwendungen bedeutet dies, die menschliche Sprache zu verstehen und entsprechend zu reagieren. Durch Natural Language Processing kann ein KI-Agent Benutzerfragen oder -befehle analysieren und anschließend eine entsprechende Antwort generieren.

Die Kommunikation kann auch strukturierte Nachrichten beinhalten, beispielsweise wenn ein Agent die API einer anderen Software aufruft und die Antwort interpretiert. Da viele KI-Agenten jedoch als Front-Line-Schnittstellen für Benutzer dienen, sind starke NLP-Fähigkeiten oft entscheidend.

Bei SmartDev stellen wir sicher, dass unsere Agenten mit fortschrittlichen Sprachmodellen oder Dialogmanagementsystemen ausgestattet sind, damit sie Anfragen nicht nur verstehen, sondern auch klar und hilfreich beantworten können. Ob per Textchat, E-Mail oder Telefon – das Kommunikationsmodul eines KI-Agenten ist das Gesicht (oder die Stimme), das er der Welt präsentiert.

2.5. Aktion – Wie KI agiert

Schließlich beschreibt die Aktion, wie der KI-Agent auf Entscheidungen reagiert. Sobald das Kognitionsmodul eine Entscheidung getroffen hat, führt die Aktionsfunktion diese aus. Dies kann beispielsweise die Durchführung einer Transaktion, die Aktualisierung eines Datenbankeintrags, den Aufruf einer externen API oder sogar die Steuerung eines physischen Geräts sein.

Wenn beispielsweise ein Smart-Factory-Agent eine Maschinenanomalie erkennt (Wahrnehmung) und entscheidet, dass diese kritisch ist (Kognition), kann die Aktionskomponente eine Notabschaltung oder einen Alarm auslösen.

Im Wesentlichen besteht die Aktionskomponente aus den „Effektoren“ des Agenten – analog zur Bewegung der Arme eines Roboters nutzt ein KI-Software-Agent seine Integrations-Hooks, um Veränderungen zu bewirken. Effektive KI-Agenten lassen sich oft in verschiedene Systeme integrieren: Sie verfügen beispielsweise über API-Anschlüsse zu Unternehmenssoftware (CRM-, ERP-Systeme), können E-Mails oder Benachrichtigungen versenden oder sogar IoT-Geräte steuern.

Unserer Erfahrung nach sind die besten KI-Agenten diejenigen, die ganzheitlich unter Berücksichtigung aller fünf Funktionalitäten entwickelt wurden, um sicherzustellen, dass sie in Harmonie wahrnehmen, denken, kommunizieren, sich erinnern und handeln können.

3. Arten von KI-Agenten und ihre Anwendungsfälle

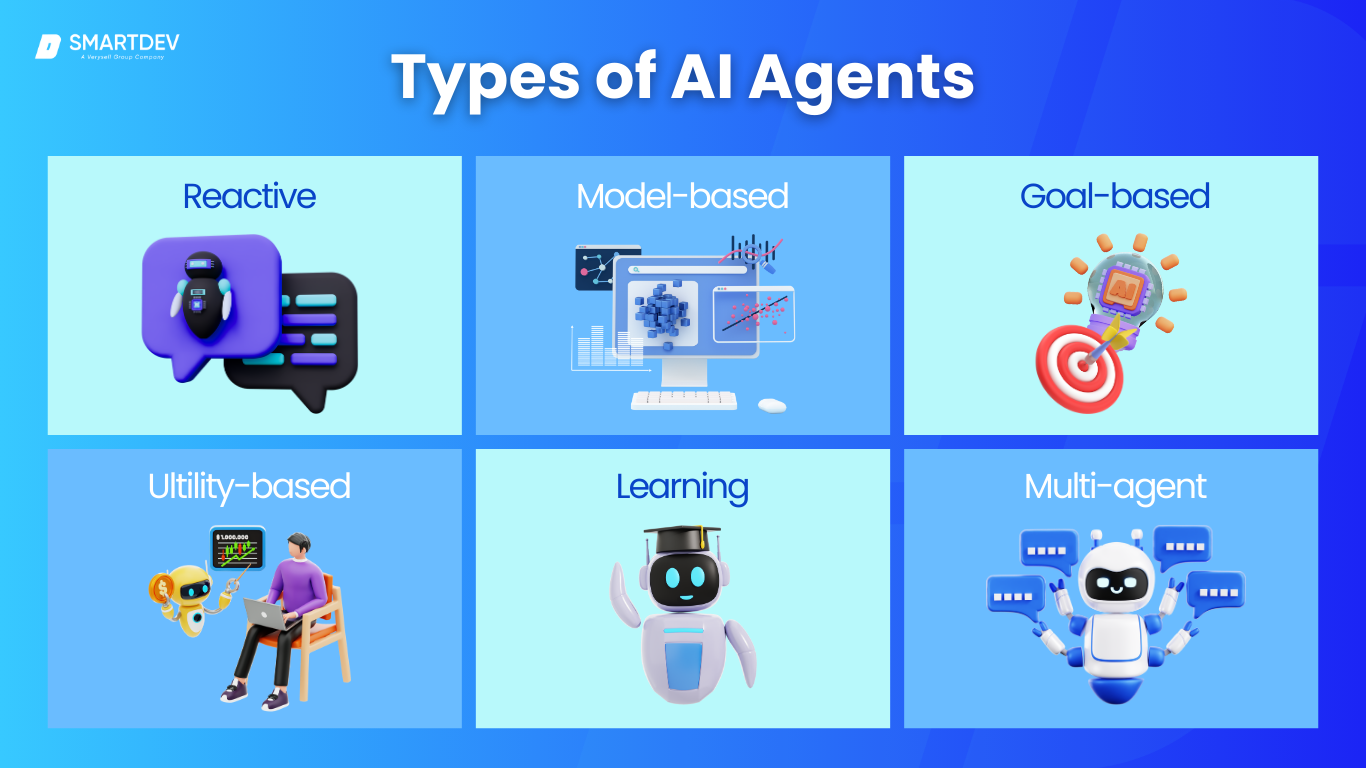

Nicht alle KI-Agenten sind gleich – tatsächlich gibt es verschiedene Arten von KI-Agenten mit jeweils unterschiedlichem Entwicklungsstand und idealen Anwendungsfällen. In der klassischen KI-Theorie (wie sie in Russell & Norvigs KI beschrieben wird) werden Agenten häufig nach ihrer internen Architektur und ihrem Verhalten kategorisiert.

3.1. Reaktive Substanzen

Reaktive Agenten arbeiten auf Reiz-Reaktions-Basis, ohne auf das interne Gedächtnis vergangener Zustände zurückzugreifen. Sie nehmen eine Eingabe wahr und reagieren sofort nach festgelegten Regeln oder erlernten Reaktionen. Diese Agenten sind die einfachste Form von KI-Agenten – man kann sie sich wie einen Thermostat vorstellen, der die Heizung einschaltet, wenn die Temperatur unter einen bestimmten Grenzwert fällt. In der Wirtschaft könnten rein reaktive Agenten einfache Chatbots sein, die nach vordefinierten Regeln FAQs beantworten oder Anfragen weiterleiten.

Anwendungsfall: Im Kundensupport könnte ein reaktiver Agent häufige Fragen (Öffnungszeiten, Bestellstatus) sofort beantworten und menschliche Mitarbeiter von Routineaufgaben entlasten. In der Fertigung könnte eine reaktive KI eine Maschine steuern: Erkennt ein Sensor eine Überhitzung, schaltet der Agent die Maschine sofort ab – ohne Gedächtnis oder lange Planung, nur durch eine sofortige Reaktion auf den Zustand.

3.2. Modellbasierte Agenten

Modellbasierte Agenten sind ein Schritt in Richtung Intelligenz: Sie behalten einen internen Zustand oder ein Modell der Welt bei, das über die unmittelbaren Eingaben hinausgeht. Das heißt, sie berücksichtigen die Entwicklung der Welt oder erinnern sich an vergangene Eingaben, um aktuelle Entscheidungen zu treffen. Das „Modell“ kann so einfach sein wie „der letzte bekannte Standort eines Objekts“ oder so komplex wie eine interne Simulation der Umgebung.

Ein Roboterstaubsauger ist beispielsweise ein modellbasierter Agent, wenn er sich merkt, welche Bereiche eines Raums er gereinigt hat (Speicherung früherer Aktionen), um zu entscheiden, wohin er als Nächstes gehen soll.

Anwendungsfall: Im Finanzwesen könnte ein modellbasierter Handelsagent einen Status aufrechterhalten, der Markttrends oder seine eigenen Portfoliobestände repräsentiert, um über Handelsgeschäfte zu entscheiden (er reagiert nicht nur auf den aktuellen Preis, sondern merkt sich auch historische Trends). Im Gesundheitswesen könnte ein KI-Diagnoseassistent die Symptome von Patienten im Laufe der Zeit verfolgen – anstatt nur auf das neueste Testergebnis zu reagieren, vergleicht er es mit früheren Ergebnissen, um Veränderungen oder Muster zu erkennen.

3.3. Zielbasierte Agenten

Zielbasierte Agenten orientieren sich an Zielen. Sie überlegen nicht nur: „Wie ist der Zustand?“, sondern auch: „Was will ich erreichen?“ und planen dann Aktionen, um dieses Ziel zu erreichen. Dabei kommen häufig Such- und Planungsalgorithmen zum Einsatz: Der Agent wertet mögliche Aktionssequenzen anhand seines Ziels aus und wählt einen Weg, der ihn dem Zielzustand näher bringt. Dieser Agententyp kann komplexere Entscheidungsräume bewältigen, indem er sich auf das Endergebnis konzentriert.

Anwendungsfall: Im E-Commerce oder Marketing könnte ein zielorientierter Agent die Aufgabe haben, das Engagement der Nutzer zu steigern. Er könnte eine Reihe personalisierter Angebote oder Nachrichten planen, um dieses Ziel für jedes Kundensegment zu erreichen. Im Projektmanagement könnte ein KI-Agent die Aufgabe erhalten, die Teamplanung zu optimieren und anschließend verschiedene Aufgabenkombinationen zu bewerten, um Termine einzuhalten.

3.4. Nutzenbasierte Agenten

Nutzenbasierte Agenten erweitern zielbasierte Agenten durch die Einführung des Konzepts von OptimierungAnstatt einfach ein Ziel auf irgendeine Weise zu erreichen, denken sie darüber nach mehrere mögliche Ergebnisse und bewerten Sie, welches Ergebnis am bevorzugt (hat den höchsten Nutzen). Sie haben eine Nutzenfunktion – ein Maß für die Zufriedenheit –, die sie zu maximieren versuchen. Dies ermöglicht ihnen, Kompromisse einzugehen.

Anwendungsfall: Stellen Sie sich im Finanzwesen einen KI-Agenten für Investitionen vor, der nicht nur das Ziel „Renditemaximierung“ verfolgt, sondern auch die Risikotoleranz als Nutzenfaktor berücksichtigt. Er strebt die besten risikoadjustierten Renditen an und optimiert so effektiv eine Nutzenfunktion, die Gewinn und Risiko ins Gleichgewicht bringt. Diese Agenten eignen sich hervorragend für komplexe Entscheidungen, bei denen es kein klares Ziel gibt, sondern die Qualität der Ergebnisse bewertet werden muss.

3.5. Lernende Agenten

Lernende Agenten sind darauf ausgelegt, ihre Leistung mit der Zeit zu verbessern. Sie verfügen über Komponenten, die aus Erfahrung lernen. Ein lernender Agent verfügt typischerweise über ein Leistungselement und ein Lernelement. Fast jeder der oben genannten Agententypen kann um Lernfähigkeiten erweitert werden – beispielsweise ein lernreaktiver Agent, der seine Reflexregeln basierend auf Feedback anpasst, oder ein lernzielbasierter Agent, der mit zunehmender Erfahrung von Szenarien seine Planung verbessert.

Anwendungsfall: Im Gesundheitswesen könnte ein lernender Agent seine Diagnosevorschläge verbessern, da er mehr Patientendaten und Feedback von Ärzten erhält, die aus Fällen lernen, in denen seine Vorschläge richtig oder falsch waren. Im E-Commerce-Umfeld könnte ein lernender Agent seine Produktempfehlungen mit der Zeit verfeinern, indem er aus den Klicks und Käufen jedes Kunden lernt und so personalisierter und präziser wird. Der Hauptvorteil liegt hier in der Anpassungsfähigkeit – lernende Agenten können mit Basiswissen beginnen und mit zunehmender Datenmenge effektiver werden.

3.6. Multi-Agenten-Systeme

Manchmal reicht ein Agent für ein komplexes Problem nicht aus. Hier kommen Multi-Agenten-Systeme ins Spiel. In einem Multi-Agenten-System arbeiten mehrere KI-Agenten in einer Umgebung zusammen oder konkurrieren miteinander. Jeder Agent hat möglicherweise eine eigene Rolle oder Spezialisierung, und gemeinsam erledigen sie Aufgaben durch Interaktion. Dies ist vergleichbar mit einem Team von Mitarbeitern: Jedes Mitglied (Agent) hat bestimmte Aufgaben, aber alle arbeiten koordiniert zusammen, um ein Gesamtziel zu erreichen. Multi-Agenten-Systeme sind besonders leistungsstark bei der Simulation komplexer Umgebungen oder bei der Optimierung im großen Maßstab.

Anwendungsfall: In der Fertigung oder Logistik können Multiagentensysteme verschiedene Teile eines Arbeitsablaufs verwalten – ein Agent plant die Produktion, ein anderer verwaltet die Bestellungen in der Lieferkette und ein weiterer kümmert sich um die Lieferrouten. Alle kommunizieren miteinander, um einen reibungslosen Ablauf zu gewährleisten.

Bei SmartDev haben wir Multi-Agenten-Architekturen erforscht, bei denen beispielsweise ein ausführender Agent Teilaufgaben an andere Sub-Agenten delegieren kann (ein Konzept, das wir in einem späteren Abschnitt mit AutoGPT erneut betrachten werden). Dieser Ansatz ahmt das Verhalten von Organisationen nach und kann durch „Dividieren und Erobern“ Probleme lösen, die für einen einzelnen Agenten zu umfangreich sind.

4. Auswahl des richtigen Technologie-Stacks

Wenn Sie eine klare Vorstellung davon haben, was Ihr KI-Agent tun soll, müssen Sie im nächsten Schritt entscheiden, wie er erstellt werden soll. Das bedeutet Auswahl des richtigen Technologie-Stacks.

Lassen Sie uns dies entmystifizieren, indem wir es in die Hauptkomponenten des Stapels aufschlüsseln und die Optionen für jede Komponente sowie die Gründe für die Auswahl dieser Komponenten besprechen.

| Komponente | Optionen | Wichtige Überlegungen |

| Programmiersprachen |

| Python für KI/ML, JavaScript für Web-KI. C++/Rust für Geschwindigkeit. R für datenintensive Aufgaben. |

| KI-Frameworks und -Bibliotheken |

| TensorFlow/PyTorch zum Training. LangChain für LLM-Agenten. OpenAI-API für schnelle KI-Integration. |

| LLMs & NLP-Modelle |

| GPT-4/Claude für allgemeine KI. Llama 2/Mistral für selbstgehostete, private KI |

| Datenbanken |

| Vektor-DBs für die KI-Suche. SQL für Transaktionen. Graphendatenbanken für komplexe Zusammenhänge. |

| APIs und Tools für die Bereitstellung |

| OpenAI/Azure für die schnelle LLM-Nutzung. Umarmungsgesicht für benutzerdefinierte Modelle. Cloud-KI für Unternehmens-KI. |

| Infrastruktur & Hosting |

| Cloud für Skalierung. Vor Ort für Sicherheit. Serverlos für Microservices. Edge für IoT/KI mit geringer Latenz. |

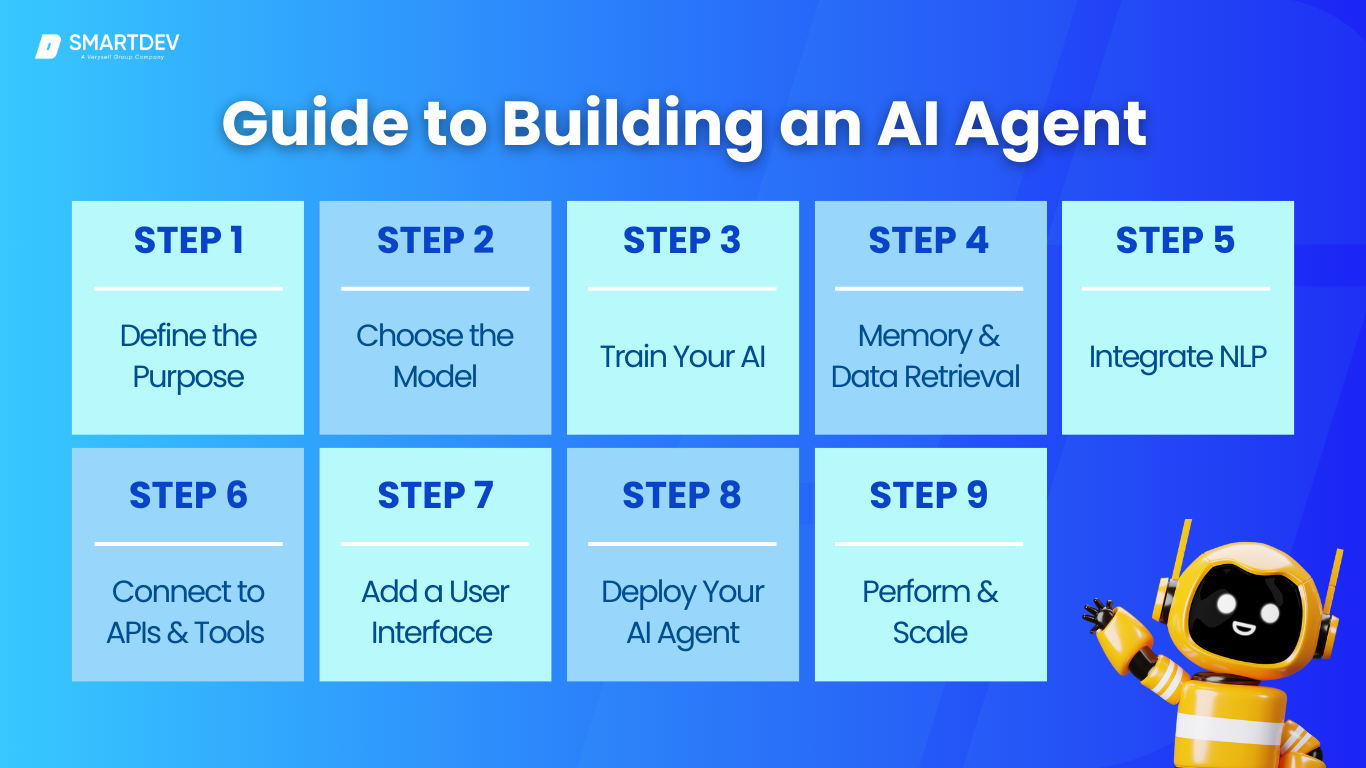

5. Schritt-für-Schritt-Anleitung zum Erstellen eines KI-Agenten

Hier ist eine Schritt-für-Schritt-Anleitung aus unserem SmartDev-Playbook, die Sie von der Idee bis zum einsatzbereiten KI-Agenten begleitet. Diese Anleitung ist allgemein gehalten (kein Code zum Verständnis erforderlich) und richtet sich an Geschäftsinhaber, die mit Entwicklungsteams zusammenarbeiten.

Schritt 1: Definieren Sie den Zweck Ihres KI-Agenten

Jedes erfolgreiche Projekt beginnt mit einem klaren Ziel. Definieren Sie zunächst, welches Problem oder welche Chance der KI-Agent in Ihrem Unternehmen angehen soll.

- Sollen Kundendienstanfragen automatisiert werden?

- Als virtueller Verkaufsassistent fungieren?

- Um große Datensätze zu analysieren und Berichte zu erstellen?

- …oder usw.

Die Definition eines konkreten Anwendungsfalls und der Ziele dient als Orientierung für alle nachfolgenden Entscheidungen. Beziehen Sie in dieser Phase alle Beteiligten (z. B. den Kundensupport-Manager, wenn es sich um einen Support-Mitarbeiter handelt, oder die IT-Abteilung, wenn es um interne Automatisierung geht) ein, um die Anforderungen zu skizzieren.

Wichtige Fragen zur Beantwortung:

- Welche Aufgaben soll der Agent erfüllen?

- Wer wird damit interagieren?

- Was sind die Erfolgskennzahlen (z. B. Reduzierung der Antwortzeit um 50%, Bearbeitung von 1000 Abfragen/Tag usw.)?

Durch eine klare Definition des Zwecks stellen Sie sicher, dass Sie und Ihr Entwicklungsteam eine einheitliche Vision haben.

SmartDev arbeitete beispielsweise einmal mit einem Gesundheitsunternehmen zusammen, um einen KI-Agenten für die Terminplanung von Patienten zu entwickeln. Der Zweck war eng definiert als „Automatisierung routinemäßiger Terminplanungsanrufe und Freisetzung von Personalzeit“. Mit dieser Klarheit wussten wir genau, welche Funktionen der Agent benötigte. Notieren Sie den Zweck und den erwarteten Nutzen – dies wird Ihnen als Nordstern dienen.

Schritt 2: Wählen Sie das richtige Modell

Entscheiden Sie sich unter Berücksichtigung des Zwecks für die Gehirn des Agenten. Es gibt einige Ansätze:

Großes Sprachmodell (LLM)

Sie könnten einen vorab trainierten Großes Sprachmodell (LLM) wenn Ihr Agent ein ausgeprägtes Sprachverständnis oder allgemeine Intelligenz benötigt. Für einen Konversationsagenten kann beispielsweise ein Modell wie GPT-4 oder Claude ein hervorragendes Einstiegsgehirn sein, da es bereits gelernt hat, in natürlicher Sprache zu kommunizieren und zu argumentieren.

Retrieval-Augmented Generation (RAG)

Wenn Ihr Agent häufig viele externe Informationen abrufen oder darauf verweisen muss (wie Dokumente, Wissensdatenbankinhalte), sollten Sie Folgendes in Betracht ziehen: Retrieval-Augmented Generation (RAG) Ansatz.

RAG ist kein spezifisches Modell, sondern ein Design: Es kombiniert ein LLM mit einem Abfragemechanismus. Der Agent nutzt einen Wissensspeicher (wie eine Vektordatenbank oder einen Suchindex), um relevante Informationen für jede Abfrage abzurufen, und das LLM erstellt daraus seine Antwort. Dies ist ideal, wenn Sie aktuelles oder unternehmensspezifisches Wissen benötigen, ohne ein riesiges Modell darauf trainieren zu müssen.

Benutzerdefiniertes ML-Modell

In manchen Fällen benötigen Sie möglicherweise eine benutzerdefiniertes ML-Modell (oder eine Sammlung von Modellen), die für eine bestimmte Aufgabe trainiert wurden. Benutzerdefinierte Modelle eignen sich, wenn Sie über proprietäre Daten und eine klar definierte Vorhersage- oder Klassifizierungsaufgabe verfügen, die generische Modelle nicht kennen.

Oftmals beinhaltet ein KI-Agent tatsächlich eine Kombination: beispielsweise ein benutzerdefiniertes Modell für einen Teil und ein LLM für einen anderen. Entscheiden Sie sich in diesem Schritt für den Kernansatz. Wenn Sie sich für das Trainieren eines Modells entscheiden, planen Sie, wie Sie Trainingsdaten sammeln. Wenn Sie ein vorhandenes Modell verwenden, prüfen Sie, welches am besten geeignet ist (Genauigkeit, Kosten, Geschwindigkeit). Die Entscheidung hängt auch mit dem Technologie-Stack aus dem vorherigen Abschnitt zusammen (nutzen Sie das OpenAI-Modell über die API, optimieren Sie ein offenes Modell usw.?).

Schritt 3: Trainieren Sie Ihre KI (oder optimieren Sie sie)

Jetzt ist es an der Zeit, Ihr KI-Modell für die Aufgabe vorzubereiten. Wenn Sie sich für ein vortrainiertes LLM entschieden haben und dieses sofort Ihre Anforderungen erfüllt, können Sie aufwändiges Training überspringen und direkt mit der Integration beginnen. Oftmals ist jedoch eine Feinabstimmung oder ein Training erforderlich:

- Feinabstimmung: Das bedeutet, dass Sie ein vortrainiertes Modell anhand Ihrer spezifischen Daten weiter trainieren, um Ihre Domäne oder Ihren Anwendungsfall besser zu bewältigen. Feinabstimmung kann die Leistung deutlich verbessern, erfordert aber Trainingsexpertise und sorgfältige Validierung (um Überanpassung oder den Verlust der allgemeinen Fähigkeiten des Modells zu vermeiden).

- Überwachtes Lernen: Wenn Sie Trainieren eines Modells Für die Entwicklung eines neuen oder kleineren Modells benötigen Sie beschriftete Daten. Dies können historische Datensätze oder Wissenspaare sein. Diese Daten werden in Machine-Learning-Algorithmen eingespeist, um das Modell zu trainieren.

- Bestärkendes Lernen: In einigen Fällen, insbesondere bei Agenten, die sequenzielle Entscheidungen treffen müssen oder bei denen Feedback ein Erfolgs-/Misserfolgssignal ist, wird Reinforcement Learning (RL) eingesetzt. Bei SmartDev führen wir oft eine Proof-of-Concept-Schulung In dieser Phase trainieren Sie ein Modell schnell anhand einer Teilmenge von Daten, um die Funktionsfähigkeit des Ansatzes zu überprüfen. Dieser Schritt kann auch eine Datenerweiterung (Erstellung weiterer Trainingsbeispiele) beinhalten und beinhaltet auf jeden Fall das Testen des Modells anhand einiger zurückgehaltener Daten, um seine Leistungsfähigkeit einzuschätzen.

Das Ergebnis von Schritt 3 ist ein bereites Gehirn – entweder eine trainierte Modelldatei oder ein gründlich konfiguriertes externes Modell – das die Kernaufgabe Ihres Agenten ausführen kann.

Schritt 4: Implementieren Sie Speicher und Datenabruf

Als Nächstes geben Sie Ihrem Agenten ein Gedächtnis. Wie bereits erwähnt, kann das Gedächtnis kurz- oder langfristig sein. Für einen Chatbot-Agenten könnte dies bedeuten, einen Mechanismus zum Speichern des Konversationskontexts einzurichten, damit der Agent auf frühere Nachrichten verweisen kann. Dies kann so einfach sein wie die jedes Mal erfolgte Übergabe der letzten N Nachrichten an das Modell oder so komplex wie die Pflege einer Vektordatenbank der bisherigen Konversation.

Für einen Agenten, der betriebswirtschaftliches Wissen benötigt, implementieren Sie hier eine AbrufsystemSie indexieren Ihre Dokumente oder Daten in einer Vektordatenbank oder Suchmaschine. Das Ergebnis: Wenn der Agent eine Anfrage erhält, die er nicht mit seinem eigenen Modellwissen beantworten kann, holt er sich relevante Informationen aus dem Index und fügt sie in seine Antwort ein. Ist Ihr Agent eher prozessorientiert (z. B. ein Automatisierungsagent, der Aufgaben ausführt), kann der Arbeitsspeicher den Status eines Workflows aufrechterhalten. Dieser Schritt stellt sicher, dass der Agent nicht jedes Mal blind arbeitet – er kann sich an das erinnern, was benötigt wird.

Richten Sie hier konkret Ihre Datenbanken ein und laden Sie die ersten Daten. Wenn Sie eine FAQ haben, laden Sie diese in die Wissensdatenbank. Wenn der Agent Benutzereinstellungen abrufen soll, legen Sie fest, wie diese gespeichert und abgerufen werden sollen. Dies könnte beispielsweise das Schreiben von Code erfordern, um Ihr CRM oder Ihre Datenbank abzufragen, sobald der Agent eine Benutzer-ID erhält.

Schritt 5: Integrieren Sie NLP für Gespräche

Die meisten KI-Agenten in Unternehmen müssen menschliche Sprache verarbeiten und generieren, auch wenn es sich nicht um Chatbots handelt. Dieser Schritt beinhaltet die Integration eines NLP-Modells (aus Schritt 3) oder einer API zur Verarbeitung von Benutzereingaben und zur Generierung von Antworten. Bei Dialogagenten definieren Sie, wie diese Fragen verarbeiten und Antworten formulieren. Bei sprachbasierten Agenten umfasst dies die Integration von Sprache-zu-Text und Text-zu-Sprache. Benutzerdefiniertes Vokabular, Regex für strukturierte Daten und Nachbearbeitung (z. B. Verfeinerung des Tons, Formatierung von Antworten) gewährleisten Genauigkeit und Markenkonsistenz.

Bei SmartDev optimieren wir diese Elemente, um ein nahtloses, professionelles Benutzererlebnis zu schaffen. Am Ende dieses Schritts sollte Ihre KI grundlegende Interaktionsmöglichkeiten bieten.

Schritt 6: Verbinden Sie den Agenten mit APIs und externen Tools

KI-Agenten müssen mit externen Systemen interagieren, um Daten abzurufen oder Aktionen auszuführen. Identifizieren Sie die erforderlichen Integrationen:

- Handelsvertreter: Fragt CRM oder Inventar ab („Wir haben 3 auf Lager“ oder „Ihre letzte Bestellung war im Januar“).

- Finanzagent: Ruft Aktienkurse von einer Finanz-API ab.

- IT-Supportmitarbeiter: Erstellt Tickets oder startet Server über Cloud-APIs neu.

Nutzen Sie APIs/SDKs, um diese Funktionen zu ermöglichen. Moderne Frameworks ermöglichen KI-Modellen Funktionen dynamisch aufrufen, wie das Abrufen von Bestelldetails, wenn ein Benutzer nach einer Sendung fragt. Dadurch basieren die Antworten auf realen Daten. Wenn der Agent Aktionen ausführt (z. B. E-Mails senden, Rückerstattungen bearbeiten), stellen Sie sicher, strenge Berechtigungen um Sicherheitsrisiken vorzubeugen.

Am Ende dieses Schritts kann Ihre KI mit Geschäftssystemen interagieren und ist damit mehr als nur ein Chatbot.

Schritt 7: Hinzufügen einer Benutzeroberfläche

Machen Sie die KI nun über eine Schnittstelle zugänglich:

- Chatbot: Integrieren Sie die Inhalte mithilfe von Frameworks wie Drift oder Intercom in eine Website. Sorgen Sie für Branding und eine reibungslose UX (z. B. Tippindikatoren, menschliche Eskalation).

- Sprachassistent: Integrieren Sie Alexa, Google Assistant oder eine mobile App. Konzentrieren Sie sich auf klare Sprachsynthese und Unterbrechungsbehandlung.

- Interne Werkzeuge: Slack-/Teams-Bots oder ein einfaches Web-Dashboard für Mitarbeiter.

SmartDev hat benutzerdefinierte Web-Apps für KI-gestützte Dashboards (z. B. Finanzanalysten, die Berichte mit interaktiven Diagrammen erstellen). Gestalten Sie die Benutzeroberfläche so intuitiv und visuell ansprechend, und führen Sie Benutzer mit Beispielanweisungen. Mit diesem Schritt ist Ihre KI nun für den Einsatz in der realen Welt zugänglich.

Schritt 8: Stellen Sie Ihren KI-Agenten bereit

Zum Bereitstellen Ihres KI-Agenten gehört die Auswahl der richtigen Hosting-Umgebung. Cloud-Plattformen (AWS, Azure, GCP) bieten schnelle Einrichtung und Skalierbarkeit, während vor Ort Bereitstellung bietet vollständige Kontrolle über vertrauliche Daten. Edge-Bereitstellung ist ideal für KI, die eine Offline-Verarbeitung in Echtzeit benötigt.

Um eine reibungslose Bereitstellung zu gewährleisten, Containerisierung mit Docker verpackt die KI und ihre Abhängigkeiten für eine einfache Skalierung. Wenn Sie ein Modell intern hosten, GPU-fähige Server oder Cloud-KI-Instanzen sind notwendig. SmartDev verwendet oft TorchServe oder TensorFlow Serving für effizientes Modell-Hosting.

Sicherheit ist das A und O – speichern API-Schlüssel und Anmeldeinformationen sicher durch Umgebungsvariablen. Ein Beta-Bereitstellung ermöglicht kontrollierte Tests vor der vollständigen Einführung. Am Ende dieses Schritts ist Ihre KI live, integriert und bereit für den Einsatz in der Praxis.

Schritt 9: Optimieren Sie Leistung und Skalierbarkeit

Stellen Sie nach der Bereitstellung sicher, dass Ihre KI schnell, skalierbar und kosteneffizient:

- Überwachen der Leistung: Verfolgen Sie Antwortzeiten, API-Nutzung und Fehlerraten (verwenden Sie Tools wie Datadog oder New Relic).

- Reduzieren Sie die Latenz: Zwischenspeichern Sie häufige Abfragen, optimieren Sie Eingabeaufforderungen und verwenden Sie nach Möglichkeit kleinere Modelle.

- Effiziente Skalierung: Automatisch skalierte Infrastruktur (Kubernetes, AWS ECS) zur Bewältigung von Verkehrsspitzen.

- Kostenoptimierung: Passen Sie die KI-Nutzung an die Nachfrage an – wechseln Sie außerhalb der Spitzenzeiten zu kleineren Modellen.

- Feinabstimmung für Genauigkeit: Verbessern Sie die Antworten auf der Grundlage realer Nutzungsdaten.

In einem SmartDev-Projekt destillierte ein großes Modell in eine kleinere, schnellere Version, wodurch Kosten gesenkt und gleichzeitig qualitativ hochwertige Antworten gewährleistet werden. Nach Abschluss dieses Schritts ist Ihr KI-Agent stabil, effizient und bereit, mit Ihren Geschäftsanforderungen zu skalieren.

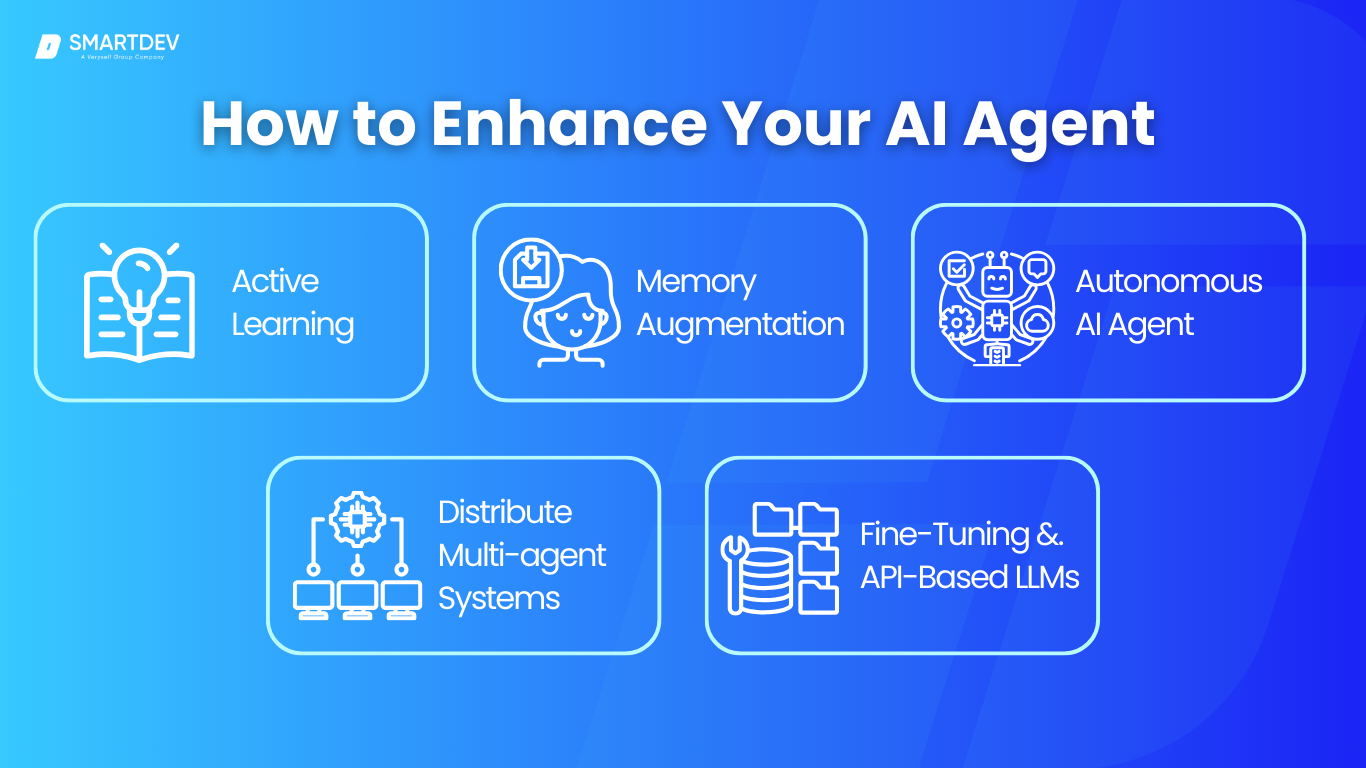

6. Erweiterte Techniken zur Verbesserung Ihres KI-Agenten

Nach der Bereitstellung kann Ihr KI-Agent optimiert und erweitert werden, um Leistung, Genauigkeit und Anpassungsfähigkeit zu verbessern. Diese fortschrittlichen Techniken stellen sicher, dass KI auch langfristig einen geschäftlichen Mehrwert bietet.

6.1. Intelligentere Antworten

KI sollte nicht statisch bleiben – kontinuierliches Lernen stellt sicher, dass sie relevant bleibt, auch wenn sich Daten, Trends und Geschäftsanforderungen weiterentwickeln. Aktives Lernen ermöglicht es der KI, sich anhand von Benutzerinteraktionen zu verfeinern und so die Genauigkeit mit der Zeit zu verbessern.

SmartDev implementierte beispielsweise Feedbackschleifen in ein KI-gestütztes HR-Rekrutierungssystem, sodass Personalmanager die von der KI vorgeschlagenen Kandidaten prüfen und ihre Empfehlungen optimieren konnten. Dieses Echtzeit-Lernen trug dazu bei, die Talentsuche deutlich zu verbessern.

6.2. Gedächtniserweiterung (Langzeitgedächtnis)

Standardmäßig behandeln KI-Modelle jede Abfrage unabhängig, was zu sich wiederholenden oder inkonsistenten Antworten führen kann. Die Kontextspeicherung hilft KI-Agenten, sich an vergangene Interaktionen zu erinnern, was das Kundenerlebnis und die betriebliche Effizienz verbessert.

Techniken wie Vektordatenbanken (Pinecone, Weaviate) und Retrieval-Augmented Generation (RAG) ermöglichen es KI, frühere Interaktionen abzurufen. Dies macht sie ideal für Kundensupport, virtuelle Assistenten und Wissensmanagementsysteme. Dadurch müssen Benutzer Informationen nicht mehr wiederholen und KI kann personalisiertere und effizientere Antworten liefern.

6.3. Autonome KI-Agenten

Die nächste Evolutionsstufe der KI umfasst autonome Agenten, die proaktiv handeln, anstatt nur auf Benutzereingaben zu reagieren. Diese KI-Systeme können Aufgaben planen, ausführen und Entscheidungen mit minimalem menschlichen Eingriff treffen. Technologien wie BabyAGI und AutoGPT ermöglichen es der KI, komplexe Ziele in Teilaufgaben zu zerlegen und diese automatisch auszuführen.

SmartDev erforscht aktiv autonome KI für Geschäftsautomatisierung und Entscheidungsunterstützungssysteme.

6.4. Zusammenarbeit mehrerer Agenten

Anstatt dass eine einzelne KI alle Aufgaben übernimmt, verteilen Multi-Agenten-Systeme die Arbeitslast auf spezialisierte KI-Agenten. Mithilfe von Orchestrierungs-Frameworks wie AutoGen und LangChain können Unternehmen die Zusammenarbeit von KI-Agenten ermöglichen und so die Effizienz steigern.

Beispielsweise haben wir in einem SmartDev-Logistikprojekt ein KI-gesteuertes Sendungsverfolgungssystem entwickelt, bei dem ein KI-Agent den Lieferstatus abfragte, ein anderer Kundenanfragen bearbeitete und ein dritter Entscheidungen in der Lieferkette optimierte. Diese Spezialisierung der KI-Agenten führte zu schnelleren Reaktionszeiten und einer besseren Entscheidungsfindung.

6.5. Feinabstimmung vs. API-basierte LLMs

Vortrainierte Modelle wie GPT-4 oder Llama 2 bieten eine solide Grundlage, verfügen aber nicht über fachspezifisches Fachwissen. Die Feinabstimmung von KI-Modellen anhand geschäftsspezifischer Daten verbessert Präzision und Relevanz. Transferlernen ermöglicht es Unternehmen, ein Modell zu verfeinern, ohne es von Grund auf neu zu trainieren, was Zeit und Kosten spart.

Bei SmartDev haben wir KI-Modelle für die Bereiche Finanzen (Betrugserkennung), Gesundheitswesen (Diagnose) und Einzelhandel (personalisierte Empfehlungen) optimiert und helfen Unternehmen so, genauere und kontextbezogenere KI-Ergebnisse zu erzielen.

7. Ethische Überlegungen und KI-Sicherheit

Der Einsatz von KI in Unternehmen erfordert einen starken Fokus auf Ethik, Sicherheit und ComplianceKI-Agenten können die Effizienz steigern, aber wenn sie nicht richtig gesteuert werden, können sie auch Risiken mit sich bringen, wie Voreingenommenheit, Fehlinformationen und DatenschutzverletzungenBei SmartDev legen wir Wert auf Fairness, Transparenz und Sicherheit, um sicherzustellen, dass KI-Lösungen sowohl effektiv als auch verantwortungsvoll sind.

7.1. Voreingenommenheit in der KI und wie man sie abmildert

KI lernt aus historischen Daten, die möglicherweise Verzerrungen enthalten. Dies kann zu diskriminierenden Ergebnissen führen, beispielsweise zur Bevorzugung bestimmter Kandidaten bei der Einstellung oder zur ungerechtfertigten Ablehnung von Kreditanträgen.

Um dies zu verhindern, sollten Unternehmen Trainingsdaten auf Fairness prüfen, Techniken zur Vermeidung von Verzerrungen anwenden wie Datenausgleich und Neugewichtung, und sorgen Sie für Transparenz, indem Sie eine menschliche Aufsicht zulassen.

Beispiel: Als SmartDev eine KI für Kreditempfehlungen entwickelte, blockierte ortsbezogene Vorurteile um unfaire Kreditentscheidungen zu verhindern.

7.2. KI-Halluzinationen und Fehlerbehandlung

KI erzeugt manchmal Plausible, aber falsche Informationen, die Nutzer in die Irre führen können. Dies ist besonders riskant in Bereichen wie Finanzen, Gesundheitswesen und Kundensupport, wo Genauigkeit entscheidend ist.

Um Halluzinationen vorzubeugen, sollten Unternehmen KI-Antworten mithilfe von Retrieval-Augmented Generation (RAG) auf realen Daten basieren. KI sollte zudem kritische Fakten durch Abgleich mit externen Quellen überprüfen, bevor sie eine Antwort liefert.

Ein weiterer wichtiger Ansatz ist die Verwendung von UI-Indikatoren, die Vertrauensstufen oder Referenzquellen hervorheben. Wenn die KI unsicher ist, sollte sie sich auf die menschliche Überprüfung verlassen. anstatt das Risiko einzugehen, irreführende Informationen bereitzustellen.

Beispiel: SmartDev hat einen KI-Agenten entwickelt, der prüft die Fakten, bevor er antwortet, um Zuverlässigkeit zu gewährleisten und Fehlinformationen zu reduzieren.

7.3. Datenschutz- und Sicherheitsbedenken

KI-Agenten verarbeiten häufig sensible Kunden- und Geschäftsdaten, Datenschutz und Sicherheit haben oberste PrioritätUnternehmen müssen sicherstellen, dass KI keine vertraulichen Informationen speichert, preisgibt oder missbraucht.

Um Risiken zu minimieren, sollten Unternehmen Grundsätze der Datenminimierung: KI sammelt nur das Nötigste. Verschlüsselung und strenge Zugriffskontrollen schützen die Daten bei Speicherung und Übertragung.

Unternehmen müssen sich zudem vor KI-Datenlecks schützen und verhindern, dass Modelle versehentlich vertrauliche Daten in Antworten preisgeben. Darüber hinaus ist eine verstärkte KI-Sicherheit notwendig, um Cyberbedrohungen wie Prompt-Injection-Angriffe zu verhindern, bei denen Benutzer versuchen, KI zu manipulieren und vertrauliche Informationen preiszugeben.

Bewährte Vorgehensweise: Bei SmartDev behandeln wir KI-Sicherheit wie menschliche Mitarbeiter –Zugriffsbeschränkung, Überwachung der Aktivitäten und Durchsetzung strenger Sicherheitsprotokolle.

7.4. Einhaltung gesetzlicher Vorschriften

KI-Systeme müssen globale und branchenspezifische Vorschriften um rechtliche Risiken zu vermeiden.

- DSGVO (EU) erfordert KI, um Schützen Sie Benutzerdaten, sorgen Sie für Transparenz bei automatisierten Entscheidungen und ermöglichen Sie Benutzern, die Löschung von Daten anzufordern.

- Der EU-KI-Act werde vorstellen risikobasierte KI-Regulierung, die Dokumentation und Erklärbarkeit für KI-Anwendungen mit hohem Risiko erfordern.

- CCPA (Kalifornien) verpflichtet Unternehmen dazu, Benutzern Zugriff auf die von KI erfassten personenbezogenen Daten gewähren und diese auf Anfrage löschen.

- KI im Gesundheitswesen muss HIPAA einhalten und die Finanz-KI muss den SEC- und FINRA-Vorschriften entsprechen.

Proaktive Compliance ist unerlässlich. Unternehmen sollten Dokumentieren Sie die Entscheidungsfindung durch KI und überprüfen Sie regelmäßig die gesetzlichen Anforderungen, um den sich entwickelnden Vorschriften immer einen Schritt voraus zu sein.

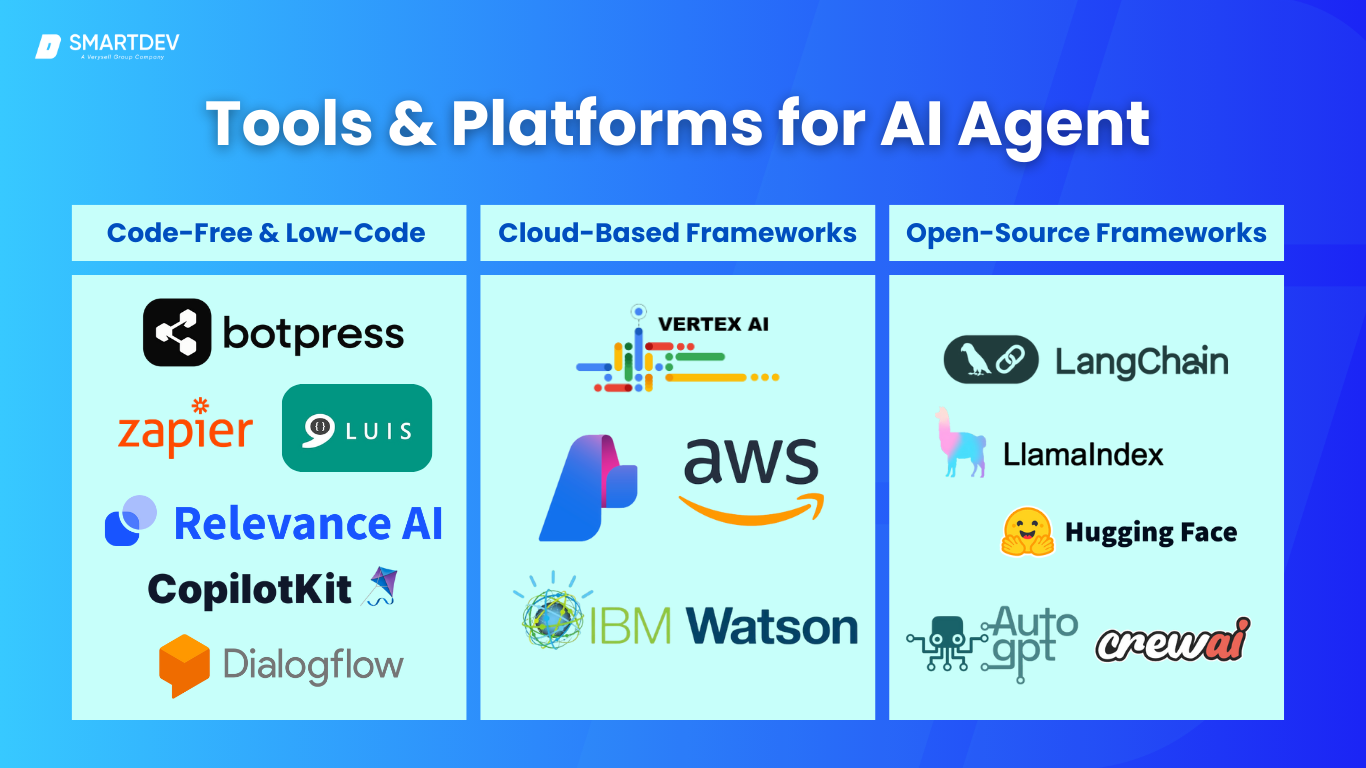

8. Tools und Plattformen für die Entwicklung von KI-Agenten

In diesem Abschnitt erkunden wir ein Spektrum an Optionen, von No-Code/Low-Code-Plattformen, mit denen Sie KI-Agenten mit minimalem Programmieraufwand erstellen können, über große Cloud-Frameworks der Technologiegiganten bis hin zu leistungsstarken Open-Source-Frameworks, die Ihnen volle Kontrolle und Community-Support bieten.

Wir gehen auch darauf ein, wie nützlich es sein kann, zu Open Source beizutragen, wenn Sie ein Entwicklerteam haben, das stets auf dem neuesten Stand sein möchte.

8.1. Codefreie und Low-Code-KI-Agent-Builder

Wenn Sie Wert auf Geschwindigkeit und Einfachheit legen oder kein professioneller Entwickler sind, können Low-Code-Plattformen eine große Hilfe sein. Dabei handelt es sich um Tools, bei denen ein Großteil der Hauptarbeit (NLP, Integrationen, UI) über visuelle Schnittstellen oder einfache Konfigurationen abgewickelt wird, sodass Sie sich auf die Gestaltung des Konversationsflusses oder der Logik konzentrieren können. Beispiele:

- BotPress: Eine beliebte Open-Source-Plattform zum Erstellen von Chatbots und KI-Assistenten. Sie bietet einen visuellen Ablaufeditor, unterstützt mehrere Kanäle (Web, Messenger usw.) und ermöglicht die Integration eigener KI-Modelle oder die Nutzung der integrierten NLP-Funktion. BotPress ermöglicht zwar die Programmierung benutzerdefinierter Aktionen, vieles lässt sich aber auch per Drag-and-Drop erledigen.

- Zapier mit KI-Integrationen: Zapier ist bekannt für die Vernetzung verschiedener Apps (nach dem Motto „Wenn dies, dann das“). Mit den neuesten KI-Funktionen können Sie Eingaben an KI-Dienste und dann an andere Apps weiterleiten und so einen Agenten-Workflow erstellen, ohne Code schreiben zu müssen. Beispielsweise könnte Zapier eine E-Mail empfangen, sie zur Analyse über einen Zap an die API von OpenAI senden und dann basierend auf dem Ergebnis verschiedene Aktionen auslösen (z. B. die Planung eines Meetings oder eine Antwort).

- Relevanz KI: Eine Plattform, die sich auf die Entwicklung KI-gestützter Such- und Insight-Engines konzentriert. Wenn Ihr Agent Informationen abrufen soll (z. B. ein intelligenter Suchassistent für Ihre Unternehmensdaten), bietet Relevance AI eine Benutzeroberfläche zur Datenaufnahme und semantischen Suche. So können Sie schnell ein intelligentes Q&A-System einrichten.

- CopilotKit: (Wie in der Übersicht erwähnt – nicht so allgemein bekannt wie andere, aber wahrscheinlich ein Tool zum Erstellen von KI-Copiloten für verschiedene Aufgaben.) Dies könnte ein Framework sein, das Vorlagen zum Erstellen von KI-Assistenten oder Copiloten in Anwendungen wie IDEs oder Produktivitätssoftware bereitstellt.

- Dialogflow (Google) und LUIS (Microsoft): Diese Low-Code-Plattformen bieten eine einfache Möglichkeit, Konversations-KI zu entwickeln, indem sie Intentionen definieren und Phrasen trainieren. Machine Learning übernimmt dabei NLP. Vorteile sind die schnelle Einrichtung, integrierte Analysefunktionen und der Wegfall der Infrastrukturverwaltung. Allerdings sind sie hinsichtlich der Anpassungsmöglichkeiten eingeschränkt – erweiterte Anforderungen erfordern möglicherweise die Migration zu individuellen Lösungen.

8.2. Cloudbasierte KI-Agenten-Frameworks

Die großen Cloud-Anbieter bieten robuste Dienste zum Erstellen und Bereitstellen von KI-Agenten im großen Maßstab:

- Google Cloud Agent Builder (Vertex AI): Google hat Konversations-KI in seine Vertex-KI-Plattform integriert. Diese wird oft als „Agent Builder“ bezeichnet und wurde entwickelt, um generative KI-Anwendungen zu entwickeln. Sie bietet Tools zur Dialoggestaltung, zur Integration mit Datenquellen (wie der Google-Suche oder Ihrer eigenen Wissensdatenbank) und zur Bereitstellung auf der Google-Infrastruktur. Wenn Sie bereits im Google-Ökosystem aktiv sind, kann dies von großem Nutzen sein, da Sie die Modelle (wie PaLM oder später Gemini) mit Enterprise-Funktionen kombinieren können.

- Azure AI (einschließlich Bot Service und Azure OpenAI): Microsoft Azure bietet einen Bot-Dienst, der mit dem Bot Framework SDK funktioniert. Darüber hinaus verfügt es über den Azure OpenAI-Dienst, mit dem Sie OpenAI-Modelle in der Azure-Cloud mit Unternehmenssicherheit nutzen können. Microsoft Power Virtual Agents ist ein weiterer No-Code-Builder für Chatbots, der nahtlos in die Azure-KI eingebunden ist. Der Vorteil von Azure liegt in der nahtlosen Integration mit dem Microsoft-Stack (wie Teams, Office 365 usw.), was für interne Agenten von Vorteil sein kann (stellen Sie sich einen in Teams zugänglichen KI-Agenten vor, der Daten aus SharePoint abrufen und Berichte über Power BI erstellen kann).

- AWS-KI-Dienste: AWS bietet Amazon Lex (für Konversationsschnittstellen, ähnlich wie Dialogflow), Amazon Lambda für serverlose Logik und eine Vielzahl von KI-Diensten wie Comprehend (NLP) und Rekognition (Vision), falls Ihr Agent multimodale Fähigkeiten benötigt. Außerdem gibt es AWS SageMaker, wenn Sie benutzerdefinierte Modelle trainieren und bereitstellen möchten. Die Bandbreite von AWS ist enorm, erfordert aber oft etwas mehr Montageaufwand. Allerdings wurden kürzlich einige höherstufige Orchestrierungen für generative KI eingeführt. Beispielsweise ist AWS Bedrock der Managed Service für Basismodelle, der sich problemlos in einen Agenten integrieren lässt.

- IBM Watson-Assistent: IBM ist mit Watson Assistant in diesem Bereich aktiv, einem Cloud-Service zur Entwicklung von Konversationsagenten mit Fokus auf Unternehmenskunden. Erwähnenswert ist dieser Service insbesondere für Branchen wie das Gesundheitswesen oder das Finanzwesen, in denen IBM maßgeschneiderte Lösungen anbietet (und eine starke Datenverwaltung benötigt). Die Nutzung dieser Cloud-Frameworks bietet in der Regel sofort einsatzbereite Skalierbarkeit und Integration. Sie sind für Aufgaben wie die Skalierung für Spitzenlasten, die Überwachung und die Anbindung an andere Cloud-Dienste konzipiert.

8.3. Open-Source-KI-Agenten-Frameworks

Für maximale Flexibilität und um Anbieterbeschränkungen zu vermeiden, ist Open Source die beste Lösung. Die KI-Community ist lebendig und es sind zahlreiche Frameworks entstanden:

- LangChain: LangChain ist wohl eine der beliebtesten Bibliotheken für die Anwendungsentwicklung mit LLMs in den Jahren 2023–2024. Es ermöglicht die Verknüpfung von Eingabeaufforderungen, Modellen und beliebiger Logik (einschließlich der Verwendung von Tools). Es eignet sich hervorragend für die Erstellung von Agentenverhalten wie „Wenn der Benutzer nach X fragt, führe zuerst Y aus und antworte dann“. Es bietet außerdem Speicherintegrationen (z. B. mit Vektorspeichern) und kann Dialoge verwalten. Wir haben LangChain in SmartDev verwendet, um schnell Prototypen komplexer Verhaltensweisen zu erstellen (z. B. einen Agenten, der Berechnungen durchführen kann, indem er ein Taschenrechner-Tool aufruft und dann antwortet).

- LlamaIndex (GPT-Index): Dieses Tool verbindet LLMs mit externen Daten. Es ergänzt LangChain häufig – mit Fokus auf die Datenseite, was die Abfrage vereinfacht (wie in RAG beschrieben). LlamaIndex ermöglicht die Strukturierung Ihrer Daten (Dokumente, Datenbanken) in einem Index, den ein LLM in natürlicher Sprache abfragen kann. Es eignet sich hervorragend für Q&A- oder wissensbasierte Agenten.

- Umarmungsgesichtstransformatoren: Kein Agenten-Framework im eigentlichen Sinne, sondern die Kernbibliothek zur Integration beliebiger Modelle. Wenn Sie Ihre Modelle vollständig auf Open Source umstellen (z. B. Flan-T5 für die Qualitätssicherung oder Llama für Konversationen), ist diese Bibliothek unverzichtbar. Sie bietet Ihnen die Modellimplementierungen und Pipelines, die deren Nutzung vereinfachen. Hugging Face bietet außerdem Accelerate für Multi-GPU und die Datasets-Bibliothek zur Verwaltung von Trainingsdaten.

- AutoGPT und Ähnliches: Diese begannen als Open-Source-Projekte auf GitHub, die autonome Agenten demonstrierten. AutoGPT ist selbst Open Source (Python) und wurde von vielen geforkt/erweitert. Wenn Sie mit autonomem Verhalten oder Multi-Agent-Setups experimentieren möchten, kann die Erkundung dieser Repos aufschlussreich sein (obwohl sie experimentell sein können).

- CrewKI: Wie unsere Forschung gezeigt hat, ist CrewAI ein Open-Source-Framework speziell für Multi-Agenten-Systeme. Es legt den Schwerpunkt auf die Orchestrierung verschiedener Agenten in einem Workflow und die Integration mit verschiedenen LLMs oder Tools. Wenn Ihr Projekt in diese Richtung tendiert, könnte ein offenes Framework wie CrewAI Ihnen die Neuerfindung dieser Koordinationslogik ersparen.

Darüber hinaus ist das Ökosystem vielfältig – zum Beispiel Rasa (ein Open-Source-Framework für Konversations-KI, das sehr leistungsstark für Dialoge ist und über maschinell lernendes Dialogmanagement verfügt), Open Assistant usw. Dank Open-Source-Frameworks können Sie alles individuell anpassen. Sie können auch selbst hosten, was den Datenschutz erhöht. Die Beiträge der Community sind von unschätzbarem Wert – Sie finden zahlreiche Beispiele, und wenn Sie auf ein Problem stoßen, hat wahrscheinlich schon jemand anderes eines gehabt und eine Lösung geteilt.

Mehr lesen: Open Source vs. proprietäre KI

So tragen Sie zur Open-Source-Entwicklung von KI-Agenten bei

Dies ist ein kleiner Exkurs, aber lohnenswert, wenn Sie über ein fähiges Entwicklerteam verfügen. Durch die Teilnahme an Open-Source-Projekten:

- Sie können Funktionen steuern, die Ihnen wichtig sind. Wenn Ihr Team ein cooles Plugin für LangChain zur Integration mit einer einzigartigen Datenbank entwickelt, kann die Bereitstellung dieses Plugins dazu beitragen, die Kompatibilität und Wartung durch die Community sicherzustellen.

- Sie gewinnen an Ansehen und Einblick. Aktive Mitwirkende erfahren oft frühzeitig von bevorstehenden Änderungen, und Ihr Unternehmen kann als führend in der Branche wahrgenommen werden – eine gute PR.

- Es geht um Kostenteilung. Indem Sie einen Fehler beheben und teilen, ersparen Sie anderen den Aufwand und profitieren selbst von deren Fehlerbehebungen – eine gemeinschaftliche Anstrengung, die die Stabilität verbessert. Um einen Beitrag zu leisten, können Sie zunächst Probleme für diese Projekte auf GitHub melden und anschließend Pull Requests für kleinere Änderungen stellen. Einige Unternehmen sponsern Open-Source-Betreuer, was eine weitere Möglichkeit sein kann, das von Ihnen genutzte Ökosystem zu unterstützen.

Zusammenfassend lässt sich sagen: Egal, ob Sie sich für Low-Code-Plattformen, Cloud-Lösungen oder Open-Source-Frameworks (oder eine Kombination daraus) entscheiden, es gibt zahlreiche Tools für die Entwicklung Ihres KI-Agenten. Die Wahl hängt davon ab, wie viel Sie individuell anpassen möchten und wie viel Ihnen bereitgestellt werden soll.

9. Testen, Debuggen und Leistungsoptimierung

Ein gut getesteter und optimierter KI-Agent ist zuverlässiger, präziser und skalierbarer. KI kann unvorhersehbar sein. Daher verhindert das Erkennen von Problemen vor der Bereitstellung Benutzerfrustration und kostspielige Fehler. Dieser Abschnitt behandelt Teststrategien, das Debuggen von KI-Problemen und Leistungsoptimierung um Effizienz und Kosteneffizienz zu gewährleisten.

9.1. Testen von KI-Agenten: Sicherstellung der Zuverlässigkeit

Aufgrund der probabilistischen Natur von KI-Tests ist eine Mischung aus herkömmlichen Softwaretests und KI-spezifischer Evaluierung erforderlich.

Unit- und Funktionstests

Bei deterministischen Komponenten (z. B. API-Aufrufen, Ausgabeformatierung) stellen Standard-Unit-Tests die Funktionalität sicher. Da KI-Antworten jedoch variieren, sollten Funktionstests sicherstellen, dass die Antworten logisch korrekt und nicht wortwörtlich identisch sind.

Simulation und A/B-Tests

Die Simulation von Benutzerinteraktionen hilft, Schwachstellen in mehrstufigen Konversationen zu identifizieren. KI-gegen-KI-Tests, bei denen eine KI den Benutzer simuliert, können Lücken im Umgang mit gegnerischen Eingaben aufdecken. A/B-Tests vergleichen verschiedene KI-Versionen in realen Anwendungsfällen, um anhand von Benutzerbewertungen, Lösungsraten und Reaktionszeiten die beste Leistung zu ermitteln.

Mensch-in-the-Loop und kontinuierliche Überwachung

Für subjektive Faktoren wie Ton oder Hilfsbereitschaft ist die menschliche Bewertung entscheidend. Betatester und Kommentatoren können KI-Antworten bewerten und so weitere Verbesserungen anstoßen. Echtzeitüberwachung hilft ebenfalls – sie protokolliert KI-Fehler, überprüft unbekannte Abfragen und verbessert die Antworten basierend auf der Live-Nutzung.

9.2. Fehlerbehebung bei häufigen KI-Problemen

Das Debuggen von KI-Systemen kann komplex sein, da Fehler nicht immer eindeutige Ursachen haben. Eine systematische Fehlersuche hilft jedoch, die häufigsten Probleme zu lösen:

Halluzinationen (Falsche Informationen)

Sie entstehen, wenn KI zwar plausible, aber falsche Antworten generiert. Dies lässt sich abmildern, indem KI-Antworten mithilfe von Retrieval-Augmented Generation (RAG) auf realen Daten basieren. Durch die Anpassung der Temperatureinstellung wird die KI deterministischer und verringert die Wahrscheinlichkeit erfundener Antworten. Ein weiterer Ansatz ist die Implementierung einer Verifizierungsebene, in der die KI kritische Fakten vor ihrer Antwort mit einer zuverlässigen Datenbank abgleicht.

Kontextverlust

Dies ist ein weiteres häufiges Problem in KI-gesteuerten Konversationen. Wenn eine KI vorherige Nachrichten vergisst, liegt dies oft daran, dass das Kontextfenster des Modells überschritten wird oder die Sitzungsverfolgung unzureichend ist. Unternehmen können wichtige Details der Konversation zusammenfassen, um wichtige Informationen zu bewahren und gleichzeitig die Speichergrenzen einzuhalten. Darüber hinaus kann das Debuggen der Sitzungsverlaufsprotokolle der KI aufzeigen, wo Kontextbrüche auftreten.

Langsame Verarbeitung

Dies kann auf große Modellgrößen, ineffiziente API-Aufrufe oder unnötige Rechenschritte zurückzuführen sein. Die Identifizierung von Leistungsengpässen durch Latenzprofilierung ermöglicht es Entwicklern, Verzögerungen zu lokalisieren. Lösungen umfassen das Zwischenspeichern häufiger Abfragen, die Reduzierung von API-Abhängigkeiten oder die Verwendung optimierter Modellversionen.

9.3. Leistungsoptimierung

Um eine reibungslose Leistung zu gewährleisten, sollten Unternehmen ihre KI-Agenten kontinuierlich hinsichtlich Geschwindigkeit, Skalierbarkeit und Kosteneffizienz optimieren.

Latenzreduzierung

Dies ist entscheidend für KI-Interaktionen in Echtzeit. Zu den Optimierungen gehören die Quantisierung von Modellen (Reduzierung der Präzision zur Beschleunigung der Inferenz), die Ermöglichung paralleler Verarbeitung für den gleichzeitigen Datenabruf und die Nutzung von Edge-Caching, um Antworten für globale Benutzer schneller bereitzustellen.

Optimierungskosten

Jedes Unternehmen sollte teure API-Aufrufe minimieren, indem es einfache Abfragen an kleinere, kostengünstigere Modelle weiterleitet und leistungsstarke KI für komplexe Aufgaben reserviert. Cloudbasierte KI-Agenten sollten mit automatischer Skalierung ausgestattet sein und die Ressourcen bedarfsgerecht anpassen, um unnötige Rechenkosten zu vermeiden. Die Wahl der richtigen Infrastruktur – ob CPU- oder GPU-basiert – gewährleistet optimale Effizienz.

Verwaltung Erinnerung Und Ressourcennutzung ist ebenfalls unerlässlich. Große KI-Modelle verbrauchen viel RAM, daher kann die gemeinsame Nutzung eines zentralen Modells anstelle der Duplizierung von Prozessen den Ressourcenverbrauch erheblich senken. Die Optimierung der Vektordatenbankindizierung und das Löschen unnötiger Daten steigern die Effizienz zusätzlich.

10. Bereitstellen und Skalieren

Die Wahl des richtigen Hosting-Ansatzes, die Implementierung von CI/CD-Pipelines und die Vorbereitung auf hohen Datenverkehr sind entscheidend, um Ihren KI-Agenten zu einer nachhaltigen Geschäftslösung zu machen.

10.1. Hosting-Optionen: On-Premise vs. Cloud-Bereitstellung

Wo Ihr KI-Agent ausgeführt wird, hat direkte Auswirkungen Leistung, Kosten, Und Einhaltung.

On-Premise-Bereitstellung

Diese Methode eignet sich ideal für Unternehmen mit sensiblen Daten, wie Banken, Krankenhäuser oder Behörden, wo gesetzliche Bestimmungen den Datentransfer von Unternehmensservern verbieten. Sie bietet zudem langfristige Kosteneinsparungen, sofern die Infrastruktur bereits vorhanden ist. On-Premises-Lösungen bringen jedoch auch Herausforderungen mit sich: manuelle Skalierung, Hardwarewartung und der Bedarf an IT-Expertise für Sicherheit, Redundanz und Hochverfügbarkeit. Unternehmen, die On-Premises einsetzen, nutzen häufig Kubernetes, um die Skalierung zu automatisieren und die Ausfallsicherheit zu verbessern.

Cloud-Bereitstellung (AWS, Azure, GCP)

Dies bietet Flexibilität und Skalierbarkeit, sodass Unternehmen klein anfangen und bei Bedarf ohne Hardwarebeschränkungen skalieren können. Cloud-Plattformen bieten verwaltete KI-Dienste, On-Demand-GPUs und vorgefertigte Überwachungstools, die die Bereitstellung und KI-Agenten warten. Bei hoher Nutzung können die Kosten jedoch unerwartet steigen, und Unternehmen müssen beim Umgang mit Kundeninformationen in der Cloud die Einhaltung der Datenschutzgesetze sicherstellen.

Ein hybrider Ansatz ist oft eine praktische Lösung, da sensible Komponenten vor Ort bleiben und Cloud-Dienste für Skalierbarkeit und komplexe Berechnungen genutzt werden. Dieses Setup ermöglicht es KI-Agenten, kritische Daten lokal zu verarbeiten und gleichzeitig Cloud-KI-Modelle für ressourcenintensive Aufgaben zu nutzen.

10.2. CI/CD-Pipelines für KI-Agenten

Kontinuierliche Integration/Kontinuierliche Bereitstellung (CI/CD) sorgt dafür nahtlose Updates sowohl auf KI-Modelle als auch auf Code, wodurch Ausfallzeiten vermieden und Bereitstellungsrisiken minimiert werden.

Versionskontrolle für Code und Modelle

Codeänderungen sollten automatisierten Tests in CI-Pipelines unterzogen werden, während KI-Modelle versioniert und in einem Modellregister (z. B. MLflow, DVC) gespeichert werden sollten. Dies verhindert versehentliche Rollbacks und stellt sicher, dass in der Produktion stets das zuverlässigste KI-Modell verwendet wird.

Automatisiertes Testen

Dies sollte Folgendes umfassen KI-spezifische Validierung. Da KI-Ausgaben probabilistisch sind, sollten sich Tests darauf konzentrieren, zu überprüfen, ob die Antworten logisch korrekt sind, die erforderlichen Informationen enthalten und keine Qualitätseinbußen aufweisen.

Sichere Bereitstellungsstrategien

Die Strategien liBlue-Green-Deployments oder Canary-Releases helfen, Risiken bei der Einführung von Updates zu minimieren. Neue KI-Versionen sollten vor der vollständigen Bereitstellung mit einem kleinen Prozentsatz des Datenverkehrs getestet werden, um zu verhindern Betriebsunterbrechungen.

Rollback-Pläne

Wenn ein neues KI-Modell oder eine neue KI-Funktion Leistungsprobleme verursacht, gewährleistet die Möglichkeit, schnell zur vorherigen Version zurückzukehren, die Systemstabilität. Die Verwendung von Container-Deployments (Docker, Kubernetes) ermöglichtes Rollback-Management einfacher.

10.3. Skalierung für Umgebungen mit hohem Datenverkehr

Wenn Ihr KI-Agent an Fahrt gewinnt, Skalierbarkeit wird entscheidend um die steigende Anzahl an Benutzern und Anfragen effizient zu bewältigen.

Lastenausgleich

Es ist amNur zum Verteilen von Anfragen auf mehrere Instanzen, um konsistente Antwortzeiten und Redundanz zu gewährleisten. Cloudbasierte Load Balancer (AWS ELB, Azure Load Balancer) oder Kubernetes Ingress Controller ermöglichen Unternehmen eine horizontale Skalierung ohne Serviceunterbrechung.

Zustandslose Architektur

Die Konzentration darauf verbessert die SkalaFähigkeit, indem der Benutzerkontext extern (z. B. Redis, Sitzungsdatenbanken) statt innerhalb der KI-Instanz gespeichert wird. Dies ermöglicht es mehreren KI-Instanzen, Benutzeranfragen austauschbar zu verarbeiten, ohne Verlust des Gesprächsverlaufs.

KI-Modelle effizient skalieren

Der Faktor ist Herausforderungnging aufgrund des GPU-Ressourcenbedarfs. Unternehmen trennen häufig die KI-Inferenzschicht von der API-Schicht, sodass Anfragen in die Warteschlange gestellt und von dedizierten GPU-Instanzen verarbeitet werden können. Dieser Ansatz verhindert Engpässe und verbessert die Kosteneffizienz.

Autoscaling-Mechanismen

Kubernetes Horizontal Pod Autoscaler oder Cloud-native Auto-Scaling stellt sicher, dass die Instanzen während der Spitzenzeiten zunehmen und bei sinkender Nachfrage herunterskaliert werden, wodurchg Betriebskosten.

Caching und Antwortoptimierung

Häufig angeforderte KI-Antworten oder Datenbankabfragen können zwischengespeichert werden, um die Verarbeitungszeit zu verkürzen. Dies ist besonders nützlich für KI-Agenten, die wiederkehrende Anfragen oder FAQ-Fragen beantworten.

10.4. Serverlose KI-Agent-Bereitstellung

Serverlose KI (AWS Lambda, Google Cloud Functions, Azure Functions)

Dies ermöglicht es Unternehmen, KI-Agenten zu betreiben, ohne die Infrastruktur verwalten zu müssen. Dieser Ansatz eignet sich ideal für die Bewältigung unvorhersehbaren Datenverkehrs, da er automatisch auf Basis eingehender Anfragen skaliert..

Serverlose KI kommt jedoch mit Kaltstartverzögerungen und Laufzeitbeschränkungen, wodurch es für die Echtzeit-KI-Verarbeitung weniger geeignet ist. Unternehmen können KI-Modelle warmhalten, indem sie eine Mindestanzahl aktiver Instanzen aufrechterhalten um Verzögerungen zu vermeiden.

Edge-KI-Bereitstellung

Dadurch können KI-Modelle näher an den Nutzern an Edge-Standorten ausgeführt werden, was die Latenz bei der Echtzeitverarbeitung reduziert. Cloudflare Workers, Fly.io und AWS Wavelength ermöglichen es Unternehmen, KI-Logik an mehreren globalen Edge-Standorten einzusetzen und so die Geschwindigkeit für geografisch verteilte Nutzer zu verbessern.

11. Zukünftige Trends bei KI-Agenten

Von zunehmendenVon der KI-Autonomie bis hin zu selbstlernenden Modellen und immersiven KI-Erlebnissen verspricht die Zukunft der KI-Agenten mehr Intelligenz, Anpassungsfähigkeit und Integration in unser tägliches Leben.

11.1. AGI (Künstliche Allgemeine Intelligenz) und KI-Autonomie

Künstliche allgemeine Intelligenz (AGI) bezieht sich auf KI, diet kann argumentieren, lernen und Wissen in verschiedenen Bereichen anwenden, mähnlich wie ein Mensch. Während die heutigen KI-Agenten aufgabenspezifisch, Fortschritte bei Modellen wie GPT-4, Gemini und Claude zeigen Fortschritte in Richtungd allgemeinere KI-Fähigkeiten.

Noch vor Erreichen des AGI autonome KI-Agenten einwerden immer mächtiger. Werkzeuge wie AutoGPT und BabyAGI ermöglichen es KI bereits, komplexe Aufgaben in mehrstufige Aktionspläne. In Zukunft könnten Unternehmen KI-Agenten einsetzen, die ganze Abläufe verwalten, wie kürzlich die brandneue ChatGPT-4.5 von OpenAI oder Grok-3 von Elon Musks xAI.

Die zunehmende Autonomie wirft jedoch auch Fragen hinsichtlich der Ausrichtung, der ethischen Kontrolle und der Auswirkungen auf die Belegschaft auf. Unternehmen sollten KI-Governance-Rahmenwerke planen, um sicherzustellen, dass KI-Systeme verantwortungsvoll eingesetzt werden und gleichzeitig die Produktivität maximiert wird.

11.2. Der Aufstieg von Multi-Agenten-Systemen

Das Konzept von Multi-Agenten-Systemen, bei denen mehrere KI-Agenten interagieren, um komplexe Aufgaben zu erledigen, gewinnt an Bedeutung. Google DeepMinds Einführung von SIMA (Scalable Instructable Multiworld Agent) veranschaulicht diesen Trend. SIMA kann natürliche Sprachanweisungen verstehen und befolgen, um Aufgaben in verschiedenen virtuellen 3D-Umgebungen zu erledigen und sich an neue Aufgaben und Einstellungen anzupassen, ohne Zugriff auf den Quellcode oder die APIs des Spiels zu benötigen.

11.3. Selbstlernende KI und AutoML

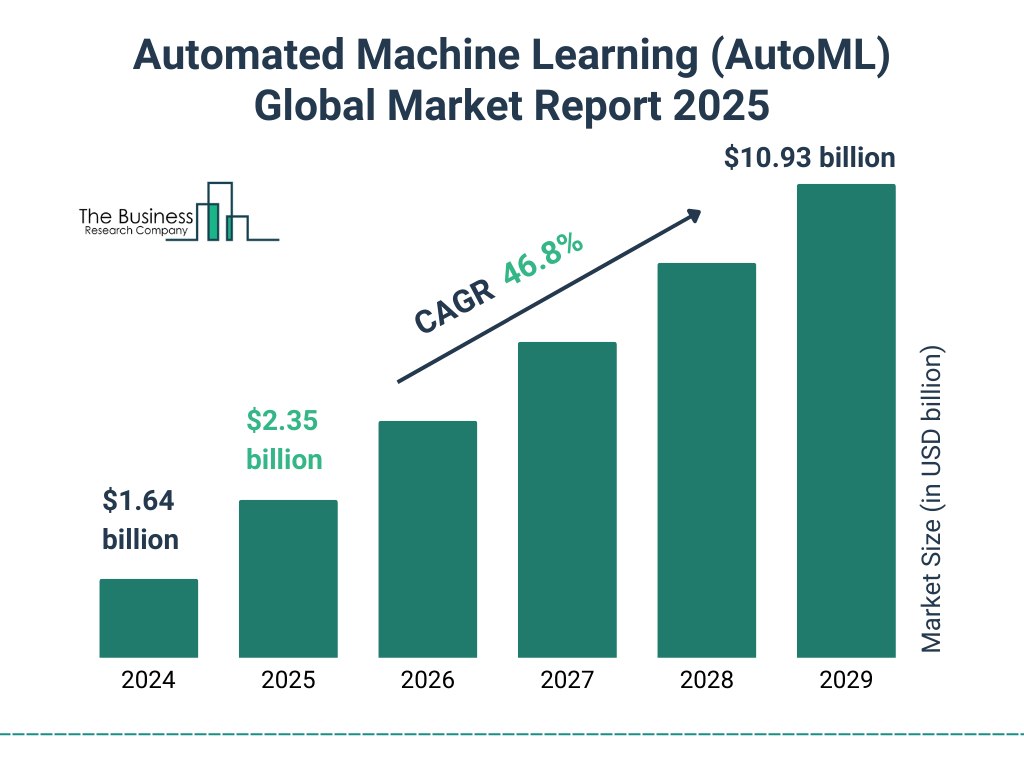

KI-Systeme sind zunehmend in der Lage, sich durch Mechanismen wie Reflexion und Selbstlernen selbst zu verbessern. Es wird prognostiziert, dass der Markt für automatisiertes maschinelles Lernen (AutoML) in den nächsten Jahren exponentiell wachsen wird. Es wird bis 2029 auf $10,93 Milliarden anwachsen, bei einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 46,8%." von Das Unternehmen für Wirtschaftsforschung

Die Entwicklung von Modellen wie o1-preview und o1 durch OpenAI, die über verbesserte Denkfähigkeiten verfügen, unterstreicht diesen Fortschritt. Diese Modelle können mehrstufige Probleme lösen, indem sie ihre eigenen Fehler identifizieren und korrigieren, was zu verbesserter Kohärenz und reduzierten Ungenauigkeiten führt.

11.4. KI-Agenten für das Metaversum, AR und VR

Mit der Weiterentwicklung der Technologien für Augmented Reality (AR) und Virtual Reality (VR) werden KI-Agenten eine Schlüsselrolle bei immersiven digitalen Erlebnissen spielen.

In der erweiterten Realität könnten KI-Agenten als visuelle Assistenten fungieren und durch Smart Glasses oder mobile Kameras erscheinen, um kontextbezogene Anleitungen zu geben. Beispielsweise könnte ein KI-gestützter technischer Assistent Reparaturanweisungen auf Maschinen einblenden und Benutzer durch Wartungsvorgänge führen.

In VR und im Metaversum könnten KI-Agenten als virtuelle Vertriebsmitarbeiter, digitale Trainer oder interaktive Markenbotschafter fungieren. Unternehmen könnten KI-gesteuerte VR-Simulationen für Kundenservice-Schulungen nutzen, um Mitarbeitern realistische Interaktionen mit KI-gesteuerten Kunden zu ermöglichen.

Mit digitalen Zwillingen könnten Unternehmen Fabriken, Büros oder Einzelhandelsflächen in virtuellen Umgebungen nachbilden und mithilfe von KI-Agenten reale Abläufe simulieren, Ineffizienzen erkennen und Prozesse optimieren.

12. Wichtige Erkenntnisse

- KI kann wahrnehmen, verarbeiten und handeln und Aufgaben wie Kundensupport, Datenanalyse und Automatisierung mit minimalem menschlichen Aufwand erledigen.

- Ein strukturierter Ansatz – Auswahl des richtigen Technologie-Stacks, Integration von APIs, Optimierung von NLP und Gewährleistung der Skalierbarkeit – führt zu zuverlässigen KI-Lösungen.

- Von speichergestützten Agenten bis hin zu autonomer KI und der Zusammenarbeit mehrerer Agenten wächst das Potenzial der KI rasant.

- Eine verantwortungsvolle KI-Entwicklung gewährleistet Fairness, Transparenz und Compliance und schützt sowohl Unternehmen als auch Benutzer.

- Unternehmen müssen sich an die Fortschritte der KI anpassen und dabei selbstlernende Modelle, KI-gesteuerte Automatisierung und immersive Technologien wie AR und VR nutzen.

Lassen Sie uns gemeinsam die Zukunft gestalten!

KI ist nicht nur ein Werkzeug – sie ist ein Geschäftsförderer Das verbessert die Effizienz, Entscheidungsfindung und KundenbindungDie Reise beginnt mit einen Schritt– sei es die Automatisierung eines Routineprozesses, die Einführung eines KI-gestützten Assistenten oder die Integration von KI-Erkenntnissen in die Geschäftsstrategie.

SmartDev hilft Ihnen gerne weiter. Wir arbeiten mit Unternehmen zusammen und bieten KI-Expertise, maßgeschneiderte Lösungen und strategische Beratung um die digitale Transformation voranzutreiben. Egal, ob Sie KI zum ersten Mal erkunden oder Skalieren und optimieren Sie vorhandene KI-Lösungen, unser Team steht bereit, Sie zu unterstützen.

📌 Nächste Schritte

- Identifizieren Sie ein Pilotprojekt – Finden Sie einen Geschäftsprozess, bei dem KI einen Mehrwert schaffen kann.

- Entwickeln Sie einen Proof of Concept – Fangen Sie klein an, testen und verfeinern Sie Ihren KI-Agenten.

- Integrieren und Skalieren – Implementieren Sie KI in Ihren Arbeitsablauf und optimieren Sie ihn auf Grundlage der realen Nutzung.

- Bleiben Sie vorne – Bleiben Sie über die Fortschritte in der KI auf dem Laufenden, um wettbewerbsfähig zu bleiben.

Die KI-Revolution ist da, und diejenigen, die Wer es jetzt nutzt, wird die Zukunft der Wirtschaft prägen. Lassen Sie uns gemeinsam Innovationen entwickeln und KI-gestützte Lösungen entwickeln, die Abläufe transformieren, das Kundenerlebnis verbessern und den Erfolg vorantreiben.

🚀 Bereit, Ihre KI-Reise zu beginnen? Kontakt SmartDev Melden Sie sich noch heute an und bringen Sie KI-gestützte Automatisierung in Ihr Unternehmen!

—

Verweise

- Gartner stellt drei Technologien vor, die Kundenservice und -support bis 2028 verändern werden | Gartner

- Wie Einzelhändler mit den Verbrauchern Schritt halten können | McKinsey & Company

- Mit GPT-4.5 stolpert OpenAI über seine eigenen AGI-Ambitionen | Wired

- Ein allgemeiner KI-Agent für virtuelle 3D-Umgebungen | Google Deepmind

- Im Kampf der KI-Agenten strebt Meta nach totaler Dominanz, da OpenAI plant, für einige Modelle $20K zu verlangen | Inc.